本篇的重點將是生成式 AI 的最高級應用之一:多模態內容的融合,特別是 AI 生成的影片和多媒體內容。這項技術正將靜態的創意元素,轉化為動態、敘事豐富的完整作品。

AI 影片生成:從文字到動態影像

這是目前生成式 AI 領域最前沿且發展最快的方向。模型不僅需要理解文字描述,還需要掌握時間、空間和運動的邏輯。

**文字到影片:

應用: 輸入一句話,例如「一隻穿著西裝的狗在咖啡店裡用筆記型電腦工作」,AI 就能生成一段短片。代表模型如 Sora (OpenAI)、Google Lumiere。

核心難點: 確保影片中的物體在時間上保持一致性(例如,狗的西裝不能突然改變顏色),這是對 AI 空間和時間理解能力的巨大考驗。

**圖像到影片:

應用: 上傳一張靜態圖片,並指示 AI 讓圖片中的特定元素動起來。例如,讓圖片中的湖水泛起漣漪,或讓人物的頭髮隨風飄動。

價值: 將現有的靜態素材轉化為引人注目的動畫,極大地提升了現有資產的再利用價值。

聲音與視覺的完美同步

真正的高品質多媒體內容,需要聲音與圖像之間達到毫秒級的同步和邏輯上的匹配。

**AI 自動配樂與音效:

應用: 影片生成後,AI 可以根據影片內容和情緒自動選擇或生成合適的背景音樂和環境音效。例如,如果畫面是暴風雨,AI 會自動加入雷聲和雨聲。

價值: 簡化了影片後製中的聲音設計流程,確保視覺和聽覺體驗的一致性。

**虛擬角色的口型同步 (Lip Sync):

應用: 將一段語音輸入給虛擬角色,AI 可以即時或準確地驅動角色的嘴部動作,使其與語音內容完美匹配。

價值: 這項技術是虛擬主播、動畫製作和 Deepfake 影片的核心技術之一,讓虛擬角色的呈現更加逼真。

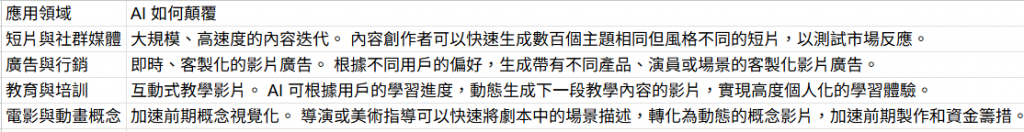

多媒體內容的應用與顛覆

AI 生成的影片和多媒體內容,正在對內容產業帶來巨大的效率提升。

走向「體驗」生成

AI 生成多媒體內容的趨勢,是從「內容生成」走向「體驗生成」。未來,AI 將不僅僅是生成一個單一的檔案,而是會生成一個完整的、可互動的、包含視覺與聽覺的沉浸式體驗,這將徹底改變我們消費和創造內容的方式。