聚焦於生成式 AI 的核心——大型語言模型 (Large Language Models, LLMs)。它們是 GPT-4 這類產品背後的驅動力,也是當前 AI 應用最廣泛的基石。

什麼是大型語言模型 (LLM)?

LLMs 是一種具有數十億甚至數萬億參數的神經網路模型。它們在極大量的文本數據上進行訓練,從而學會了語言的結構、規律、知識和上下文。

「大」在哪裡? 模型的參數數量巨大。更多的參數意味著更強大的記憶力、更複雜的邏輯推理能力和更細膩的語言捕捉能力。

核心原理: LLMs 的運作方式是預測下一個詞彙(Next Token Prediction)。透過不斷地預測下一個最有可能出現的詞彙,它們就能生成連貫、邏輯清晰且語法正確的長篇內容。

LLMs 的兩大陣營:封閉源與開源

當前 LLMs 的發展呈現出兩大主要的生態系統:

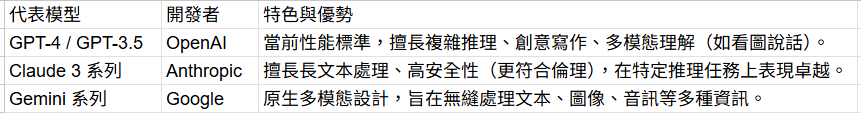

**封閉源模型 (Closed Source Models)

由科技巨頭投入巨額資金和計算資源訓練而成,通常性能最強大,但模型權重(Weights)不對外公開。

下圖為代表的模型

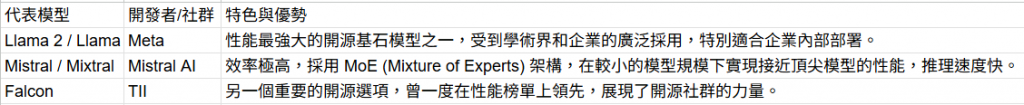

開源模型 (Open Source Models)

模型的權重對外公開,任何人都可以下載、研究、修改和部署。這推動了全球 AI 研究的加速和「民主化」。

下圖為代表模型

開源與封閉源 LLMs 的競合關係

封閉源 往往代表了性能的巔峰,引領技術突破和商業化應用。

開源 則代表了普及化和客製化。企業可以根據自己的數據和特定任務(如客服、法律文件分析)來微調(Fine-tune)開源模型,而無需將敏感數據上傳到第三方伺服器。

總體而言,LLMs 是生成式 AI 的大腦,無論是撰寫文本、生成程式碼,還是驅動複雜的 AI 代理,都離不開這些大型語言模型底層強大的語言理解和生成能力。