在 [魔法陣系列] AutoEncoder 之術式解析 裡介紹了 AutoEncoder 魔法陣以及其變形夥伴們,對於 AutoEncoder 應用只用寥寥幾句帶過覺得很可惜,這篇希望能夠針對 AutoEncoder 的應用場景更加詳細說明。

降維(Dimensionality reduction)

Dimensionality reduction was one of the first applicationsof representation learning and deep learning. It was one of the early motivationsfor studying autoencoders.

引用自 Ian Goodfellow 的《Deep Learning》一書

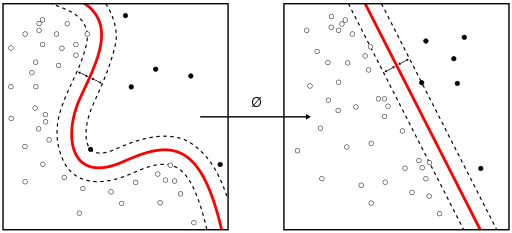

低維度的 representations 可以提高許多任務的效能,例如分類。較小的模型消耗較少的內存和運行時間。根據Salakhutdinov and Hinton 在《Semantic Hashing》一文中的觀察,許多降維的形式會將語義上相關的樣本置於彼此鄰近的位置,因此映射到低維空間所提供的訊息有助於泛化(generalization)。

圖片來源:https://en.wikipedia.org/wiki/Dimensionality_reduction

信息檢索

信息檢索(information retrieval)更是從降維中獲得幫助,除了可找到資料庫中類似查詢的條目外,也使某些低維空間中的搜尋變得更為有效率。這種信息檢索方法可以從方才上面提及的《Semantic Hashing》得到更詳細的資訊。

資料視覺化

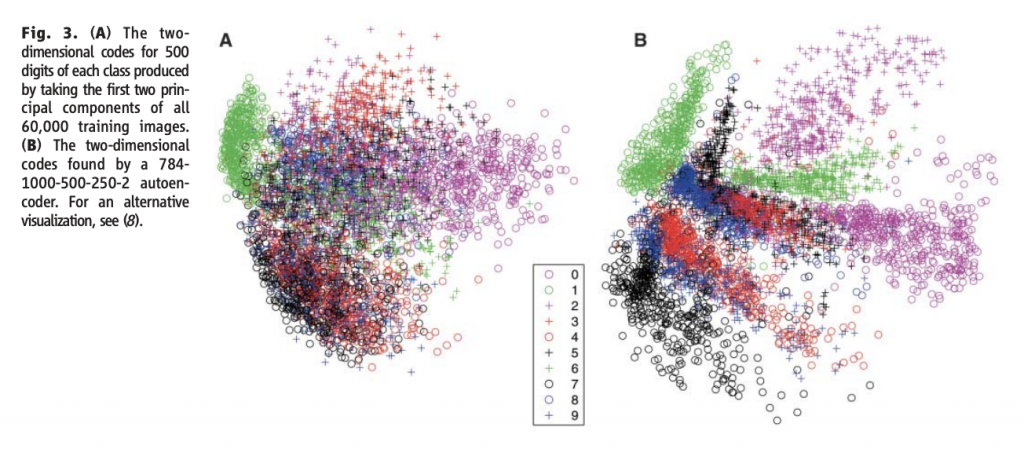

AutoEncoder 在配合適當的維度和條件下,能擁有比 PCA(主成分分析)更有意義的資料視覺化呈現。下面是 Hinton 在 2006 年發表的《Reducing the Dimensionality of Data with Neural Networks》中,將 MNIST 投影到二維的視覺化呈現對比:

圖片來源:https://www.cs.toronto.edu/~hinton/science.pdf

圖片來源:http://speech.ee.ntu.edu.tw/~tlkagk/courses/ML_2017/Lecture/GAN%20(v3).pdf

後續的文章將要推進到生成模型囉~目前已經累計20篇文,還剩下10篇就要結束了,在此給看到這篇文的你們大力鼓掌!

除了雷姆外,不要忘記拉姆唷。《Re:從零開始的異世界生活》 //圖片來源

莉森的喃喃:明天又是工作日的開始,下週工作滿滿,希望鐵人能有始有終。