之前有看過機器學習的歷史介紹,這個Google ML課程教學又說的更完整。

整個機器學習的發展歷程大概如下:

1800s Linear Regression(For predicting planets and pea growth)1940s Perceptron(Precursor to neural networks)1960s Neural Networks

1980s Decision Trees

1990s Kernel Methods(Support Vector Machines,SVMs)2000s Random Forests, Boosted Trees

2010s Neural Networks(again)在1800年代,Sir Francis Galton 率先使用統計方法測量自然現象,他在1877年發表關於種子的研究結果,指出迴歸到平均值(regression toward the mean)現象的存在,是回歸一詞的起源。

(1877年 Galton 的一次演講中展示的回歸線的第一張圖)

圖片來源

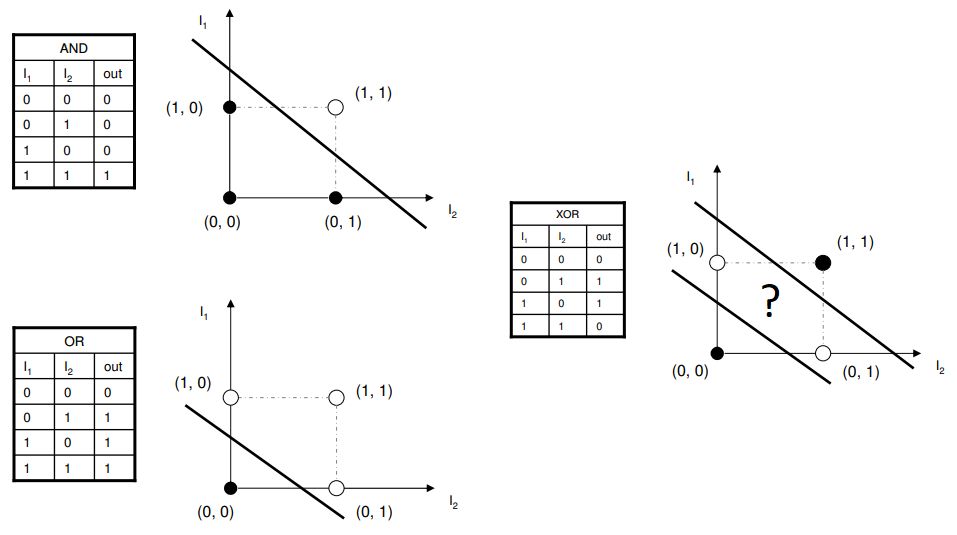

直到1940年代,Frank Rosenblatt 提出了一種感知器(Perceptron)作為人腦中神經元的計算模型,這是一種二元的線性分類器,我們會試圖找到一條線將數據分成兩類。

單層感知器是最簡單的前向神經網絡。將輸入值與權重算出總和。然後把總和通過我們今天稱為激活函數的函數。再將其輸出與閾值進行比較,然後確定每個點屬於哪個類。如果錯誤就再改變總和中使用的權重,並且該過程將一次又一次地發生直到收斂。

(圖的右邊 XOR 你無法用一條直線把白點跟黑點區分開來)

圖片來源

不過有學者如麻省理工學院著名計算機科學家 Marvin Minsky 研究指出,它無法學習非常簡單的功能,例如,XOR等線性不可分問題。雖然之後有學者了解到多層神經網絡能夠解決線性不可分的問題。但因為來不及推廣化解疑慮,所以大約15年間,沒有人願意資助人工智能。

圖片來源:Artificial neural network

人工神經網路的基本組成部分是感知器,是一組相互連接的節點,可以完成簡單的信號處理,其靈感來自大腦中神經元的簡化。每個圓形節點表示一個人工神經元,而箭頭則表示從一個人工神經元的輸出到另一神經元的輸入的連接。通常神經網路會有三層,輸入層(Input),隱藏層(Hidden)與輸出層(Output)。隱藏層裡的層數可能由1層或多層所組成。

補充:

這個圖片整理的蠻好的,裡面有幾個在最上面的列表裡。

圖片來源:基礎機器學習API圖鑑

好,第16天,完成。

參考

coursera - Machine Learning with TensorFlow on Google Cloud Platform 專項課程

coursera - Launching into Machine Learning

Sir Francis Galton

Introduction to linear regression analysis

感知器 wiki

Solving XOR with a single Perceptron