延續昨天的內容,今天會把回應的資料存到資料庫中~

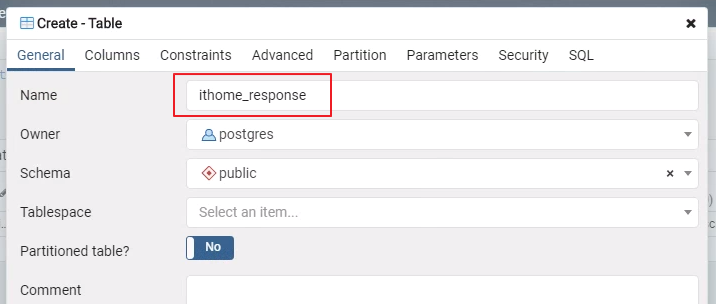

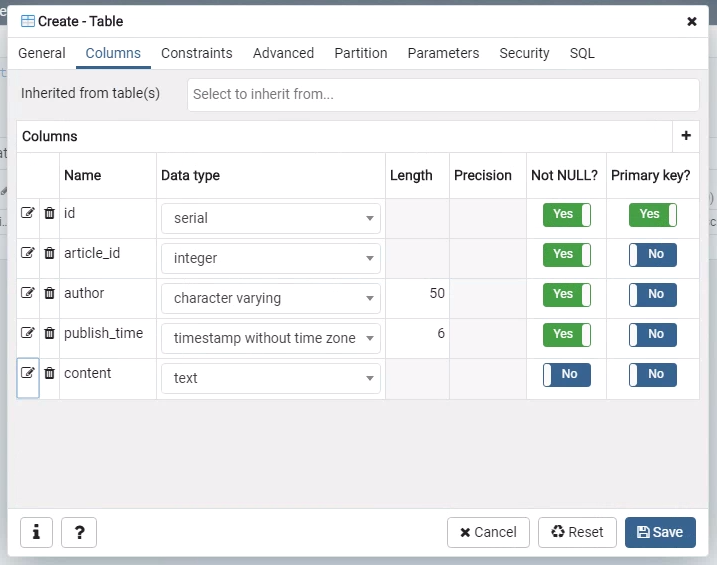

建立 ithome_response 資料表,並定位相關欄位如下:

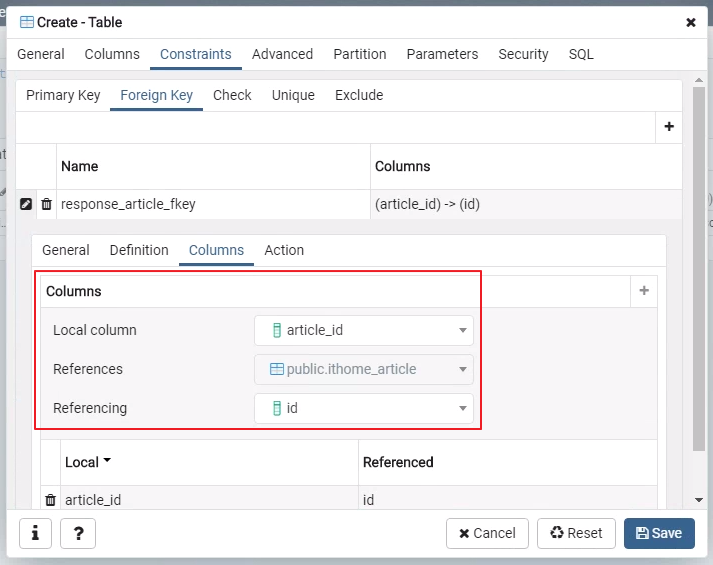

這張表比較需要注意的是有建立一個外來鍵,作為跟原文的關聯。

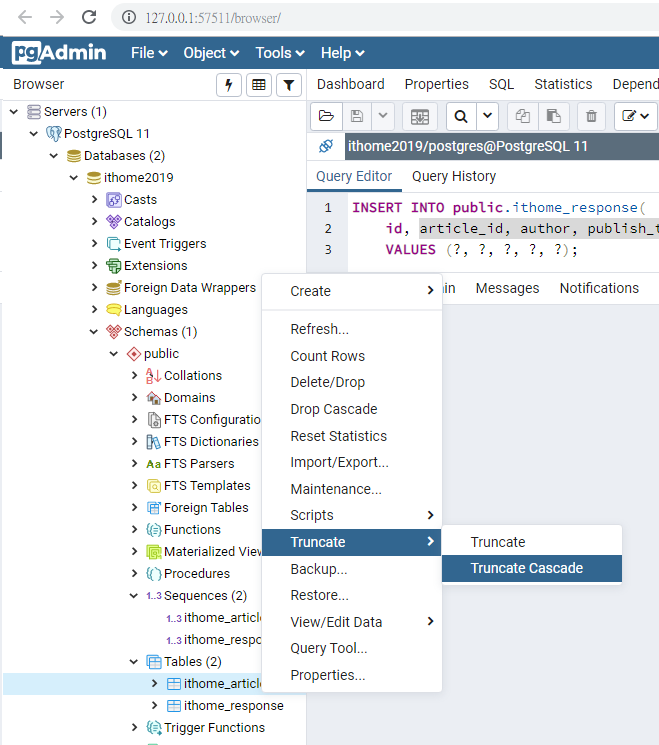

因為可能會有重複的資料,我們先清除昨天抓到的資料,明天會再說明怎麼過濾重複的資料。

今天的程式碼比較長,就不貼上來佔篇幅了,可以直接到 gist 上看。這邊會說明跟昨天的差異。

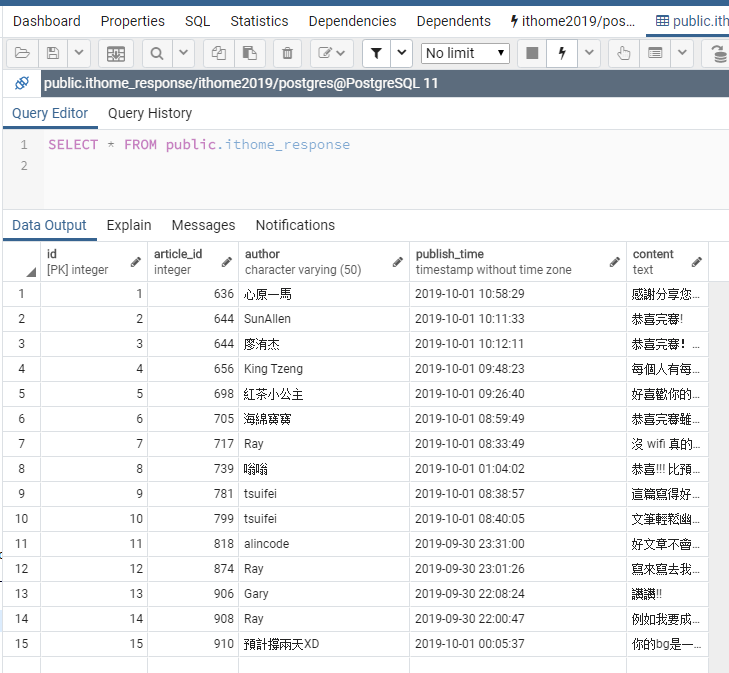

insert_article() 方法中修改了執行的 SQL 語法,讓資料庫回傳 sequence id 供回應的外來鍵使用。crawl_response() 方法,邏輯跟 Day 13 文章中相同。insert_response() 方法,把回應新增到資料庫中。執行程式後就可以在資料庫中看到抓下來的回應內容了!