我們從Precentron了解了神經元,進而從神經元組成神經網路,介紹了誤差函數(LossFunction),再講解了誤差函數

如何透過GradientDecent來Back Propergation整個神經網路,更新參數(也就是學習)。

現在我們已經大致上了解神經網路的原理和基礎,但是我們再訓練神經網路時,超參數的輸入也是重要的一環,

超參數和參數有什麼區別呢?超參數是我們輸入給神經網路,教他們應該要"怎麼學習",而神經網路在學習時更新的權重和偏差我們稱為"參數",舉例來說,我們知道Gradient Decent算法可以告訴神經網路,我們的參數往哪個方向走(該

加還是減)但是我們沒有告訴神經網路要走"多大步",這個告訴神經網路該走"多大步"就是超參數中的Learning Rate,

Learning Rate 很重要嗎?有時候Learning Rate太大我們"跨太大步"會直接把LossFunction的最小值"跨走",那麼

Learning Rate理當應該很小囉?設太小會造成你"走太小步",可能走到你老了LossFunction還沒找到最小值,

好了,那麼誰來告訴我我們應該要如何調整Learning Rate,不只是Learning Rate,訓練神經網路很多參數都是這

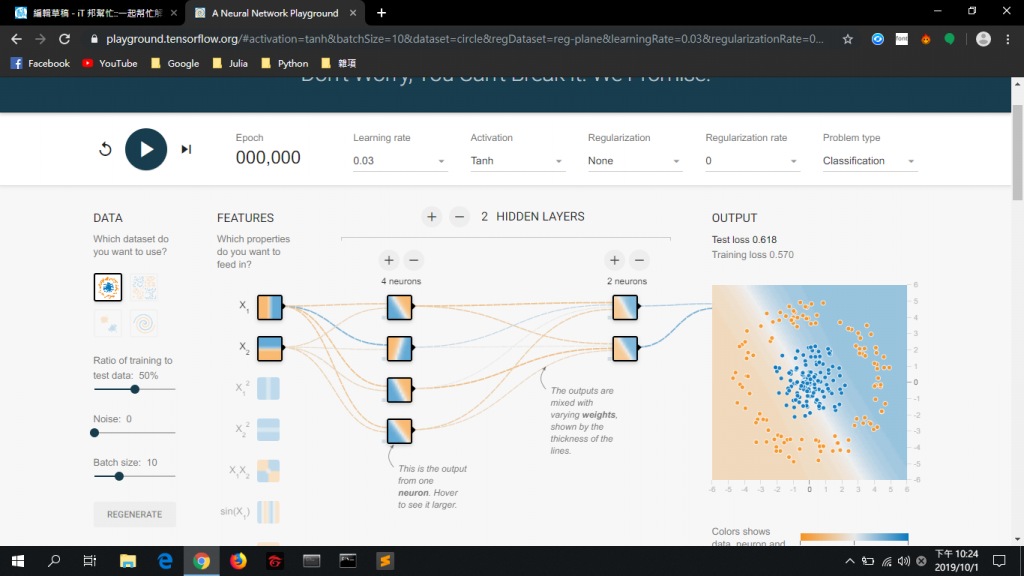

樣,需要根據經驗,我們如何獲得經驗?TensorFlow Playground提供了完全視覺化的神經網路來幫助我們實驗,

我們可以亂調各種參數來玩玩,看看神經網路學的如何!

重點是TensorFlow Playground大家都可以使用!只要在瀏覽器中搜尋TensorFlow Playground就好了!

看見了嗎?滿滿的參數給你設定,從一開始的資料分布狀況、資料的噪聲,訓練時的Mini-Batch-Size,

到神經網路要有幾層隱藏層,Learning Rate、Ativation Function、連一開始的資料規則化都有,

在這裡旁邊的圖點代表資料,而背景的顏色則是神經網路的預測,右邊的圖可以很明顯的看出,你的神經網路是

Under Fitting還是Over Fitting了,右上角的LossFunction也用圖表的方式來顯示,你可以實驗看看在不同的Learning Rate,Loss Function會快速的還是緩慢的變動,不只觀察變動還要看起伏大小!這些都可以幫助我們實

驗各種參數,讓我們更清楚的了解各種超參數對模型的影響。