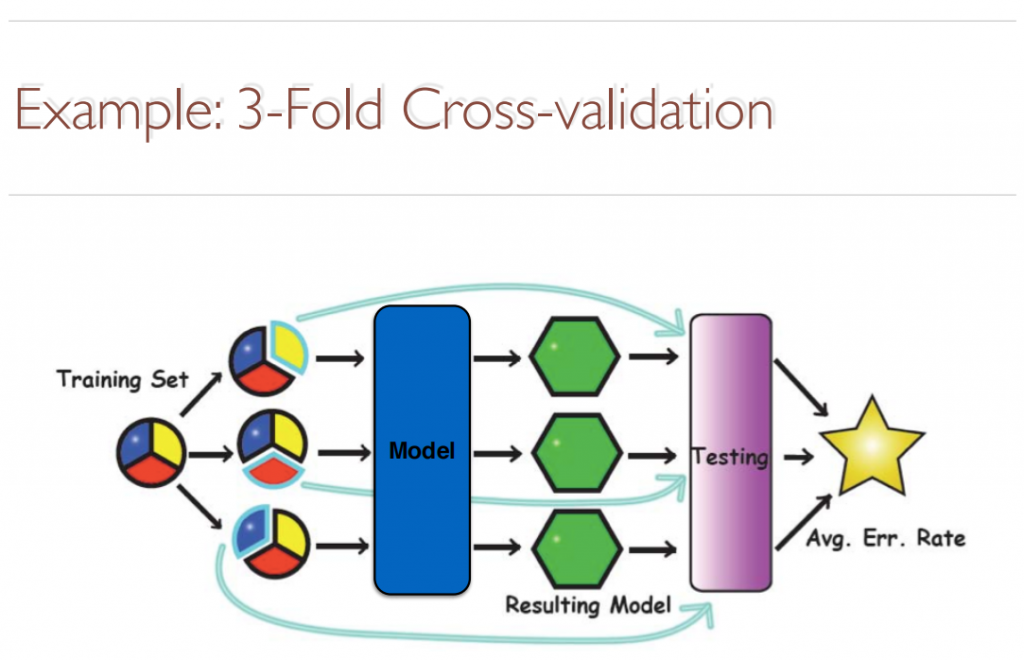

交叉驗證,有時亦稱循環估計,是一種統計學上將數據樣本切割成較小子集的實用方法。於是可以先在一個子集上做分析,而其它子集則用來做後續對此分析的確認及驗證。一開始的子集被稱為訓練集。而其它的子集則被稱為驗證集或測試集。交叉驗證的目的,是用未用來給模型作訓練的新數據,測試模型的性能,以便減少諸如過擬合和選擇偏差等問題,並給出模型如何在一個獨立的數據集上通用化

1.Cross-validation avoids overlapping test sets

2.Called k-fold cross-validation

3.Often the subsets are stratifified before the cross- validation is performed

4.The error estimates are averaged to yield an overall error estimate

下例說明 3 子集驗證 (k=3)

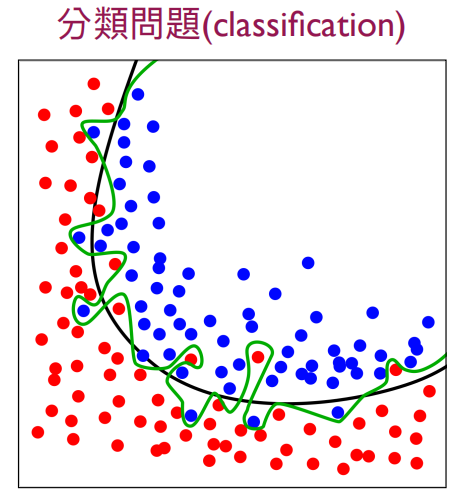

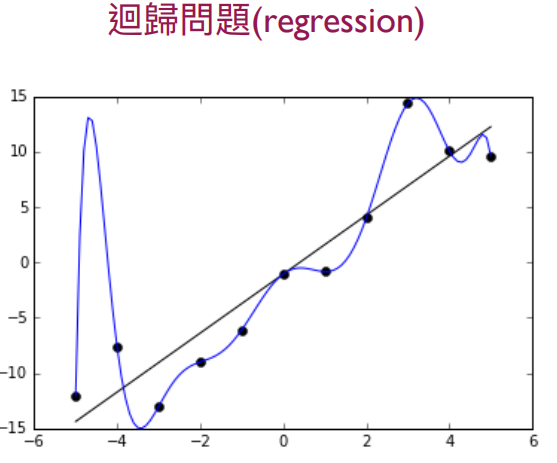

1.(wiki)在統計學中,過適(英語:overfitting,或稱擬合過度)是指過於緊密或精確地匹配特定資料集,以致於無法良好地調適其他資料或預測未來的觀察結果的現象。

2.(wiki)在統計學習和機器學習中,為了避免或減輕過適現象,須要使用額外的技巧(如模型選擇、交叉驗證、提前停止、正則化、剪枝、貝葉斯資訊量準則、赤池資訊量準則或dropout)。

3.以下綠線及藍線是overfitting