Overfitting是在執行任何模型的時候我們都要注意的問題,今天就來聊聊overfitting是什麼

任何資料都同時包含著"signal"和"noise",我們想建立一個模型來找出"signal"並預測目標,但如果模型過度複雜,就會把"noise"當成"signal",產生overfitting的問題。這裡可以想像成當我們在學習新的東西的時候,如果吸收理解就可以舉一反三(理想模型),但如果完全硬背,雖然可以根據記下的內容去正確的回答問題,但會無法應用在其他地方(overfitting)。

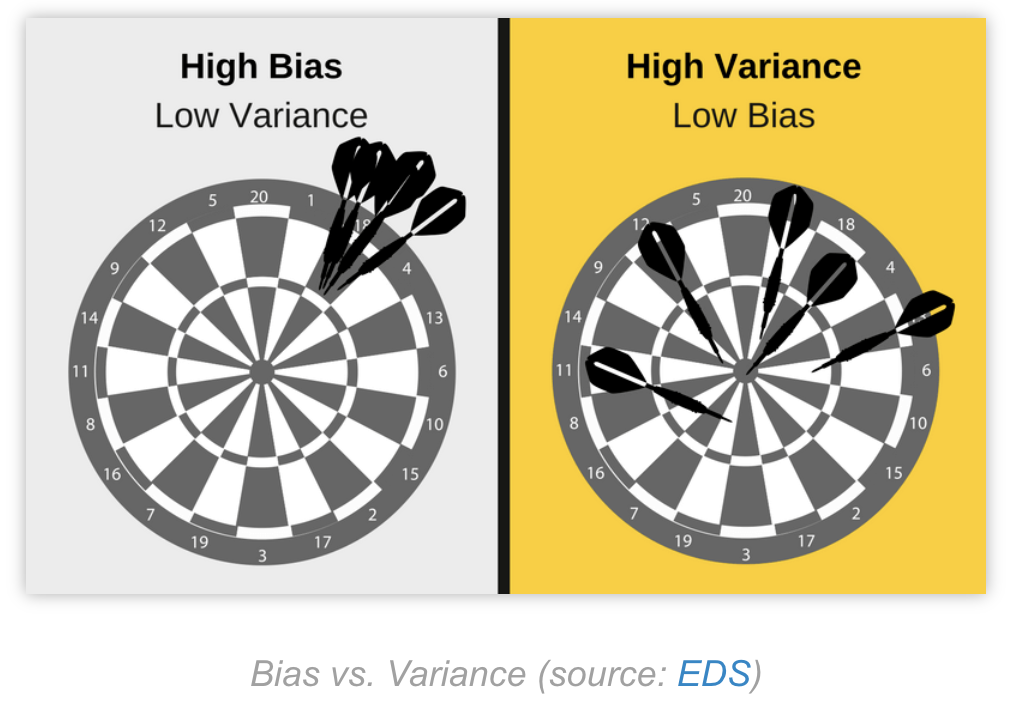

Underfitting則發生在當我們建立的模型過於簡單,模型無法透過所知來預測(也可以想成學得太少根本無法應用)。ML中有一個詞語叫做“bias-variance tradeoff”,其實就是在描述overfitting和underfitting的對比:當今天模型過度簡單(想像基本的linear regression),那預測出來的結果會很單一,導致bias大以及variance小;反之若模型過度複雜,那預測的結果bias小以及variance大。

references:

https://elitedatascience.com/machine-learning-iteration#micro