昨天跟各位分享了Autoencoder實現MNIST數據集圖像重建,而今天將會分享Autoencoder的各種應用層面,那我們廢話不多說,正文開始!

Autoencoder的主要目標是學習將輸入數據編碼為低維表示,然後從該表示中重建原始輸入數據,從而捕捉輸入數據的關鍵特徵,原本主要的應用在降維和資訊檢索,但隨著Autoencoder的進步,目前已經初先許多變體並應用在其他任務上。

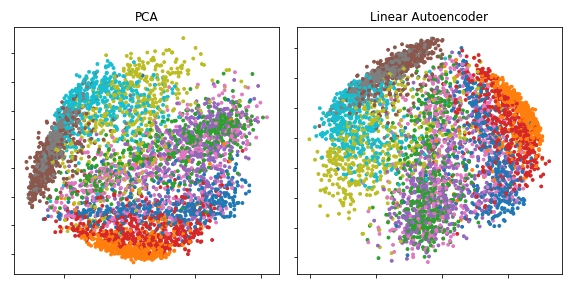

降維是深度學習的最早應用之一。在Hinton於2006年的研究中,他使用一堆受限玻爾茲曼機(RBM)來預訓練多層自動編碼器,然後使用它們的權重來初始化一個深度自動編碼器,逐漸減少隱藏層的大小直到30個神經元。由此產生的30個維度的編碼,比主成分分析(PCA)還具有較小的重建誤差,並且學到了在資料之間有明顯分離且較易解釋的結果。

圖源:維基百科

在某些低維空間中,搜索可以變得更有效,所以Autoencoder也可以應用在資訊檢索

Salakhutdinov和Hinton於2007年提出自動編碼器應用於semantic hashing,通過訓練該算法生成低維二進制code,可以將所有數據庫記錄存儲在hash table中,將二進制code向量映射到記錄。然後,這個表格可以通過返回與查詢相同二進制code的所有記錄,進行資訊檢索。

除此之外,Autoencoder也應用於搜索引擎優化

2019年,使用Autoencoder生成的分子在小鼠實驗中經過驗證。

自動編碼器已應用於機器翻譯,這通常被稱為神經機器翻譯(NMT)。與傳統的自編碼器不同,輸出與輸入不匹配。 在NMT中,文字被視為要編碼到學習過程中的序列,而在解碼器端生成目標語言的序列。 特定語言的自編碼器將進一步的語言特徵納入學習過程,例如中文分解特徵。

由於有更有效的方法,機器翻譯很少使用自編碼器進行。

參考連結:維基百科

以上就是小弟我今天分享有關於Autoencoder的各種應用,明天將會分享Autoencoder的變體—變分自編碼器(VAE),那我們明天見!