註:本文同步更新在Notion!(數學公式會比較好閱讀)

/ᐠ .ᆺ. ᐟ\ノ又到了快樂星期五晚上!今天來~

殘差網路(Residual Networks, ResNet)。ResNet 是卷積神經網路的一種變體,通過引入「殘差塊」(residual blocks),解決了深層網路中的訓練困難和梯度消失問題,並在許多計算機視覺任務中取得了突破性的成果。

為什麼需要殘差網路?

隨著神經網路的層數不斷增加,深層網路在理論上應該能夠學習更複雜的特徵。但當網路變得非常複雜時,會面臨兩個主要問題:

為了解決這些問題,殘差網路(ResNet) 引入了一種「殘差學習」機制。

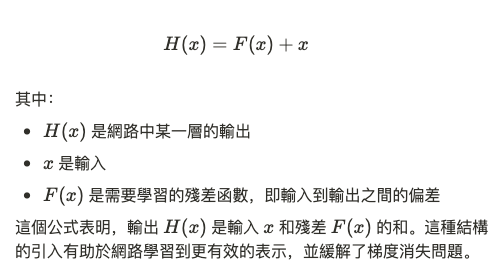

ResNet 的核心思想是:與其讓每一層直接學習輸入到輸出的映射,我們讓每一層學習殘差,即輸入和輸出的差異。數學上,可以將每一層的學習目標表達為:

即使卷積層的殘差學習效果不理想,網路也至少可以直接傳遞輸入,這樣可以確保模型的性能不會因為層數過深而下降。

這樣的設計使得殘差網路可以方便地疊加更多層而不會遭遇退化問題

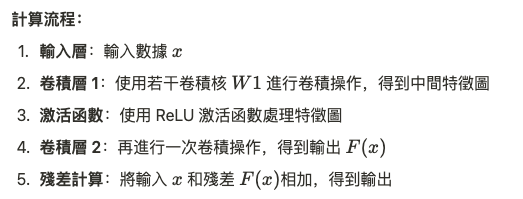

殘差學習 帶來了許多數值優勢:

ResNet 是第一個成功訓練超過 100 層的神經網路架構。其深度可以根據應用需求進行調整,常見的 ResNet 變體包括 ResNet-18、ResNet-34、ResNet-50 和 ResNet-101 等,數字表示網路中的層數。

殘差網路中的梯度傳播公式可以分解為兩部分:殘差的梯度和快捷連接的梯度。

證明梯度可以通過快捷連接直接傳回,從而避免梯度消失。

殘差網路(ResNet) 透過殘差學習機制,成功解決了深層神經網路中的梯度消失和退化問題。其簡單但高效的設計使得它成為許多深度學習任務中的首選架構。從數學角度,殘差網路通過快捷連接來保證梯度的有效傳播,從而提高了深層網路的可訓練性。