from google.colab import userdata

from huggingface_hub import login

# Login into Hugging Face Hub

hf_token = userdata.get('HF_TOKEN') # If you are running inside a Google Colab

login(hf_token)

# Install Pytorch & other libraries

%pip install "torch>=2.4.0"

# Install a transformers version that supports Gemma 3 (>= 4.51.3)

%pip install "transformers>=4.51.3"

使用 torch 和 transformers 程式庫,透過 Gemma 建立模型執行 pipeline 類別的例項。

import torch

from transformers import pipeline

pipeline = pipeline(

task="text-generation",

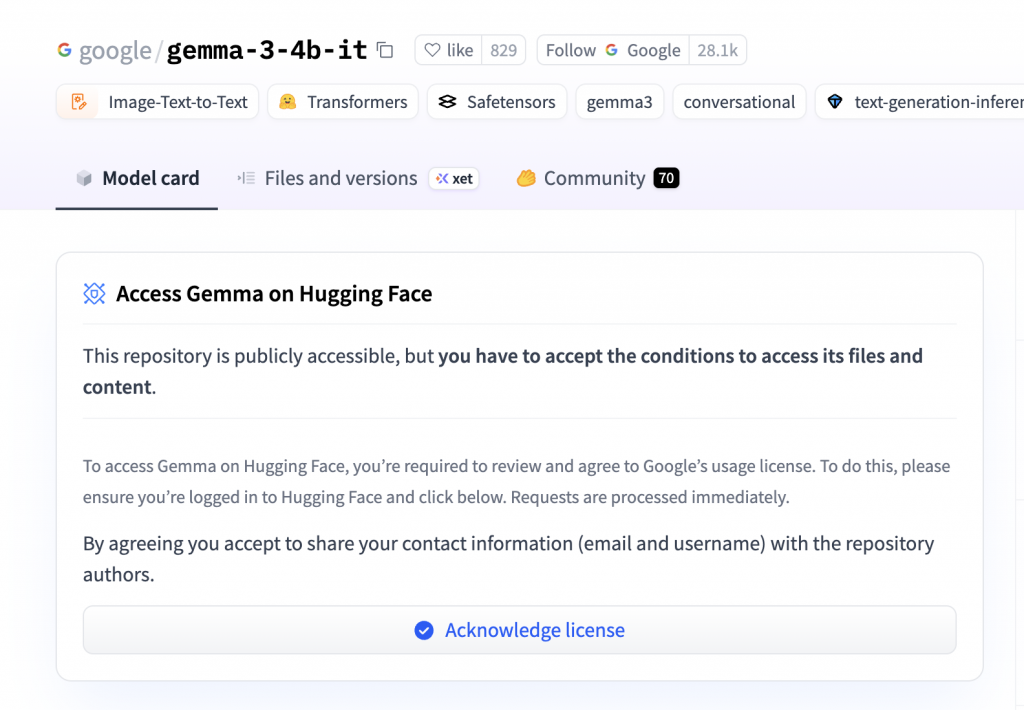

model="google/gemma-3-4b-it",

device=0, # "cuda" for Colab, "msu" for iOS devices

torch_dtype=torch.bfloat16

)

在 pipeline 物件中載入及設定 Gemma 模型後,即可將提示傳送至模型。以下程式碼範例顯示使用 text_inputs 參數的基本要求:

pipeline(text_inputs="gemma 家族 用繁體中文")

好的,以下是 Gemma 家族的繁體中文翻譯:

Gemma: 潔瑪 (Jié Mǎ) - 這是最常見的翻譯,也比較接近英文發音。

Gemma Pro: 潔瑪 Pro (Jié Mǎ Pro)

Gemma 2: 潔瑪 2 (Jié Mǎ 2)

Gemma 3: 潔瑪 3 (Jié Mǎ 3)

說明:

“Gemma” 這個名字本身就比較簡潔,所以翻譯時通常會保留原名,並加上一些中文的補充說明,例如“Pro”或數字,以區分不同版本。

希望以上翻譯對您有幫助!

Gemma 模型需要大量的 VRAM (GPU 記憶體) 和運算能力。免費版的 Colab 所提供的資源通常不足以運行

執行後 可能會出現 "所有可用的 RAM 皆已用盡,因此你的工作階段已停止運作。"哦