聽過 Function Calling 嗎?這個名詞是 OpenAI 在 2023 年 6 月提出的新概念,主要是讓 LLM 可以呼叫外部的 function 來取得資料或執行動作。不過這個概念並不是 OpenAI 獨有,其他的 LLM Provider 或是 AI Framework 也都有類似的功能,只是各自的實現方式不同。這也導致開發者在使用不同 LLM 或框架時,需要重新設計 Function Calling 的邏輯。因此,Antropic 就提出了一個新的標準出現,叫做 Model Context Protocol(MCP),故名思義,MCP 的目標是要讓 LLM 可以透過一套統一的方式來呼叫外部工具,以獲取更多的上下文。

補充說明

在其它領域也有類似 MCP 的概念,如區塊鏈的「預言機」,目的是讓區塊鏈可以與真實世界互動(歷史總是驚人的相似)。

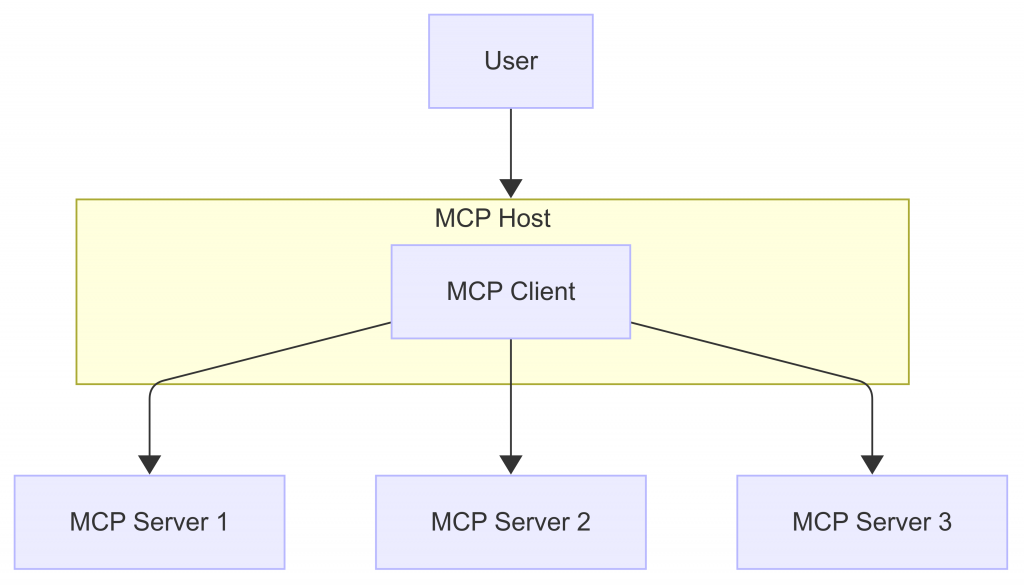

模型上下文協定(Model Context Protocol,MCP)是一種標準化的格式,用於描述 LLM 可以透過一套統一的方式來呼叫外部的 function 並取得資料或執行動作。