想像一家連鎖健身房設計預約系統。週五下午五點,數百位會員同時搶訂熱門教練的瑜珈課程。系統必須在毫秒內判斷名額、防止超賣、處理取消候補,還要確保每個人都能看到即時的預約狀態。更棘手的是,不同課程有不同的容量限制,某些會員享有優先預約權,還要處理跨時區的連鎖店預約。

這看似簡單的預約功能,背後隱藏著分散式系統最核心的挑戰:如何在高併發環境下維持資料一致性?如何優雅地處理時間衝突?如何在用戶體驗與系統效能間取得平衡?

今天,我們將深入探討活動預約系統的架構設計,從防止重複預約的資料庫策略,到處理爆量請求的快取機制,再到支援全球化服務的分散式架構,一步步建構出能夠應對各種挑戰的預約平台。

現代活動預約系統已經滲透到生活的各個層面:從餐廳訂位、醫療掛號、健身課程,到演唱會購票、飯店訂房。每個場景都有其獨特的業務規則,但核心挑戰是相同的:在有限資源下管理並發預約請求。

以一個綜合性活動平台為例,系統需要支援多種預約場景:

每種場景都需要不同的技術方案來優化用戶體驗與系統效能。

效能要求

可用性要求

擴展性要求

安全性要求

技術挑戰 1:競態條件與重複預約

在高併發場景下,多個用戶同時預約同一資源時,傳統的「讀取-檢查-寫入」模式會產生競態條件。當系統在檢查可用性與確認預約之間存在時間差,就可能導致超賣或重複預約。

技術挑戰 2:分散式事務管理

預約流程通常涉及多個服務:庫存服務、支付服務、通知服務。如何確保這些跨服務的操作要麼全部成功,要麼全部回滾,是分散式系統的經典難題。

技術挑戰 3:時區處理與週期性活動

全球化服務需要處理複雜的時區轉換,特別是跨越夏令時的週期性活動。如何確保「每週二 9:00 AM」在時區變更後仍然保持一致,需要精心的設計。

| 維度 | 單體架構 | 微服務架構 | 事件驅動架構 |

|---|---|---|---|

| 核心特點 | 所有功能在單一應用 | 按業務能力拆分服務 | 事件串聯業務流程 |

| 優勢 | 開發簡單、事務一致性強 | 獨立部署、技術多樣性 | 高度解耦、自然異步 |

| 劣勢 | 擴展困難、部署風險高 | 分散式複雜度、網路開銷 | 調試困難、最終一致性 |

| 適用場景 | 小型團隊、快速驗證 | 大型團隊、複雜業務 | 高併發、事件驅動業務 |

| 複雜度 | 低 | 中高 | 高 |

| 成本 | 低(初期) | 中(持續) | 高(初期) |

架構重點:

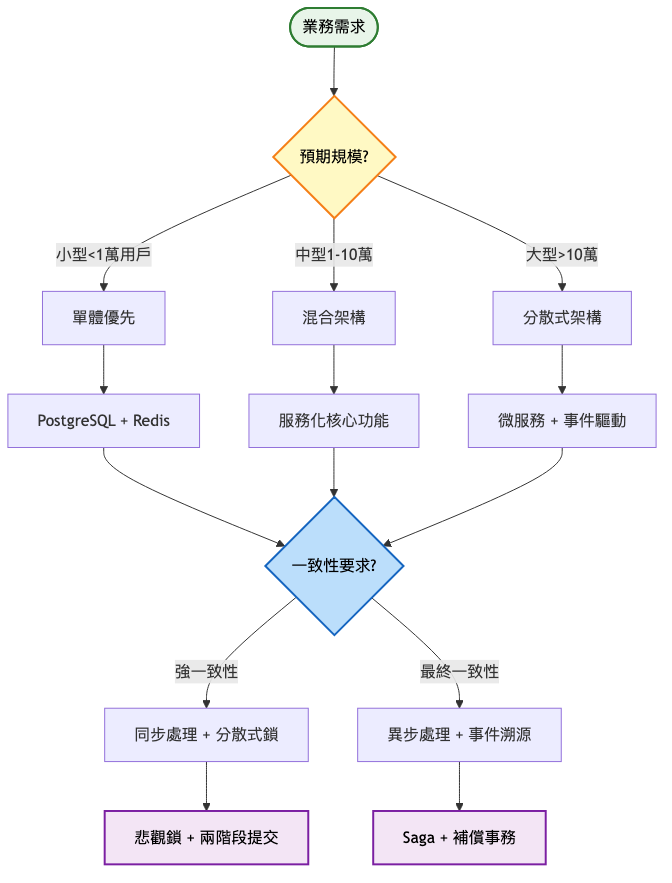

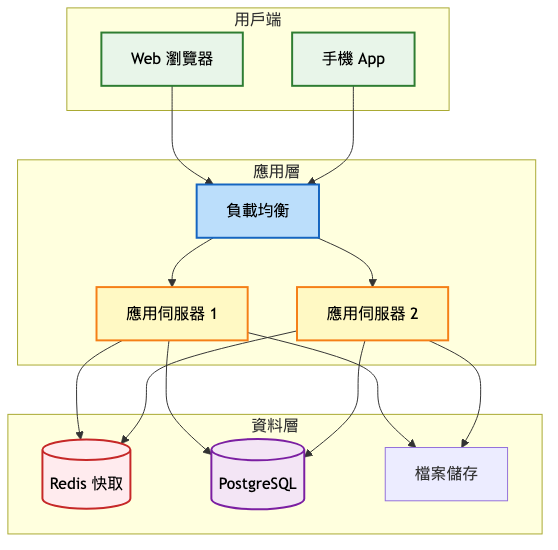

系統架構圖:

為什麼這樣設計:

架構演進重點:

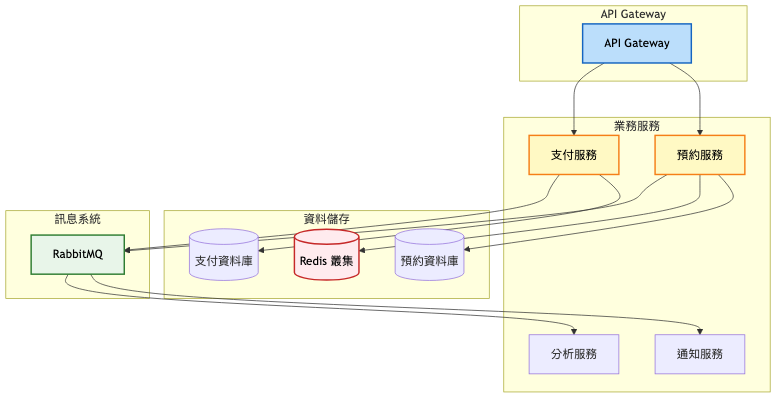

關鍵架構變更:

服務拆分策略

異步處理機制

系統架構圖:

預期效能提升對比表:

| 指標 | MVP階段 | 成長期 | 改善幅度 |

|---|---|---|---|

| API 回應時間 (P95) | 500ms | 200ms | -60% |

| 併發處理能力 | 100 req/s | 1000 req/s | 10x |

| 快取命中率 | 60% | 90% | +50% |

| 部署時間 | 45 分鐘 | 15 分鐘 | -67% |

| 故障恢復時間 | 30 分鐘 | 5 分鐘 | -83% |

企業級架構特點:

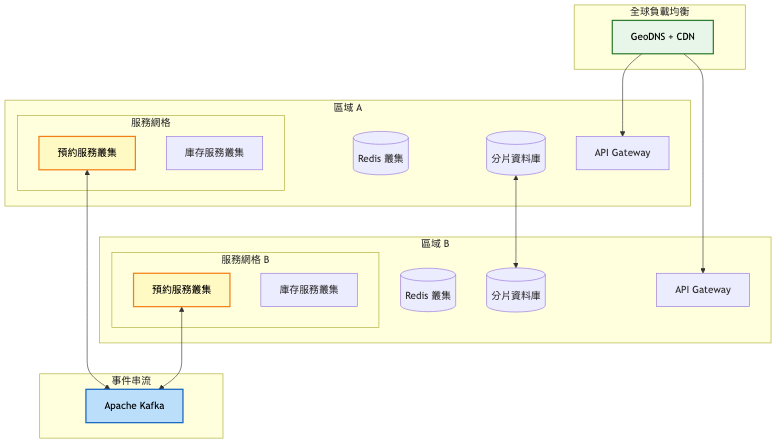

系統架構圖:

關鍵架構變更:

多區域部署

事件驅動架構

服務網格引入

架構設計考量:

高可用性設計

擴展性規劃

營運效率

階段演進總覽表:

| 架構特性 | MVP階段 | 成長期 | 規模化 |

|---|---|---|---|

| 架構模式 | 單體應用 | 服務化拆分 | 微服務+事件驅動 |

| 資料庫 | 單一 PostgreSQL | 讀寫分離+分庫 | 分片叢集+多區域同步 |

| 快取策略 | 簡單 Redis 快取 | Redis 叢集 | 多層快取+邊緣快取 |

| 部署方式 | 雙機器備份 | Docker 容器化 | Kubernetes 編排 |

| 用戶規模 | < 1千 | 1千-10萬 | 10萬+ |

演進決策指南表:

| 觸發條件 | 採取行動 | 預期效果 |

|---|---|---|

| 單機 CPU > 70% 持續 | 增加應用伺服器,引入負載均衡 | 降低單機負載至 40-50% |

| 資料庫連線數 > 80% | 實施讀寫分離,增加從庫 | 讀請求分散,主庫負載降低 50% |

| API 回應時間 > 500ms (P95) | 引入 Redis 快取層 | 回應時間降至 < 200ms |

| 部署時間 > 30 分鐘 | 服務拆分,獨立部署 | 單服務部署時間 < 10 分鐘 |

| 預約失敗率 > 1% | 實施分散式鎖+預留模式 | 失敗率降至 < 0.1% |

| 跨區延遲 > 100ms | 多區域部署+資料同步 | 本地區延遲 < 20ms |

| 技術選項 | 優勢 | 劣勢 | 適用場景 |

|---|---|---|---|

| PostgreSQL | ACID 完整性、豐富功能、成熟生態 | 垂直擴展限制、複雜分片 | 中小型系統、強一致性需求 |

| MongoDB | 靈活 Schema、水平擴展、地理分片 | 事務支援較弱、記憶體消耗大 | 快速迭代、文件型資料 |

| Cassandra | 線性擴展、高寫入性能、多資料中心 | 最終一致性、查詢限制 | 海量資料、時序資料 |

| DynamoDB | 全託管、自動擴展、預測性能 | 廠商鎖定、成本較高 | 無伺服器架構、變動負載 |

| 技術選項 | 優勢 | 劣勢 | 適用場景 |

|---|---|---|---|

| Redis | 豐富資料結構、持久化選項、Lua 腳本 | 單執行緒限制、記憶體成本 | 通用快取、分散式鎖 |

| Memcached | 簡單高效、多執行緒、低延遲 | 功能簡單、無持久化 | 純快取場景 |

| Hazelcast | 分散式計算、自動分片、近快取 | 學習曲線陡峭、社群較小 | 計算密集型快取 |

過早優化陷阱

分散式事務陷阱

快取一致性陷阱

案例:Airbnb 的預訂系統演進 參考文章

初期(2008-2012)

成長期(2012-2018)

近期狀態(2018-現在)

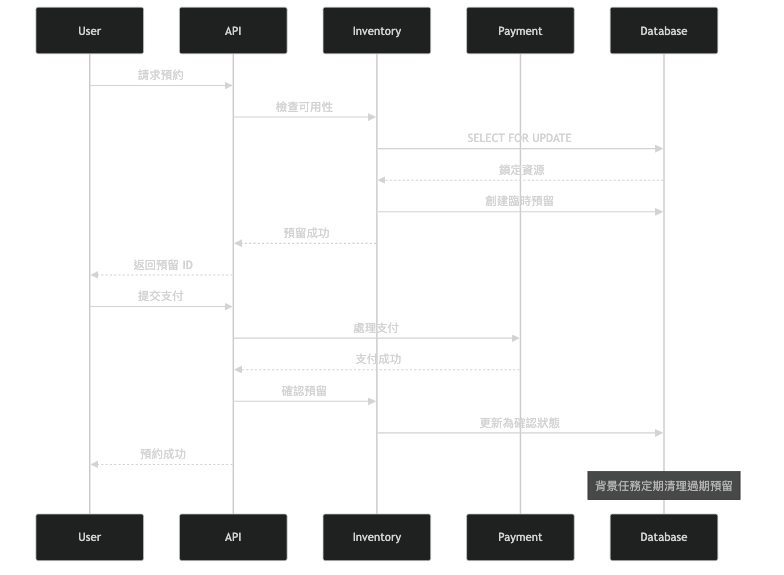

預留模式是解決併發預約的優雅方案。系統先創建臨時預留(通常 10-15 分鐘),給用戶時間完成支付,過期自動釋放。

實施要點:

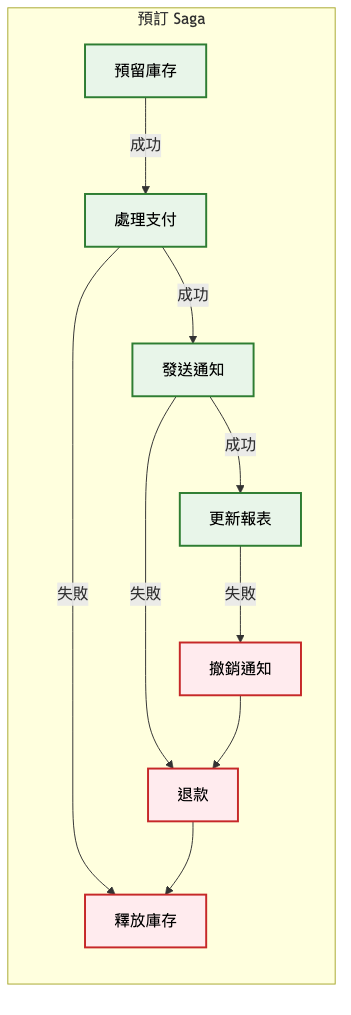

Saga 將長事務拆分為多個本地事務,每個都有對應的補償操作。

技術指標:

業務指標:

自動化策略

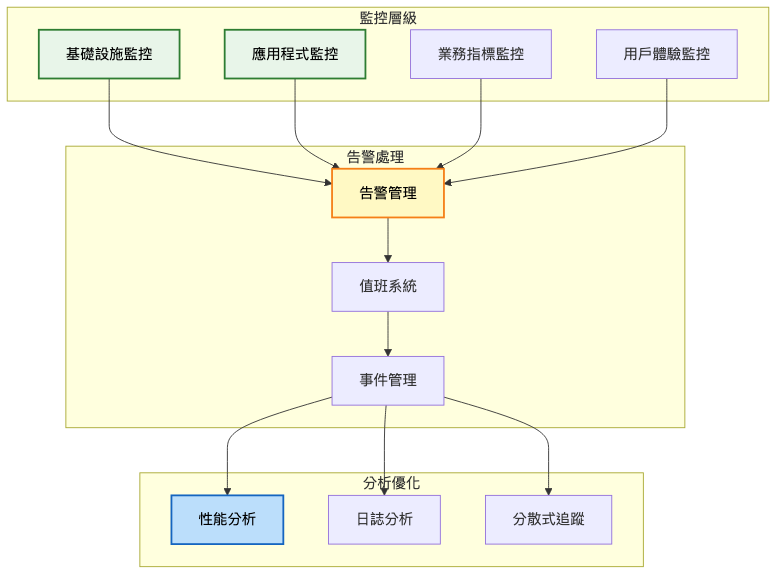

監控告警

持續優化

針對今日探討的活動預約系統設計,建議可從以下關鍵字或概念深化研究與實踐,以擴展技術視野與解決方案能力:

分散式鎖與一致性協議:透過深入學習 Redlock、Zookeeper、etcd 等分散式協調服務,掌握在分散式環境下實現資源互斥的核心技術。

時間序列資料庫與預測分析:探索 InfluxDB、TimescaleDB 在預約趨勢分析的應用,幫助實現動態定價與容量規劃。

WebRTC 與即時通訊技術:關注即時預約狀態推送、線上客服等即時互動功能的實現,提升用戶體驗。

Kubernetes Operator 模式:研究如何實現預約系統的自動化營運,包括自動擴縮容、故障自愈等進階功能。

可根據自身興趣,針對上述關鍵字搜尋最新技術文章、專業書籍或參加線上課程,逐步累積專業知識和實踐經驗。

明天我們將進入「搜尋引擎系統」的設計,這是另一個技術密集的領域。

我們會探討倒排索引的建構、相關性排序演算法、分散式搜尋的架構,以及如何在毫秒級回應時間內返回精準的搜尋結果。

搜尋不只是簡單的文字匹配,更是理解用戶意圖、提供智慧建議的複雜系統。準備好深入搜尋技術的核心了嗎?

iThome鐵人賽

iThome鐵人賽

看影片追技術

看更多

看影片追技術

看更多