在前面的文章中,我們大多依靠雲端的 OpenAI API 來開發應用,享受隨時更新與高效能運算的便利。不過,雲端並不是唯一的選擇。越來越多開發者與企業開始嘗試在本地端部署 LLM(Large Language Model),讓模型直接運行於自己的電腦或伺服器上。

那麼,為什麼要在本地跑模型?這樣做究竟帶來哪些優勢,又會面臨哪些挑戰?今天的文章,我們將一併探討本地 LLM 部署的價值與應用場景。

在設計 AI 應用時,選擇雲端 LLM 服務雖然能快速上線並降低初期門檻,但並非所有情境都適用。以下幾個面向我們是選擇本地部署時常見的考量因素:

隨著開源模型與硬體能力不斷提升,本地部署不再僅僅是嘗試性的選擇,而是越來越多應用場景中的務實方案。

雖然在本地運行模型有許多優勢,但實務上也存在不少挑戰,往往是開發者在落地應用時需要面對的現實考量:

因此,是否選擇本地部署,取決於應用的需求重點:若隱私與成本控制更重要,就值得投資;若追求最新效果與快速開發,雲端模型服務仍是更合適的選擇。

| 面向 | 雲端 LLM 服務 | 本地 LLM 部署 |

|---|---|---|

| 上手難度 | 開箱即用,只需 API Key 即可呼叫,維護需求低 | 需安裝環境、下載模型與配置硬體,維運門檻較高 |

| 資料隱私 | 資料需傳送至外部伺服器,存在外洩與合規風險 | 資料完全留在內部環境,更能符合隱私與法規要求 |

| 成本模式 | 按用量計費,初期成本低,但長期高頻使用下費用昂貴 | 前期需投入硬體,長期運行下推理成本更可控 |

| 網路需求 | 依賴穩定網路,延遲或斷線可能影響效能 | 可在離線或純內網環境運作,不受外部網路限制 |

| 模型選擇 | 受限於服務商提供的閉源模型,客製化彈性有限 | 以開源模型為主,可自由選擇版本、微調與量化 |

| 更新速度 | 由服務商維護,能快速接入最新模型與功能 | 需自行下載與整合,更新相對較慢 |

| 適用場景 | 適合快速上線、追求最新效果或希望降低維運負擔的情境 | 適合需要隱私保障、長期成本控制或低延遲的場景 |

本地部署 LLM 的方式大致可以分為 個人使用 與 企業部署 兩種情境。這兩者的需求與重點不同,因此選擇的工具與框架也有所差異。

對於個人開發者、研究者而言,重點在於能否快速下載模型並開始使用,而不是追求極致效能或高併發支援。因此,以下方案特別受到青睞:

這類方案通常不需要昂貴硬體,甚至在 Apple Silicon(M1/M2/M3)筆電上就能流暢執行中小型模型,非常適合個人學習與快速開發。

在企業環境中,需求不只是「能跑起來」,而是效能、穩定性、可維運性。這裡的重點是能否支撐多人同時使用、與既有系統整合、並保障資料安全。常見的框架與方案包括:

與個人使用相比,企業方案的重點在於可擴展性、資料隱私、維運成本控制。因此,除了單一推理引擎之外,往往還需要搭配監控、負載平衡、權限控管等完整基礎設施。

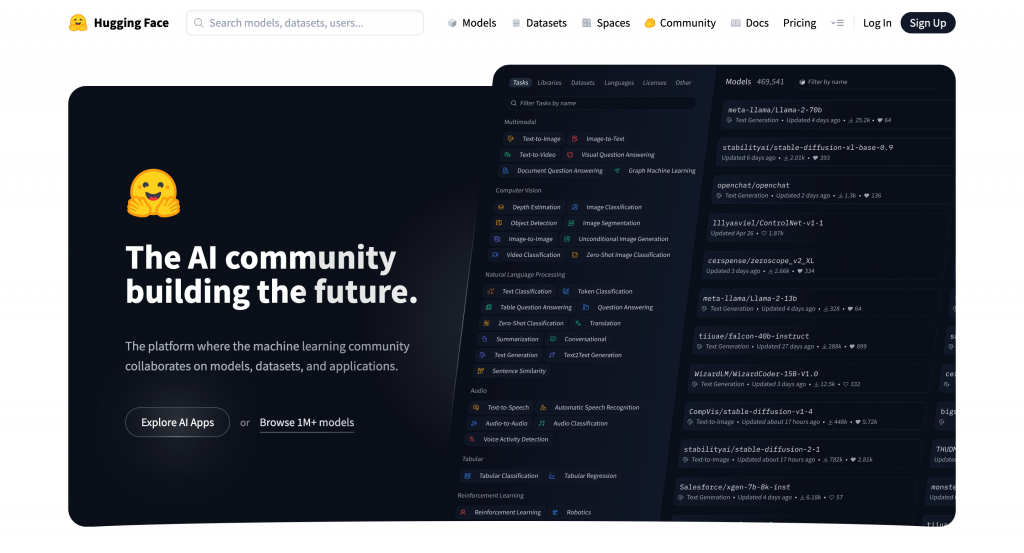

在談具體的模型之前,不能不提到 Hugging Face。它不只是全球最大的開源模型集散地,更逐漸成為生成式 AI 生態系的核心平台。幾乎所有主流的開源模型(如 Llama、Mistral、Gemma、Phi 等)都會第一時間在 Hugging Face Hub 上釋出,並透過統一的介面方便下載、部署與整合。

Hugging Face 的價值主要體現在以下幾個層面:

transformers 套件是開源社群的標準,支援 PyTorch、TensorFlow、JAX 等框架。搭配 datasets、peft(參數高效微調)、accelerate(分布式訓練推理),幾乎能覆蓋從研究到生產部署的完整工作流。對於本地部署而言,Hugging Face 扮演的是「模型來源」與「工具整合中心」的角色。無論你使用的是個人化的輕量工具(Ollama、LM Studio),還是企業級框架(vLLM、TGI),最常見的流程都是先到 Hugging Face Hub 找到合適的模型,再透過這些框架進行推理或微調。這也是為什麼它成為 AI 開發者日常工作中不可或缺的一環。

前面我們談過本地部署所需的工具與框架,但要真正落地,還必須搭配合適的「模型」。相較於商業化的閉源方案,開源模型讓開發者能夠完全掌握主導權。你可以依照硬體條件選擇不同規模的模型,透過量化降低資源需求,或進一步以自有資料進行微調,打造專屬的應用。同時,開源模型也減少對單一廠商的依賴,在隱私、法規遵循與長期成本控管上,都能提供更高的彈性與可持續性。

以下整理出幾個截至目前(2025 年 9 月)最受矚目的開源模型。它們各自有不同的定位與優勢,適合在不同應用場景中發揮所長。

Llama 由 Meta 推出,自 2023 年問世以來,一直是社群中最常用的基礎模型之一。發展到 2025 年的第四代,Llama 系列已經包含 Llama 4 Scout、Llama 4 Maverick 等版本,不僅支援更長的上下文,也首次具備多模態能力,能同時處理文字與圖像。

Llama 最大的優勢在於彈性:提供從中小型到大型的多種版本,讓開發者能依硬體資源自由選擇。開放權重的特性,讓研究者與企業能進行客製化微調,在效能與準確度之間取得平衡。多模態能力也拓展了使用範圍,像是文件處理、圖像理解與檢索整合。

Gemma 由 Google DeepMind 基於 Gemini 技術推出,主打「輕量化與易部署」。自 2024 年發表以來不斷迭代,最新的 Gemma 3 提供 1B 到 27B 不等的規模,讓開發者能依硬體能力選擇合適版本。

Gemma 的特色是效能與資源需求的平衡。它能在單卡 RTX 4090 或消費級 TPU 這類中小規模硬體上穩定運行,並提供量化版本降低記憶體需求。它也內建 function calling 與結構化輸出能力,對 AI Agent 與工作流程自動化的支援更加完善。

Mistral 是一家歐洲新創開發的模型,雖然規模相對較小,卻能展現媲美更大模型的效能。自 2023 年的 Mistral 7B 與後續的 Mixtral(Mixture of Experts 架構)問世以來,便受到研究機構與社群的高度關注。

Mistral 強調高效能與低成本,透過精簡架構與 MoE 技術,在推理速度與效能比上具有明顯優勢。特別適合需要快速回應、但硬體資源有限的應用場景,例如本地助理、程式生成或知識檢索。

Phi 系列由微軟推出,早期專注於小型語言模型的研究。到了 Phi-4,已經演進為多模態版本,能處理文字、圖像與語音輸入,定位也從實驗模型進化為跨模態應用的潛力選擇。

Phi-4 特別突出的地方在於邏輯推理與數學計算能力,即使在中小規模的參數下,也能在相關測試中展現不錯的表現。這讓它在教育、科研與專業應用(例如數理推導)中相當實用。由於資源需求較低,小團隊與研究者也能輕鬆採用。

DeepSeek 是中國新興公司推出的模型,其中 DeepSeek-R1 在 2025 年初引起廣泛討論。它以相對低廉的訓練成本,達到接近甚至超越部分商業模型的效能,成為「性價比」代表。

DeepSeek-R1 在數學、科學與醫療推理領域有不錯表現,展現強大的邏輯與專業能力。不過,它在語言流暢度、多語言支持與內容安全方面仍有不足,因此在企業應用時需要額外考慮合規與安全性。

Qwen 由阿里巴巴推出,自 2023 年起快速迭代,目前已發展到 Qwen2.5 與 Qwen3。系列涵蓋從 1.8B 到超過 200B 的規模,並提供 dense 與 MoE 架構版本,能滿足從個人研究到企業級部署的需求。

Qwen 的強項在於中文能力與多模態支援。相較於多數以英文語料為主的模型,Qwen 在中文處理上更為穩定。像 Qwen-Omni 版本,甚至具備完整跨模態處理能力,能應對文件檢索、語音對話與影像分析等多樣化任務。

GPT-OSS 是 OpenAI 在 2025 年推出的開源權重模型系列,包含 20B 與 120B 兩種規模。這是自 GPT-2 之後,OpenAI 首次再度釋出大規模開源模型,引發業界與研究社群高度關注。

GPT-OSS 採用 MoE 架構,在維持效能的同時降低資源消耗。20B 版本能在中階 GPU 環境下運行,而 120B 則針對高端資料中心。它在推理、程式生成與 Agent 任務上的表現相當突出,加上 Apache 2.0 授權,讓開發者與企業能更自由地商業化應用。

| 模型 | 規模 / 版本 | 主要特色 | 適用場景 | 授權 |

|---|---|---|---|---|

| Llama 4 | Scout(輕量)、Maverick(進階)等多版本,支援多模態 | 多模態(文字+圖像)、長上下文、社群資源豐富 | 研究、文件處理、多媒體應用、大型企業部署 | Llama 4 Community License(source-available;非 OSI 開源,含用途/規模限制) |

| Gemma 3 | 1B / 4B / 12B / 27B | 輕量化、多語言(140+)、量化版本可在單 GPU 或邊緣裝置上運行 | 個人學習、邊緣設備、多語言應用 | Gemma License(Google 自訂條款,非 OSI 開源;部分用途受限) |

| Mistral / Mixtral | 7B(dense)、Mixtral 8x7B(MoE)等持續更新版本 | 高效能 / 參數效率佳,社群活躍,支援量化與多種部署框架 | 消費級 GPU 部署、原型開發、實驗性應用 | Apache 2.0(開源,允許商業用途;部分衍生模型另有條款) |

| Phi-4 | 約 14B,含多模態 instruct 版本(文字+影像+音訊) | 推理能力強,在數學、邏輯、科學任務表現優異 | 複雜邏輯任務、多模態應用、教育與科研 | MIT License(寬鬆授權,可商用、可修改) |

| DeepSeek-R1 | 數十億參數級別,專注 reasoning | 高性價比,訓練成本低,在數學/科學推理基準測試表現突出 | 成本敏感應用(教育、科研)、強推理需求場景 | MIT License(寬鬆授權,可商用、可修改) |

| Qwen | Qwen2 / 2.5 / 3;1.8B ~ 235B(含 MoE、多模態版本) | 中文能力優異、多模態完整(文字、圖像、語音、影片)、長上下文靈活 | 中文應用、多媒體場景(文件、語音、影像)、企業部署 | Apache 2.0(允許商業用途與修改) |

| GPT-OSS | 20B(單 GPU 可運行)、120B(高階多卡環境) | MoE 架構,效能 / 成本平衡佳,擅長推理與程式生成 | Agent 開發、企業內部應用、程式輔助 | Apache 2.0(完全開源,允許商業用途) |

AI 模型的演進速度極快,新版本與新架構幾乎每隔幾個月就會問世。今天的主流開源模型,很可能在不久的將來就被更新的成果取代。因此,在規劃本地部署或挑選模型時,不僅要熟悉現有選擇,也應持續關注官方發布與社群動態,才能確保隨時掌握最新進展,並挑選出最適合自身需求的工具。

今天我們探討了 本地部署 LLM 的價值與挑戰,並整理了常見的工具、框架與開源模型選擇:

本地 LLM 部署並非要完全取代雲端,而是提供另一種選擇;如何平衡 隱私、成本、效能與靈活性,將決定你該選擇雲端、在地,或是混合式方案。