時間線又回到了神經網絡,現在透過算力和大數據的飛躍而具有更多的優勢。DNN作為深度學習的重要分支開始在許多方面(如電腦視覺、自然語言處理)大大勝過其他機器學習方法。除了硬體增強帶來的榮景之外,還有許多新的技巧和架構應用可幫助改善深度神經網路的可訓練性,諸如ReLU、更好的初始化方法、CNN或卷積神經網路和dropout。

這邊會談談ML方法中的一些技巧。我們在初次討論神經網絡時就談到說像是非線性激活函數(如ReLU),現在常默認為預設值。Dropout層開始被用來幫助進行泛化,其原理類似於集成方法,在討論隨機森林和提升樹(boosting trees)時我們進行了探討。添加了卷積層,由於它們的不完全連通性,從而減少了計算和內存負荷,並且能夠針對局部方面(如圖像),而不是其他相對無關的事物。

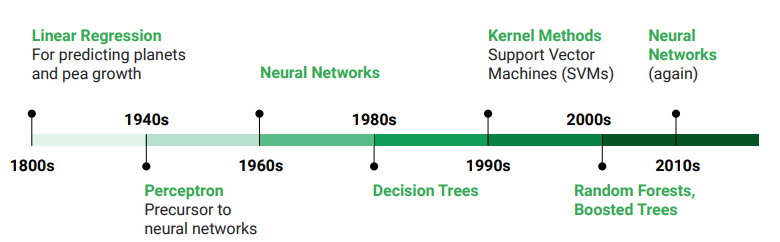

換句話說,其他ML方法帶來的所有進步都被利用到神經網絡中。機器學習的淵遠流長的歷史成就了目前深度學習的進展與成果。

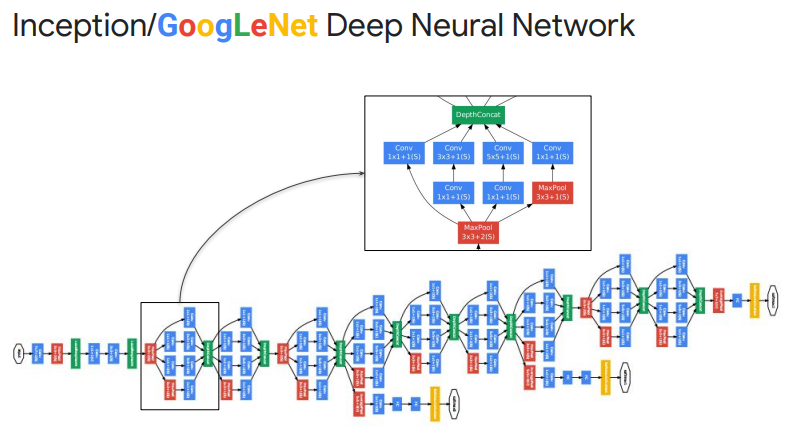

這裡看到的是GoogLeNet(或稱Inception),一個知名的圖片分類模型。它使用了2012年的數據並在2014年ILSVRC(ImageNet Large Scale Visual Recognition Challenge,ImageNet大量圖像辨識)的比賽中奪得冠軍,其中必須對一千個類別的圖片進行分類,其中包含對120萬張圖片進行訓練。