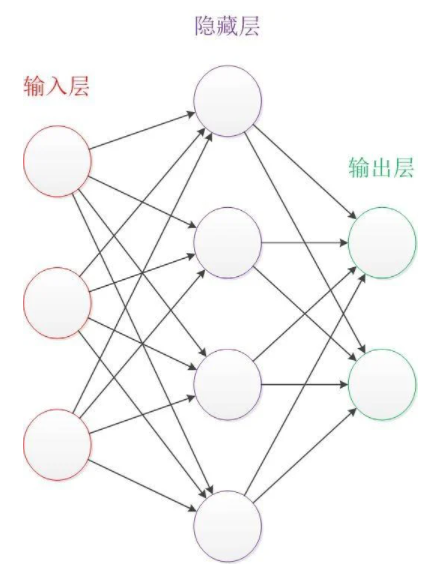

複習一下前幾天談的輸入層-隱藏層-輸出層。

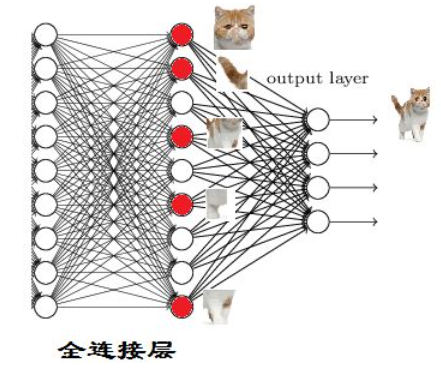

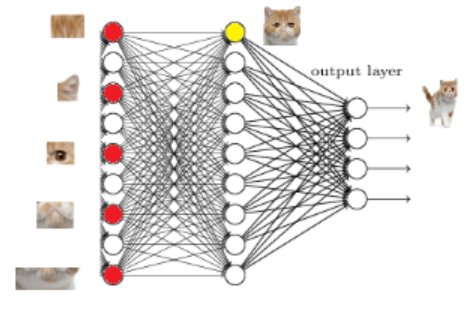

標準神經網絡(NN),深度學習本質上是神經網絡,各種神經網絡的基礎就是NN, 一個經典的神經網絡圖如下圖所示,這是一個包含三個層次的神經網絡,紅色的是輸入層,綠色的是輸出層,紫色的是中間層(也叫隱藏層)。輸入層有3個輸入單元,隱藏層有4個單元,輸出層有2個單元。

深度神經網絡(DNN),當隱藏層多於2時稱為深度,DNN與NN主要的區別在於把sigmoid函數替換成了ReLU。原文網址

註: sigmoid函數及ReLU為在類神經網路中使用的激勵函數,主要是利用非線性方程式,解決非線性問題,若不使用激勵函數,類神經網路即是以線性的方式組合運算,因為隱藏層以及輸出層皆是將上層之結果輸入,並以線性組合計算,作為這一層的輸出,使得輸出與輸入只存在著線性關係,而現實中,所有問題皆屬於非線性問題,因此,若無使用非線性之激勵函數,則類神經網路訓練出之模型便失去意義。深度學習激勵函數介紹

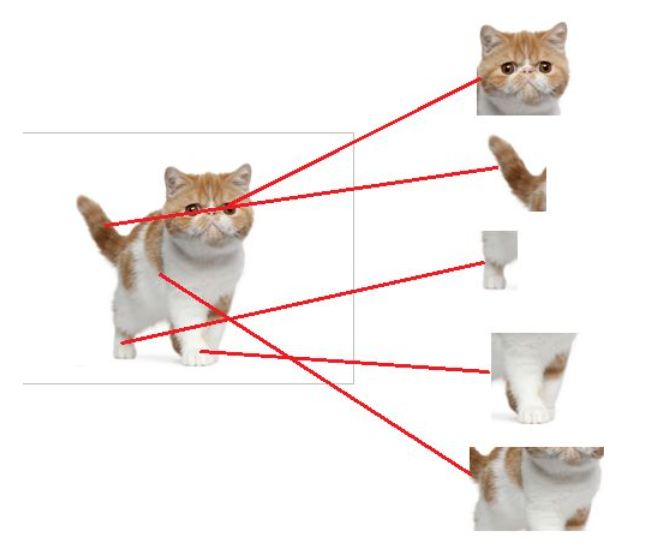

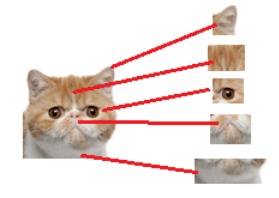

NN或DNN為一種模擬人腦神經系統的方式,它能將一維數據經過Full Connection並學習多次後歸納出該結果。同時,他們是AI發展中不可或缺的因素之一。可以想像,目前DNN常被使用。

參考: 什么是全连接层(Fully Connected Layer)