LSTM 在一個單一單元中要完成很多的操作。當使用更大的網絡時,與循環神經網絡RNN相比,訓練時間將顯著地增加。如果想要減少你的訓練時間,但同時也使用一個能記住長期依賴關係的網絡,那麼還有另一個替代LSTM網絡的方法,它被稱為門控循環單元(GRU)。

原文網址

LSTM 有個問題就是執行速度較慢,GRU 則是在 2014 年由韓國科學家 Kyunghyun Cho 在加拿大蒙特羅大學於 Yoshua Bengio 實驗室做博士後研究時所發表,用來加快執行速度及減少記憶體的耗用。

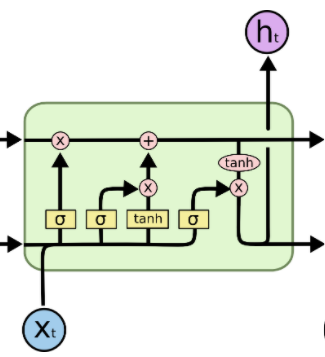

再看一下LSTM : Understanding LSTM Networks

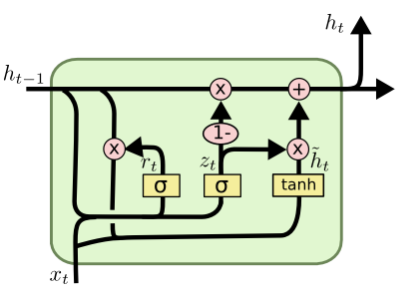

GRU 則將 LSTM 中的遺忘門 (forget gate) 與輸入門 (input gate) 用一個更新門 (update gate) 取代,並把單元狀態 (cell state) 和隱藏狀態 (ht) 進行合併,計算新資訊的方式和 LSTM 也有所不同。與LSTM網絡不同的是,GRU沒有單元狀態,並且有2個門而不是3個(忘記、更新和輸出)。

GRU使用一個更新門和一個重置門。更新門決定了應該讓多少之前的信息通過,而重置門則決定了應該丟棄多少之前的信息。 在上面的圖中,z_t表示更新門操作,通過使用一個sigmoid函數,我們決定讓哪些之前的信息通過。h_t表示重置門操作,我們將前一時間步驟和當前時間步驟的連接值與r_t相乘。這將產生我們希望從前一時間步驟中所放棄的值。

儘管門控循環單元在計算效率上比LSTM網絡要高,但由於門的數量減少,它在表現方面仍然排在LSTM網絡之後。因此,當我們需要更快地訓練並且手頭沒有太多計算資源的情況下,還是可以選擇使用門控循環單元的。

原文網址

這部影片link則用詳細的步驟來拆解 GRU,值得一看。

比較長短期記憶模型 (LSTM) 與改良後的遞歸神經網路模型:GRU