前幾天我們已經建立好了自己的 dataset 了,今天就要開始在 Azure Machine Learing(下稱AML)建立運算的資源啦!

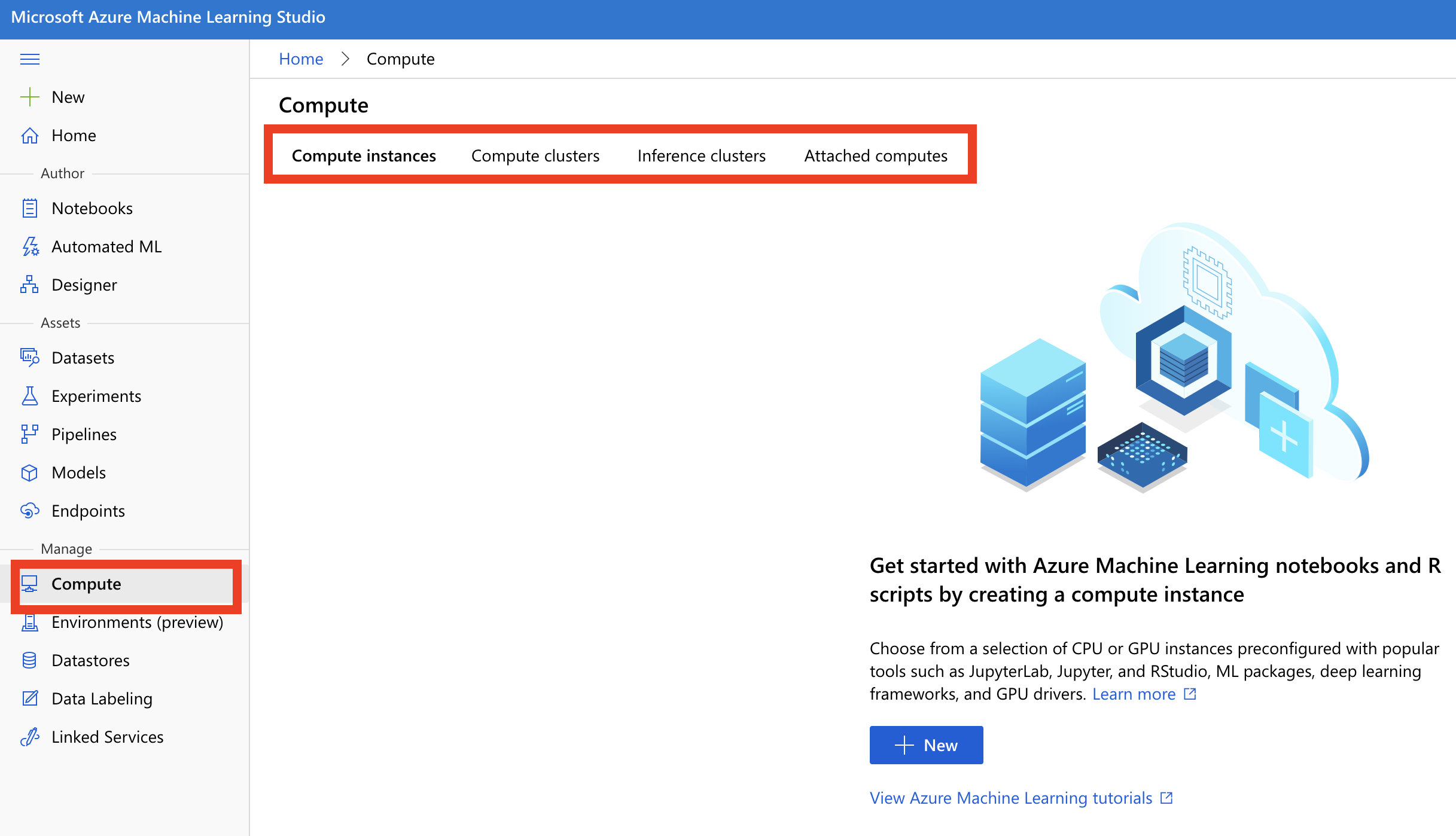

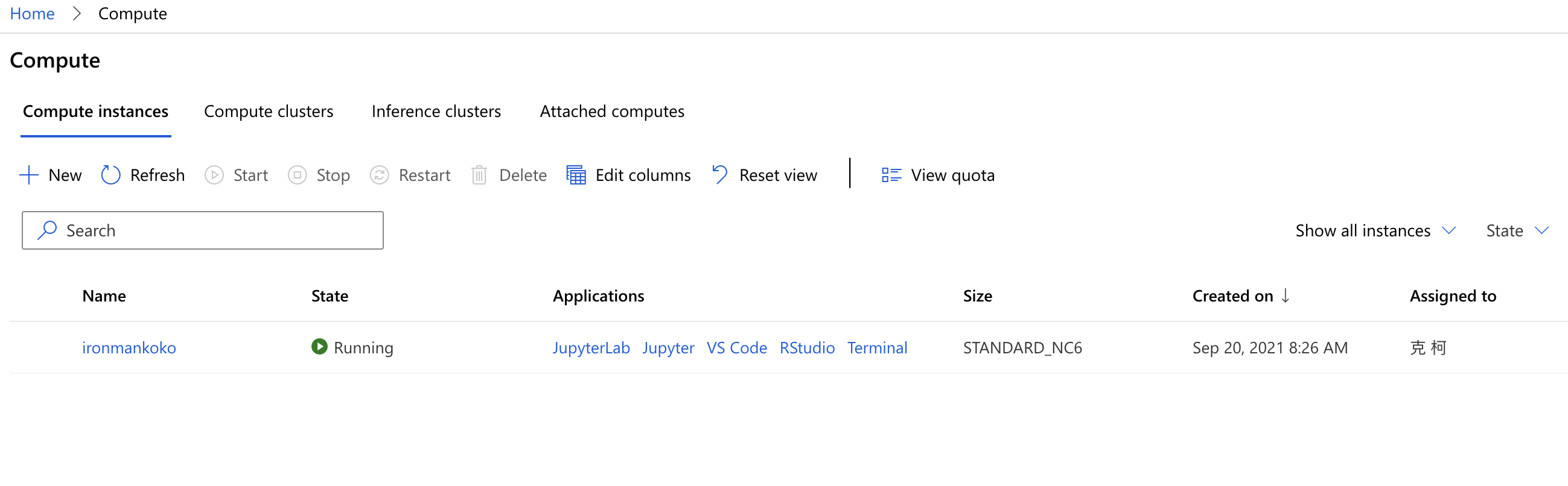

點擊左頁的 compute 頁面,如下圖所示,我們看到這個頁面上方有四個頁簽,分別是

我們來一一說明各項 compute 主要的差別是在哪裡:

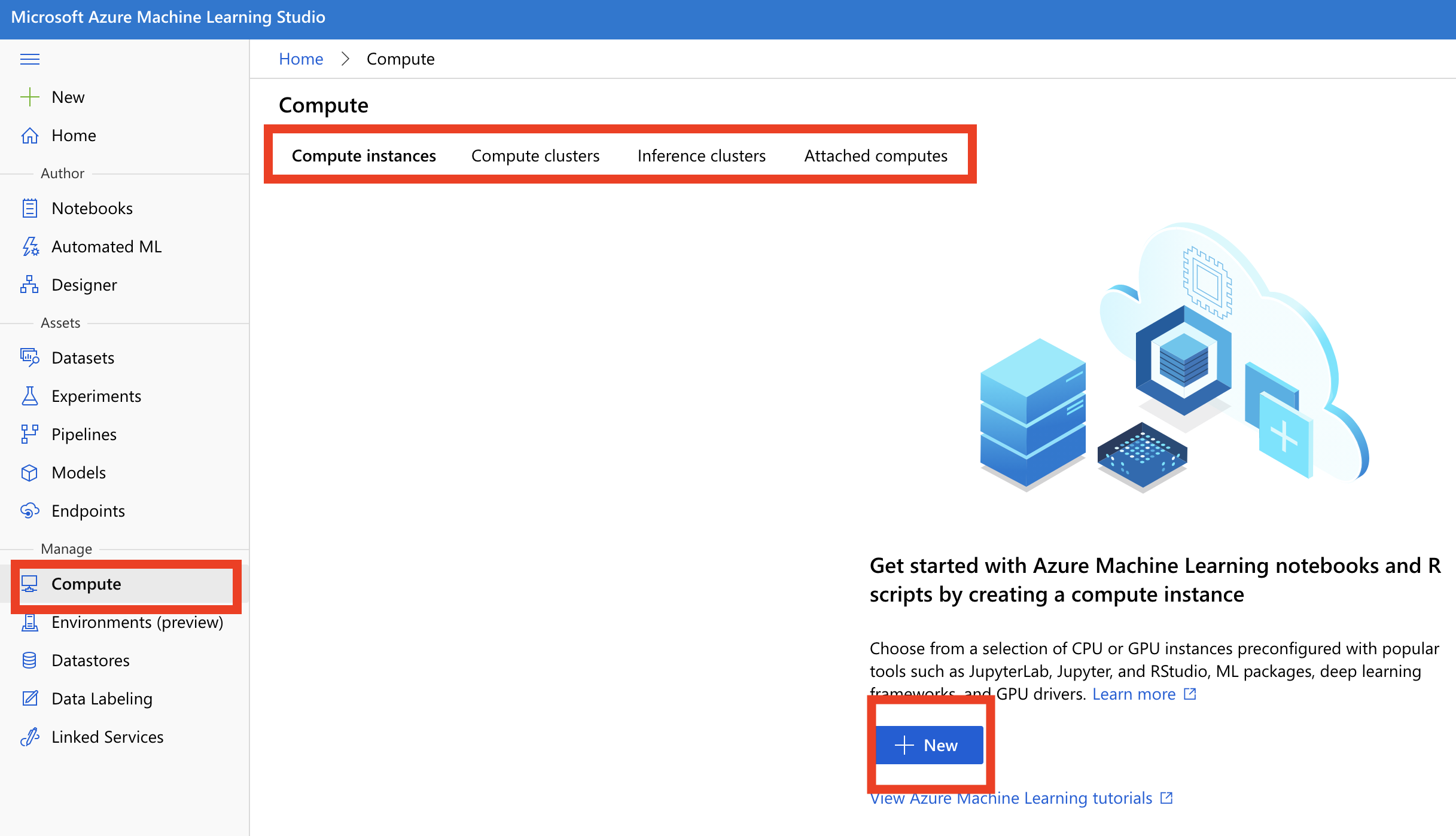

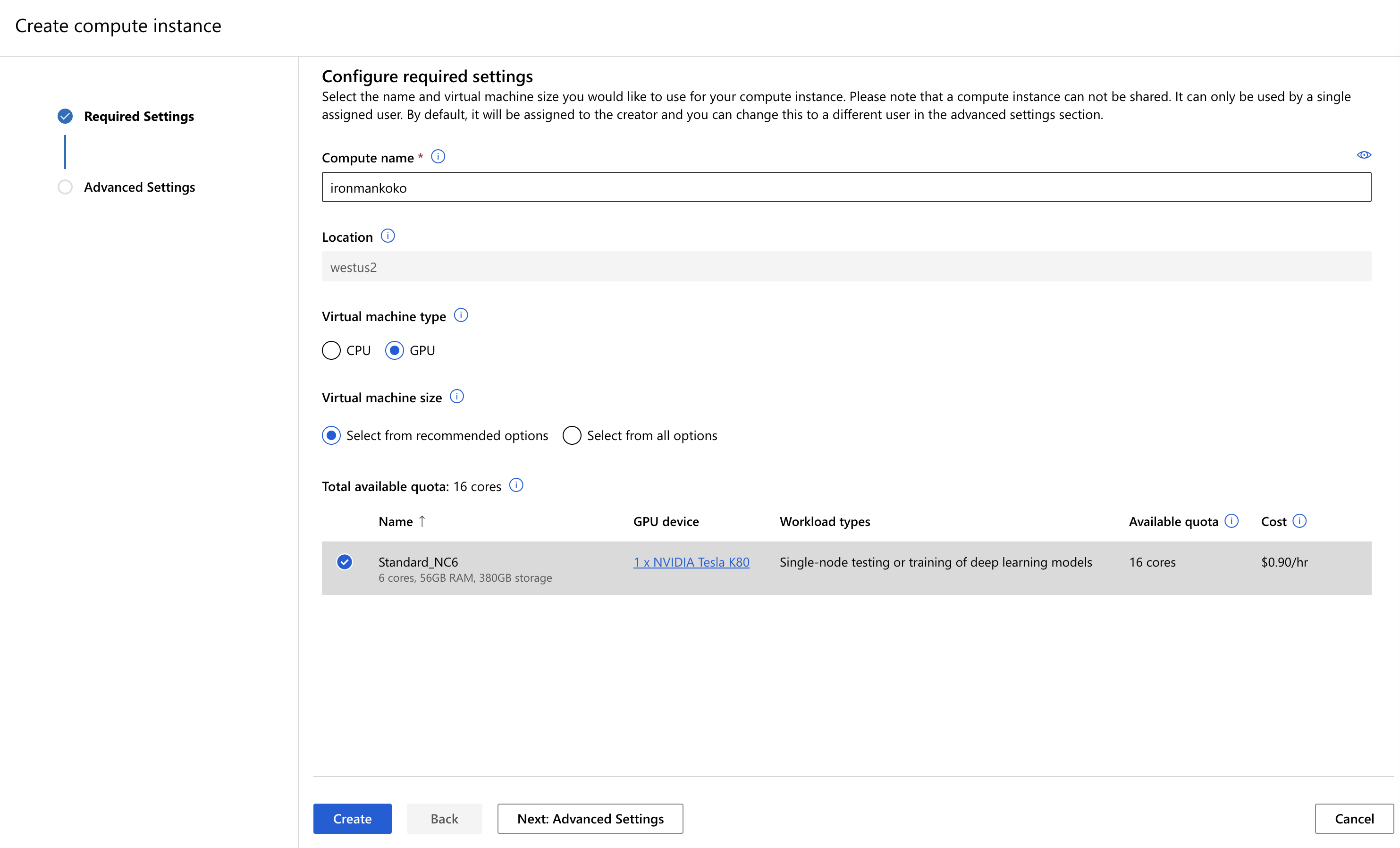

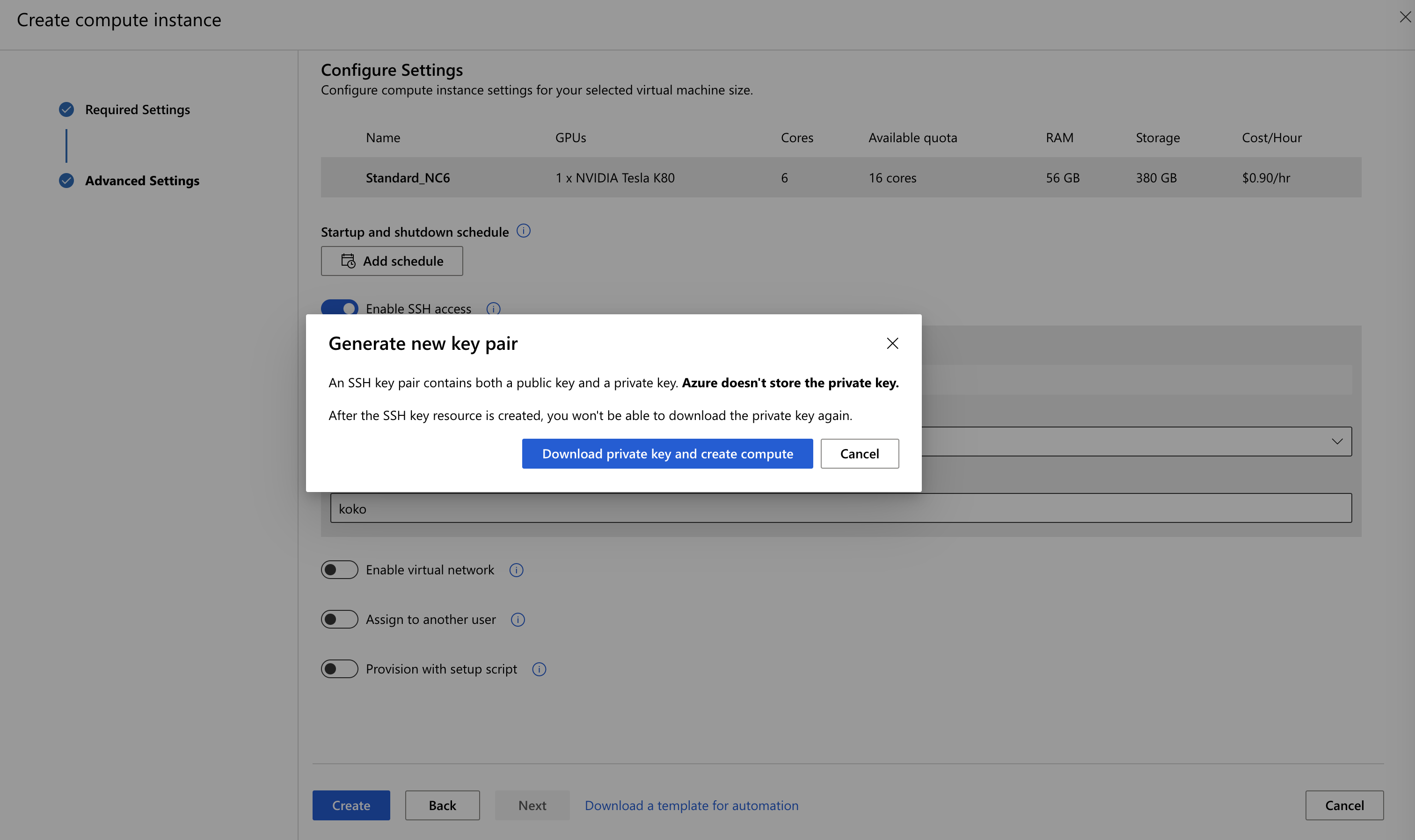

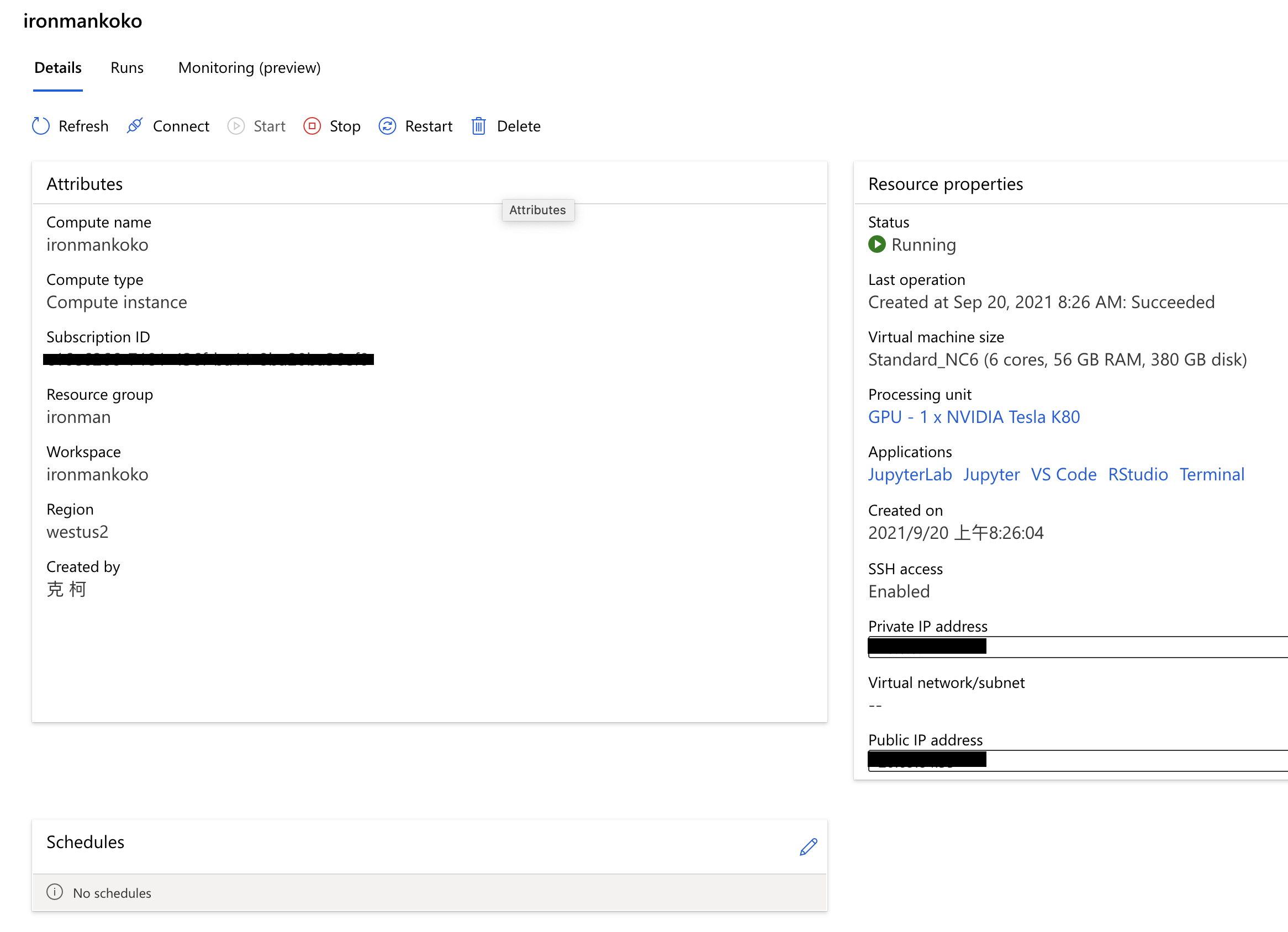

這個顧名思義就是開一台 VM 起來,我們用這一台 VM 來做 Machine Learning。可以開 GPU 或是 CPU 的機器,如果你做的是 deep learning 的話,那麼可能就要開 GPU 的機器會比較好,如果是一般的資料科學專案,可以開 CPU 的 VM 即可。開不同等級的 VM 就會有不同等級的費用,當然開愈好的 VM

會被收愈高的費用。值得注意一提的是,你開的資源數量會有上限的,一般是只能開特定數量的核心數,這是為了避免不小心開太多被超收太多費用。你可以在 Azure 裡向微軟請求開更多的核心數。

這個顧名思義就是開一群 VM 起來,你可以在建立時決定你最大要多少個 VM,最小要多少個 VM。一般用在大規模訓練,還有批次的 inference 處理時使用的。如果是要開發與測試你的 AI 模型,一般還是建議先開 compute instance 會比較省錢。

這個是要把你的 AI 模型部署成 restful API 時使用的,它的底層是 Azure Kubernetes Service。

這個是要連結到其他的運算資料,例如說 Databricks、Data Lake 等其他服務時使用的。一般在做 big data 分析時會比較有機會用到。

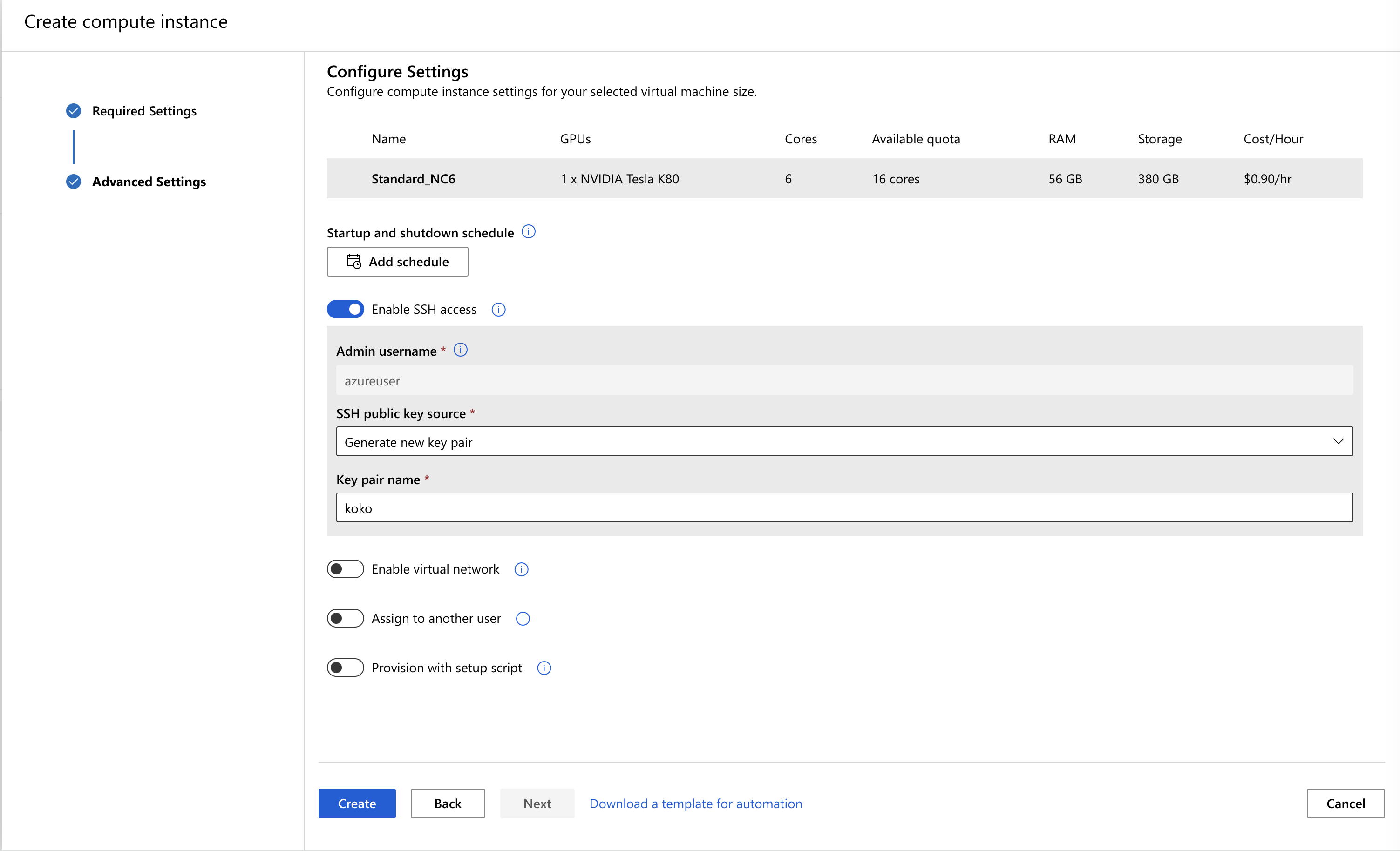

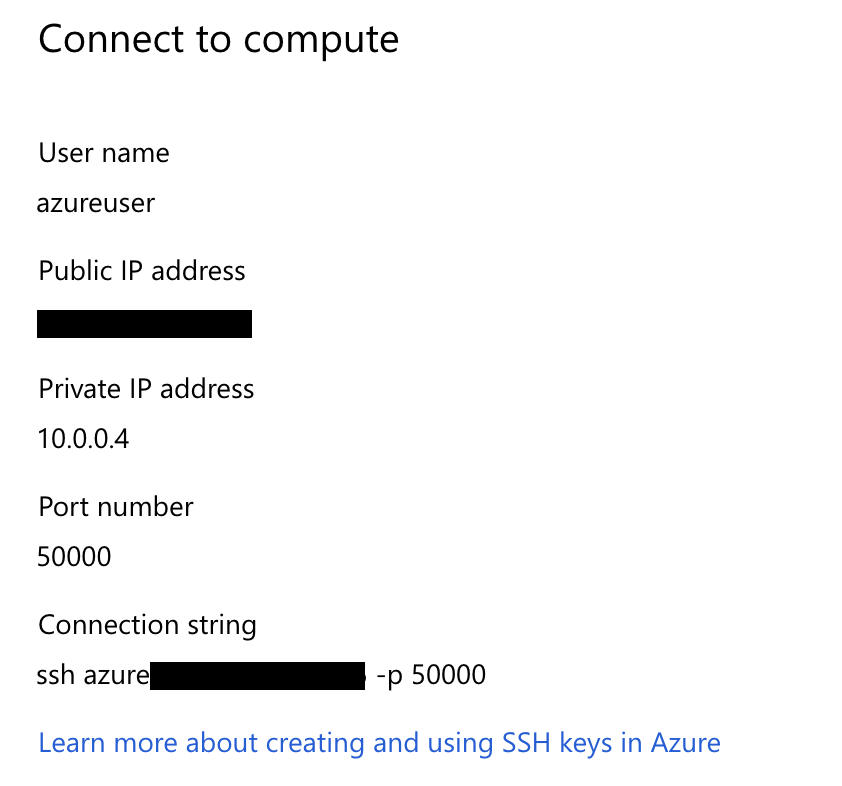

sudo ssh -i 你的PEM檔路徑 azureuser@Azure給你的IP -p 50000

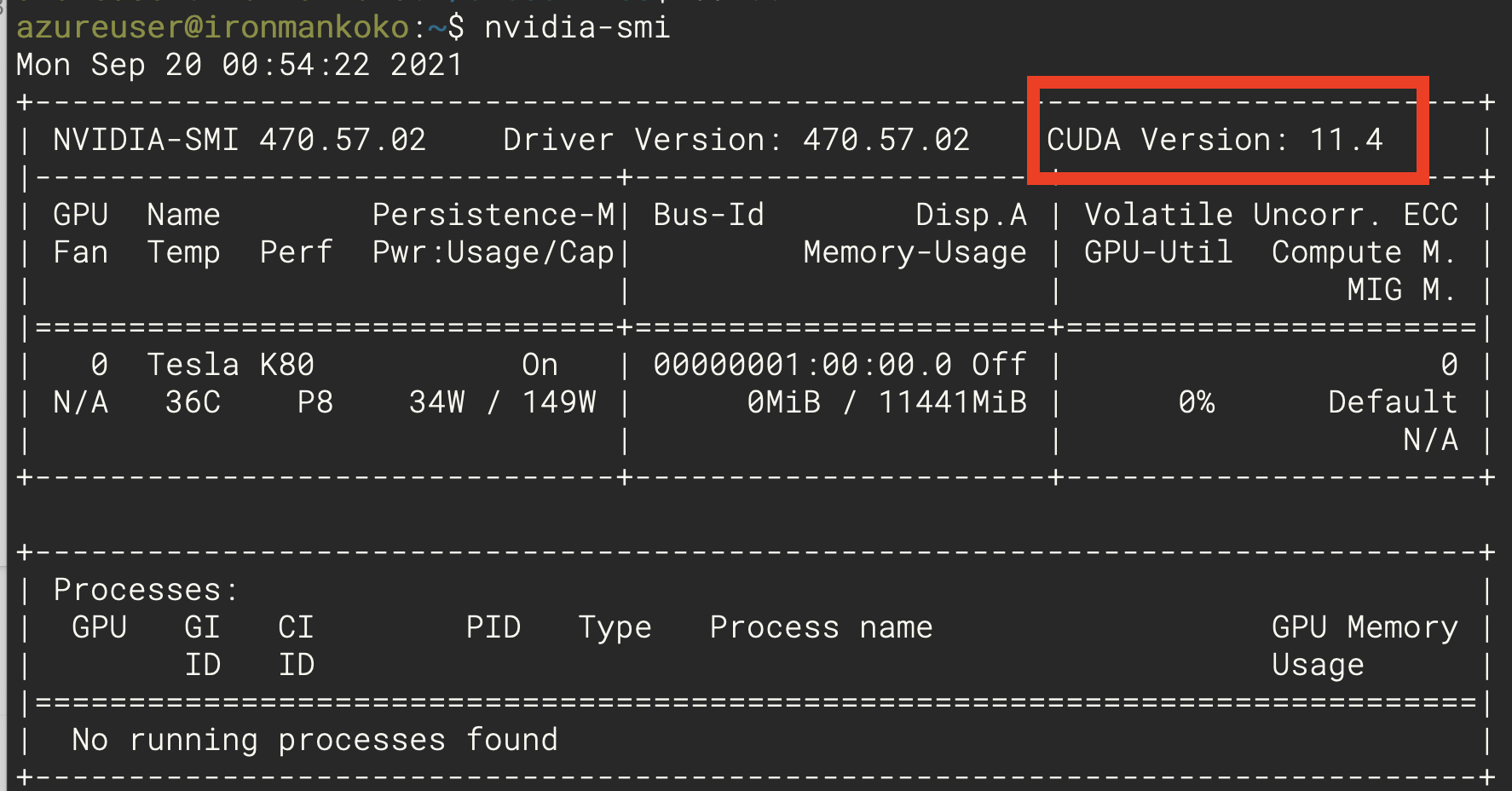

nvidia-smi,來看看 CUDA 是否已經安裝好。可以看到 Azure 已經幫我們處理好 CUDA 的安裝囉!

這下子我們就建立好運算資源啦,明天就開始嘗試 coding 囉!