相信有用過ChatGPT都有發現到,要讓ChatGPT的回應符合我們想要的內容,其中很重要的關鍵是Prompt(又稱提示、詠唱),本篇就來談談Prompt對LLM模型的重要性,以及為什麼LLM模型需要Prompt才能運作。

Prompt,或稱為提示,是指導語言模型生成特定回應的輸入(input)。在與LLM模型互動時,我們所提供的每一句話或問題,都可以被視為一個Prompt。而這些Prompts決定了模型的回應方向,並且影響其生成的品質和關聯性。

舉例來說:如果今天我的Prompt是

請撰寫一篇文章

生成結果有很大的機率是模型回答不出來或是回答的內容不是我們想要的

如果Prompt改成

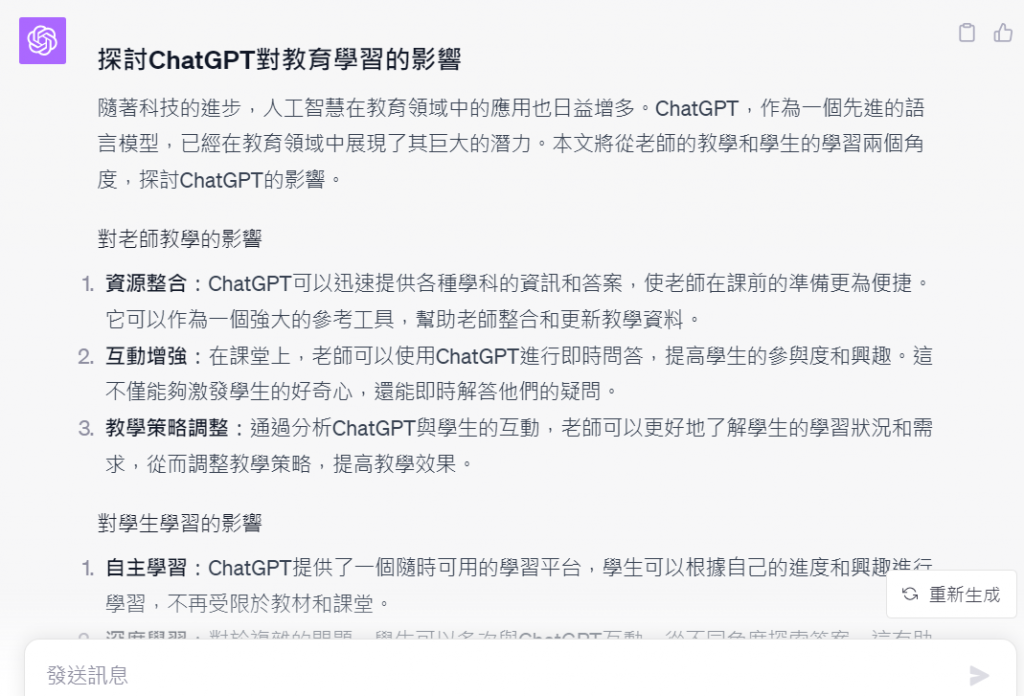

請撰寫一篇""" 探討ChatGPT對教育學習的影響 """

生成結果會比前一個Prompt好很多

再把Prompt改成

請撰寫一篇""" 探討ChatGPT對教育學習的影響 """,內容必須符合以下重點,字數500字左台

1.對老師教學的影響

2.對學生學習的影響

生成結果會更貼近我們所想要的內容

因此Prompts與LLM模型的關聯是:

以GPT系列模型來說,是基於Transformer架構的深度學習方式。模型在訓練時並沒有特定的標籤或目標,而是學習了大量文本資料,從資料中的學習語言模式與捕捉語言中的深層語義,過程中經由自注意力機制允許模型考慮到整個文本的語境,幫助模型理解輸入的文本序列中各個元素(如單詞)之間的關係,進而獲得更精確的語意理解,因此GPT模型可以根據其對語意的理解來生成連貫和有意義的文本內容。所以模型它需要一個引導提示詞來生成回應,而這就是prompt的角色。

自注意力機制(self-attention)

模型在處理輸入序列(如文本或者語音)時,自注意力機制能夠捕捉輸入序列中的長距離依賴關係,會關注與當前位置相關的其他位置的資訊。透過這種方式,模型可以更好的理解輸入序列中的上下文關係,因而提高預測準確性。自注意力機制是OpenAI的GPT系列模型的基礎。

由於LLM模型被設計成可以處理各種NLP任務,所以如果不加以提示,那麼模型會不知道或是不清處它目前的任務目標是什麼。

GPT系列模型在訓練過中融入了人類反饋的強化學習機制,所以它懂的如何迎合人類的喜好(說好聽話),但如果沒有Prompt指導模型,那麼模型便無法預知我們所期望的方向,也就無法生成最佳的回應。

對於LLM模型的回應生成,我們通常形容它為"文字接龍遊戲",透過Prompt誘發模型進行文本的生成,LLM模型在生成文本時,主要依賴於條件機率。當給定一個已有的文本序列,模型會評估下一個最可能的單詞是什麼。這與文字接龍中,玩家試圖根據遊戲的當前狀態來預測最合適的下一個詞的方式相似。

例如:當給了一個Promp是"高",那麼模型很可能會接著"高雄市....."、"高譚市今晚....."、"高興之餘......"

此外像是GPT模型基於Transformer架構,具有捕捉文本中長距離相依性的能力。這表示模型不單只是考慮最近的幾個單詞,而是考慮整個文本序列來生成下一個單詞。這跟文字接龍遊戲中,玩家會考慮上下文,而不僅僅是最後一個詞,以確保文字內容的連貫性,其方式也是相似的。

現在我們了解Promp是與LLM模型互動的關鍵。一個良好的Prompt不僅可以提高模型的回應品質,還可以確保其回應符合我們的需求和期望,因此接下來的章節會再進一步探討Prompt提示工程的技法。

嗨,我是Ian,我喜歡分享與討論,這次的鐵人賽文章也會同時發佈於個人blog,歡迎關注我的blog : https://medium.com/@ianchen_27500