註:本文同步更新在Notion!(數學公式會比較好閱讀)

遞迴式神經網路 (RNN) 之長短期記憶模型 (LSTM)在處理序列數據時,遞迴式神經網路 (RNN) 經常因為梯度消失問題而無法有效地學習長期依賴性。為了解決這個問題,Hochreiter 和 Schmidhuber 於 1997 年提出了長短期記憶模型(LSTM),它是一種特殊的遞迴式神經網路架構,設計用來克服 RNN 的缺陷,特別是在長序列學習上。

LSTM 通過引入記憶單元 (memory cell) 和一組門控機制,來控制信息的存取和更新,從而有效保持長期依賴的信息。這種設計的核心是單元狀態(cell state),一條類似輸水管的結構,允許信息在時間步之間幾乎無修改地傳遞。

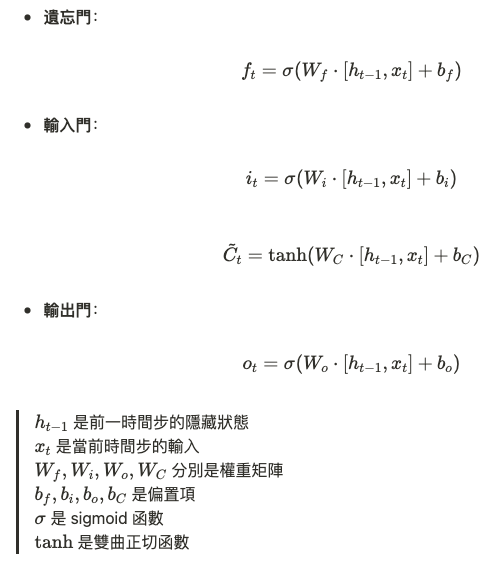

LSTM 的結構由三個門控組成:

每個門控機制都有其對應的權重和偏置:

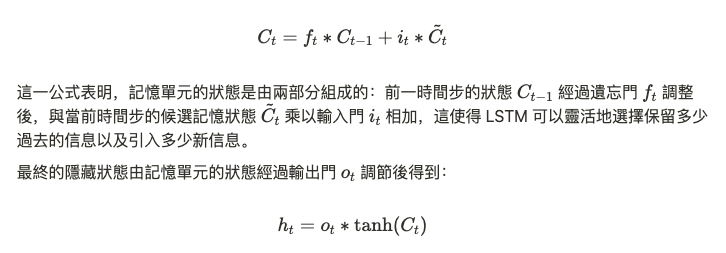

LSTM 的記憶單元會根據遺忘門和輸入門的輸出來進行更新:

LSTM 在序列學習中的最大優勢在於它能夠有效記憶長期依賴信息,這主要得益於記憶單元的設計。傳統 RNN 因為梯度消失問題,在長序列學習上表現不佳,而 LSTM 通過記憶單元的長期保留能力,成功避免了這一問題。

LSTM 的記憶單元讓它可以處理多樣的序列學習任務:

LSTM 的設計可以視為對梯度問題的一種數學解決方案。通過引入門控機制,LSTM 使得梯度可以更穩定地反向傳播,這在反向傳播中有效防止梯度的過度衰減。由於 LSTM 的記憶單元更新公式中涉及的乘法操作,模型可以選擇將信息保留多長時間,從而克服長期依賴問題。

反向傳播的數學推導仍然基於通過時間的反向傳播算法 (Backpropagation Through Time, BPTT),但由於 LSTM 的門控結構,梯度消失問題得到顯著改善。

LSTM 是遞迴式神經網路的一個重要突破,它通過記憶單元和門控機制成功解決了梯度消失問題,特別適合處理長期依賴性的序列數據。隨著深度學習應用的普及,LSTM 成為語音識別、自然語言處理、時間序列預測等領域的基石。

恭喜各位明天放假 萬歲!!!✧*。٩(ˊᗜˋ*)و✧*。