註:本文同步更新在Notion!(數學公式會比較好閱讀)

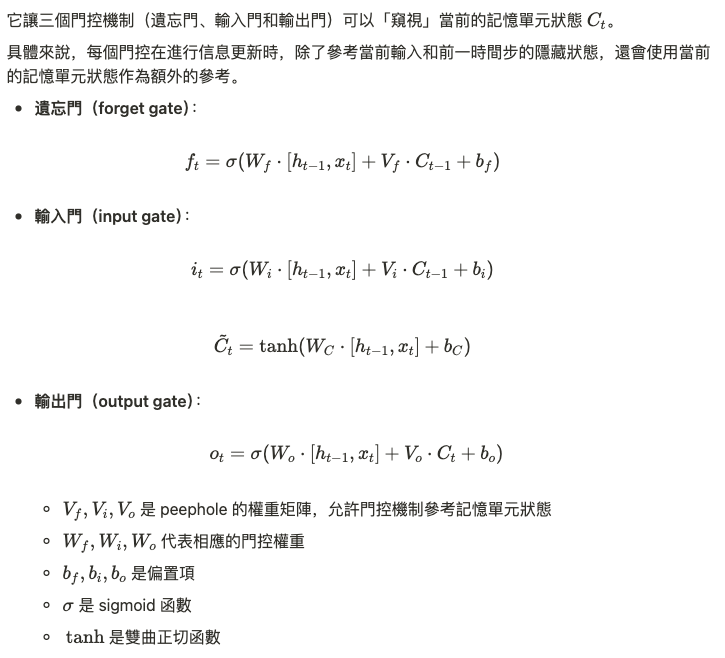

在傳統的 LSTM 結構中,記憶單元狀態是一個核心概念,它通過不同的門控機制控制信息的流動。然而,LSTM 的標準設計中,這些門控機制並不能直接查看記憶單元的當前狀態,這使得模型可能在某些情況下無法有效利用單元中的信息。為了解決這個問題,peephole 長短期記憶模型(Peephole LSTM)應運而生,通過在門控中引入記憶單元狀態的「偷窺孔」(peepholes),使得門控機制可以參考當前記憶單元的狀態。

Peephole LSTM 是在傳統 LSTM 的基礎上改進而來

在傳統 LSTM 中,門控機制無法直接獲取記憶單元的當前狀態,這可能導致模型在某些情境下無法靈活調整信息的存取。而 Peephole LSTM 的創新點就在於,通過窺視記憶單元的狀態,門控機制可以更準確地決定信息的保留、輸入和輸出。

例如:

這種設計讓模型能更靈活地處理長期依賴,尤其是對於那些需要更多細緻控制的序列學習任務,Peephole LSTM 顯示出更強的適應能力。

Peephole LSTM 的數學推導仍然基於通過時間的反向傳播算法 (Backpropagation Through Time, BPTT),其推導過程與傳統 LSTM 相似,只是在計算遺忘門、輸入門和輸出門時,會額外引入當前的記憶單元狀態 $C_t$。這使得梯度的傳播能夠更加準確,特別是在長期依賴的序列學習中,可以有效防止梯度消失和梯度爆炸問題。

由於其增強的記憶單元控制能力,Peephole LSTM 在許多序列學習任務中表現優異,尤其是那些對時間步的細微變化高度敏感的任務。它的應用場景包括:

Peephole LSTM 的數學特性使其在處理長期依賴性問題時表現更加出色。由於每個門控機制可以直接參考記憶單元的狀態,這使得梯度可以更精確地傳播,從而大大緩解了 LSTM 中可能出現的梯度問題。這也進一步提升了模型的穩定性和準確性,尤其是在長序列的學習任務中。

Peephole LSTM 是 LSTM 的改進版,它通過引入窺視記憶單元的機制,讓模型在學習過程中可以更好地控制信息的流動。這使得模型在處理長期依賴性問題時,能更精準地選擇保留、引入或輸出信息。在語音識別、自然語言處理和時間序列預測等應用中,Peephole LSTM 展現出了強大的實用價值。

今晚會不會宣布明天放颱風假啊(挖哭挖哭)⁽⁽ଘ( ˙꒳˙ )ଓ⁾⁾⁽⁽ଘ( ˙꒳˙ )ଓ⁾⁾⁽⁽ଘ( ˙꒳˙ )ଓ⁾⁾