想像一下,你正在開發一個圖片分享平台,第一週就湧入了十萬張照片。使用者抱怨上傳速度慢、圖片載入卡頓,你的雲端帳單也在瘋狂飆升。更糟的是,有人上傳了惡意檔案,還有用戶要求符合 GDPR 刪除所有個人資料。

今天的圖片分享系統已經不只是「把檔案存起來」這麼簡單。從 Instagram 每秒處理百萬級請求,到 Unsplash 用極小團隊服務全球用戶,現代圖片系統的設計充滿了精妙的架構決策。

這篇文章將帶你深入理解如何設計一個既能處理海量圖片、又能控制成本、還能確保安全性的系統。

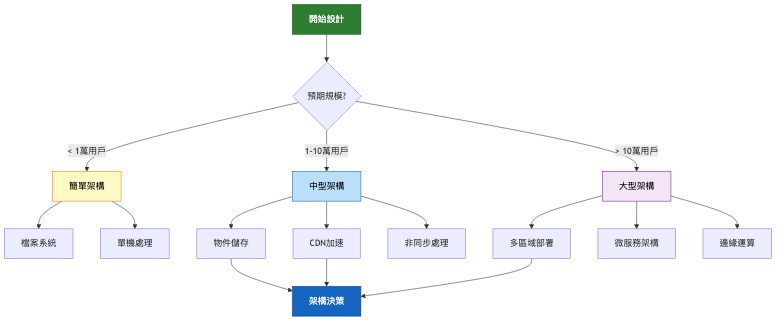

透過這篇文章,你將學會如何選擇適合的儲存策略、實施智慧的圖片處理流程、整合 CDN 實現全球分發,以及建立完整的安全防護機制。我們會從最基礎的 MVP 版本開始,逐步演進到能支撐百萬用戶的企業級架構。

設想我們要建立一個現代化的圖片分享平台,類似於 Instagram 或 Imgur。用戶可以上傳各種格式的圖片,系統會自動處理並生成多種尺寸,其他用戶可以瀏覽、分享和下載這些圖片。

這個系統不僅要處理靜態圖片的儲存與展示,還要應對動態的使用需求:社交分享需要快速載入、行動裝置需要自適應圖片、創作者需要高品質原圖保存。系統必須在效能、成本和使用體驗之間找到最佳平衡點。

功能性需求:

非功能性需求:

| 需求類別 | 具體指標 | 說明 |

|---|---|---|

| 效能要求 | 上傳速度 < 5秒(10MB檔案) | 包含處理時間 |

| 縮圖載入 < 200ms | 全球範圍 | |

| 原圖載入 < 2秒 | CDN加速 | |

| 可用性 | 99.9% SLA | 每月停機 < 44分鐘 |

| 擴展性 | 支援100萬日活用戶 | 垂直與水平擴展 |

| 每日10萬張上傳 | 尖峰處理能力 | |

| 安全性 | 防惡意檔案上傳 | 多層驗證 |

| GDPR合規 | 資料保護 | |

| 成本限制 | 每GB儲存 < $0.05 | 包含備份 |

| 每GB傳輸 < $0.10 | CDN成本 |

技術挑戰 1:儲存策略選擇

圖片檔案該存在「檔案系統」、「資料庫」還是「物件儲存」? 每種方案在成本、效能、擴展性上的差異巨大。

技術挑戰 2:圖片處理時機

是上傳時預處理所有尺寸,還是請求時動態生成?這影響儲存成本和回應速度的平衡。

技術挑戰 3:全球分發效能

如何確保全球用戶都能快速載入圖片?CDN 整合策略直接決定用戶體驗。

| 維度 | 檔案系統儲存 | 資料庫儲存 | 物件儲存(S3/GCS/Azure Blob) |

|---|---|---|---|

| 核心特點 | 直接存取本地檔案 | BLOB欄位儲存 | 雲端託管服務 |

| 優勢 | 簡單直接、低延遲 | 事務一致性、備份簡單 | 無限擴展、高可用 |

| 劣勢 | 擴展困難、備份複雜 | 資料庫膨脹、效能瓶頸 | 網路延遲、廠商綁定 |

| 適用場景 | 小型專案、內部系統 | 小檔案、需要事務 | 大規模、全球服務 |

| 複雜度 | 低 | 中 | 中 |

| 成本 | 初期低、後期高 | 中等、線性增長 | 按用量付費、可預測 |

架構重點:

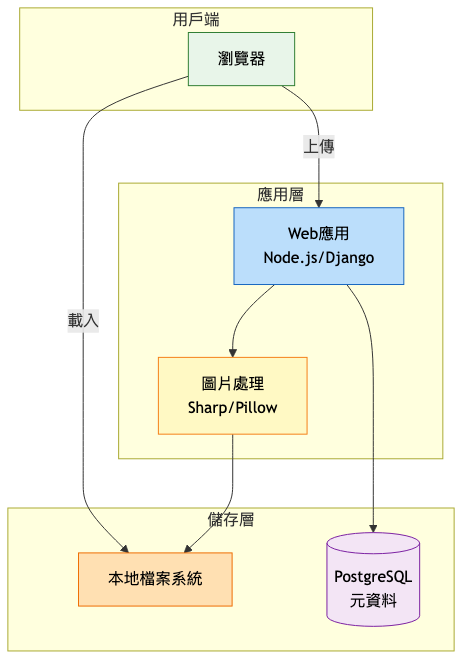

系統架構圖:

為什麼這樣設計:

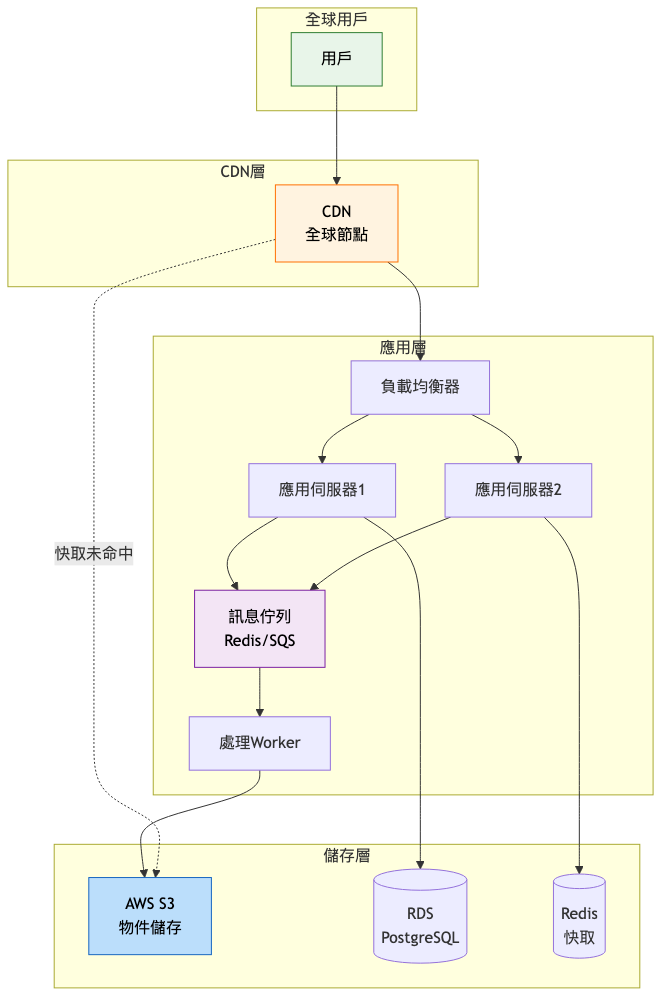

架構演進重點:

關鍵設計變更:

物件儲存遷移

CDN 整合

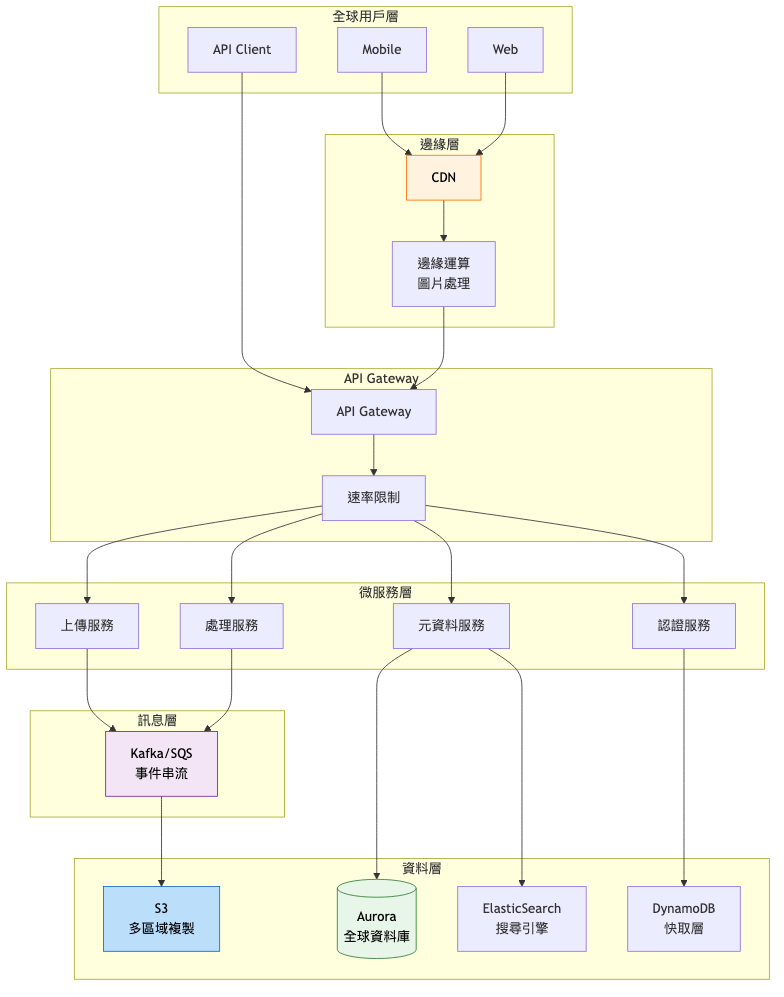

企業級架構特點:

架構設計考量:

高可用性設計

擴展性規劃

營運效率

| 技術選項 | 優勢 | 劣勢 | 適用場景 |

|---|---|---|---|

| 物件儲存 | |||

| AWS S3 | 成熟生態、高耐久性、豐富功能 | 成本較高、廠商鎖定 | 企業級應用、需要完整生態 |

| Google Cloud Storage | 效能優異、AI整合好 | 亞洲節點較少 | 機器學習應用、全球服務 |

| Azure Blob | 企業整合佳、成本較低 | 功能相對簡單 | Microsoft生態、企業客戶 |

| 圖片處理 | |||

| Sharp (Node.js) | 效能極佳、記憶體效率高 | 僅Node.js | 高併發處理、Serverless |

| Cloudinary | SaaS服務、功能豐富 | 成本高、依賴外部 | 快速上線、小團隊 |

| CDN服務 | |||

| CloudFlare | 免費方案、DDoS防護 | 進階功能收費 | 中小型專案、安全需求 |

| AWS CloudFront | AWS整合、Lambda@Edge | 成本較高 | AWS生態、企業應用 |

| Fastly | 即時清除、邊緣運算強 | 價格昂貴 | 即時性需求、大型企業 |

初期技術(MVP):

成長期調整:

成熟期優化:

過早優化陷阱

忽視安全驗證

同步處理瓶頸

Instagram:從小團隊到億級規模 參考:Instagram Engineering Blog

初期(2010-2012)

成長期(2012-2016)

近期狀態(2016-現在)

責任鏈模式用於圖片處理管線:

觀察者模式用於事件驅動架構:

圖片命名策略:

/2025/09/14/{hash}.jpg

{hash}_thumb_200x200.jpg

安全防護措施:

技術指標:

業務指標:

自動化策略

監控告警

持續優化

針對今日探討的圖片上傳分享系統設計,建議可從以下關鍵字或概念深化研究與實踐:

WebP 與 AVIF 格式優化:透過學習新一代圖片格式的編碼原理與實作,能大幅減少頻寬使用並提升載入速度。

邊緣運算(Edge Computing):研究 CloudFlare Workers 或 AWS Lambda@Edge,實現更接近用戶的圖片處理,降低延遲。

感知雜湊(Perceptual Hashing):探索 pHash、dHash 等演算法,用於圖片相似度比對和重複檢測,提升儲存效率。

IPTC/EXIF 元資料處理:深入了解圖片元資料標準和隱私保護,避免意外洩露敏感位置資訊。

向量資料庫與 AI 搜尋:學習 Pinecone、Weaviate 等向量資料庫,結合 CLIP 模型實現語義圖片搜尋。

可根據自身興趣,針對上述關鍵字搜尋最新技術文章、專業書籍或參加線上課程,逐步累積專業知識和實踐經驗。

明天我們將探討「簡易電商系統」的設計。電商系統看似簡單的商品展示和購物車,背後卻涉及庫存管理、訂單處理、支付整合等複雜邏輯。我們將深入探討如何設計一個既能處理高併發搶購,又能確保交易一致性的系統架構。準備好迎接電商系統的挑戰了嗎?