想像一下,你的企業同時需要滿足這些需求:金融交易的極低延遲、AI 訓練的大規模運算、用戶個資的本地合規要求、全球服務的彈性擴展能力。單純的公有雲或私有雲都無法完美解決這些挑戰。這就是為什麼 90% 的企業正在採用混合雲架構——它不是妥協,而是一種策略性選擇。

混合雲不再只是「公有雲加上本地資料中心」這麼簡單。現代混合雲架構是一個精心編排的系統,透過容器技術、服務網格、事件驅動架構和 AI 驅動的管理平台,將公有雲、私有雲、本地基礎設施和邊緣運算無縫整合。這個架構讓你能夠根據每個工作負載的特性,將其部署在最適合的環境中。

今天,我們將深入探討如何設計一個真正的企業級混合雲架構,從簡單的雲擴展開始,逐步演進到支援全球業務的智慧型基礎設施。

一家跨國製造企業正在進行數位轉型,需要建立統一的技術平台來支援全球營運。企業擁有 50+ 個生產基地、200+ 個銷售據點,以及數百萬個 IoT 設備。同時需要滿足各地區的資料主權要求,支援 AI/ML 創新應用,並維持既有的核心 ERP 系統運作。

這個系統必須能夠:

功能性需求

非功能性需求

| 需求類別 | 目標指標 | 說明 |

|---|---|---|

| 效能要求 | < 50ms 區域延遲< 200ms 跨區延遲 | 邊緣處理關鍵即時資料 |

| 可用性 | 99.99% SLA | 核心業務系統的高可用保證 |

| 擴展性 | 支援 100萬+ IoT 設備10TB+ 日資料處理 | 自動擴展以應對需求變化 |

| 安全性 | 零信任架構端到端加密 | 全面的安全防護體系 |

| 合規性 | GDPR、CCPA、ISO 27001 | 滿足多地區法規要求 |

| 成本限制 | TCO 降低 30% | 相比純公有雲方案 |

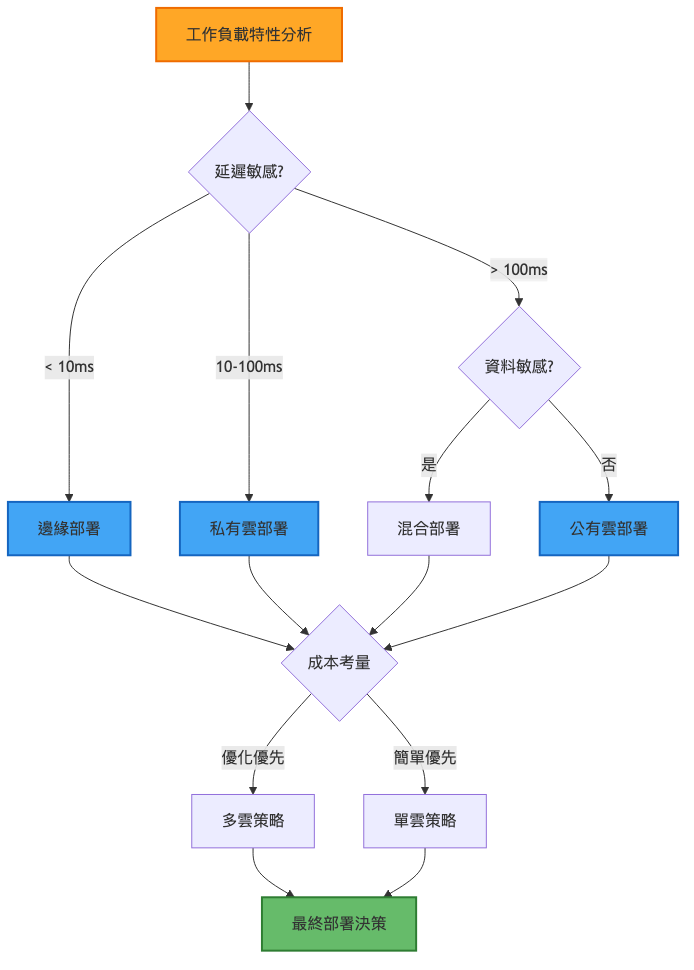

技術挑戰 1:工作負載放置決策

技術挑戰 2:跨環境資料一致性

技術挑戰 3:統一管理複雜度

| 維度 | 集中式混合雲 | 分散式多雲 | 邊緣優先架構 |

|---|---|---|---|

| 核心特點 | 單一控制平面中心化管理 | 多個獨立雲鬆散耦合 | 邊緣處理為主雲端協調 |

| 優勢 | 管理簡單一致性高 | 避免供應商鎖定最佳服務選擇 | 超低延遲離線能力強 |

| 劣勢 | 單點故障風險擴展受限 | 管理複雜整合成本高 | 邊緣資源受限維護困難 |

| 適用場景 | 中小型企業簡單需求 | 大型企業多樣化需求 | IoT 密集即時要求高 |

| 複雜度 | 低 | 高 | 中 |

| 成本 | 中等 | 高(管理成本) | 高(硬體投資) |

架構重點:

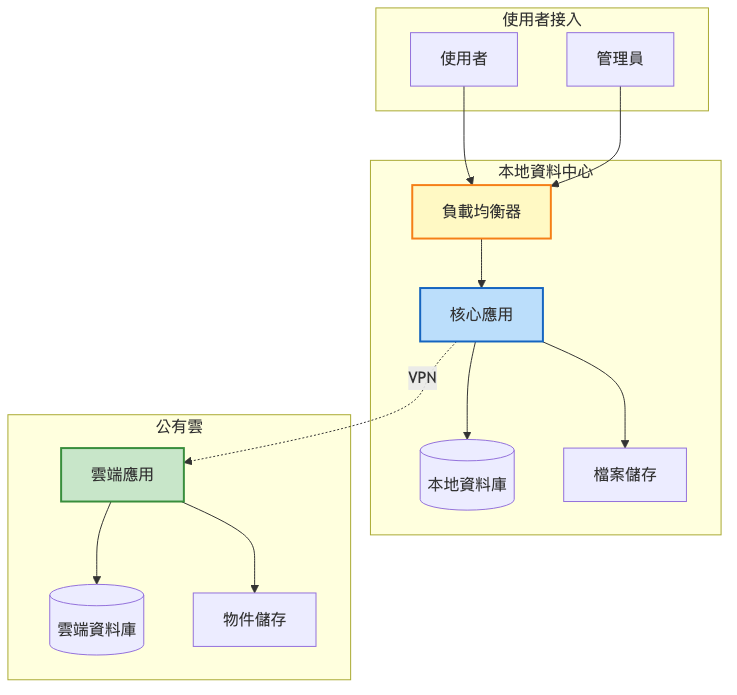

系統架構圖:

關鍵實施項目:

架構重點:

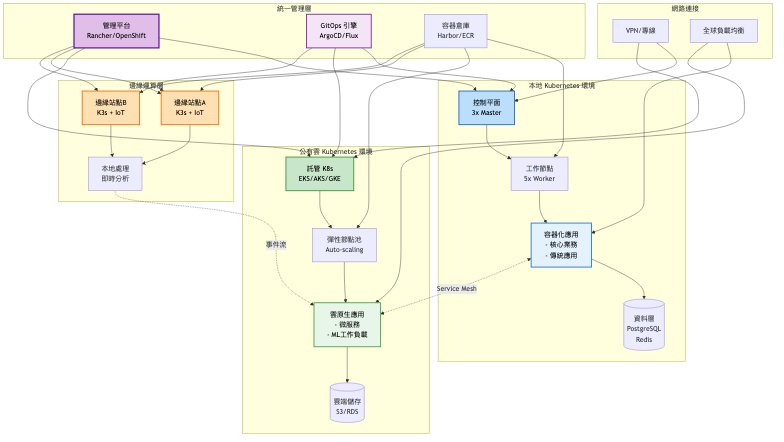

系統架構圖:

關鍵架構變更:

容器化改造

多叢集管理

雙軌混合部署策略

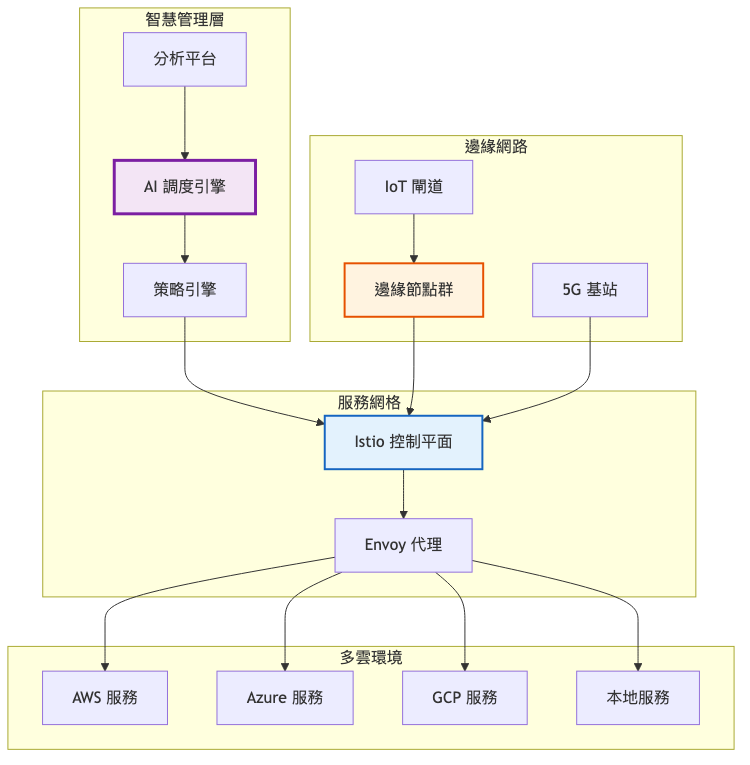

架構重點:

總覽架構圖:

預期效能提升對比表:

| 指標 | 第一階段 | 第二階段 | 第三階段 | 改善幅度 |

|---|---|---|---|---|

| 部署頻率 | 每週 | 每日 | 每小時 | 168x |

| 故障恢復時間 | 4小時 | 30分鐘 | 5分鐘 | 48x |

| 資源利用率 | 30% | 55% | 75% | 2.5x |

| 延遲表現 | 200ms | 100ms | 50ms | 4x |

容器編排平台選擇:

| 技術選項 | 優勢 | 劣勢 | 適用場景 |

|---|---|---|---|

| Kubernetes 原生 | 完全控制社群活躍無供應商鎖定 | 複雜度高需專業團隊維護成本高 | 技術能力強的大型企業 |

| OpenShift | 企業級功能完整安全性強Red Hat 支援 | 授權成本高學習曲線陡峭 | 需要企業支援的組織 |

| Rancher | 易用性佳多叢集管理強開源免費 | 功能相對簡單企業支援有限 | 中型企業快速上手 |

| Anthos | Google 整合度高混合雲原生AI/ML 整合佳 | 成本較高GCP 依賴性 | Google Cloud 用戶 |

服務網格技術選擇:

| 技術選項 | 優勢 | 劣勢 | 適用場景 |

|---|---|---|---|

| Istio | 功能最完整社群最大多雲支援好 | 資源消耗大配置複雜 | 大規模企業部署 |

| Linkerd | 輕量級性能優秀易於使用 | 功能較少生態系統小 | 性能敏感應用 |

| Consul | HashiCorp 生態多資料中心支援 | 學習成本高文檔較少 | HashiCorp 技術棧用戶 |

過早複雜化

忽視網路延遲

資料重力低估

Netflix 的混合到全雲之旅

參考文章

初期(2008-2010)

成長期(2010-2016)

近期狀態(2016-現在)

Spotify 的 Kubernetes 轉型

參考文章

初期挑戰

Kubernetes 採用(2018-2020)

成果展現

工作負載放置模式

多雲故障轉移模式

實踐項目:零信任安全架構

實踐項目:GitOps 工作流程

技術指標:

業務指標:

自動化策略

監控告警

持續優化

針對今日探討的混合雲架構系統設計,建議可從以下關鍵字或概念深化研究與實踐:

Service Mesh 深度實踐:透過進一步學習 Istio、Linkerd 的進階功能,能加強對微服務通訊、流量管理的理解與應用。

GitOps 與 Infrastructure as Code:深入掌握 Flux、ArgoCD、Terraform 等工具,提升基礎設施自動化能力。

FinOps 雲端財務管理:探索成本優化策略、資源標記、預算管理等實踐,幫助企業控制混合雲成本。

邊緣運算與 5G 整合:關注 MEC(Multi-access Edge Computing)、網路切片等新興技術,為下一代應用做準備。

SASE(Secure Access Service Edge):研究新一代網路安全架構,整合 SD-WAN 與雲端安全服務。