| .. | Weight based | Residual based(image, video) |

|---|---|---|

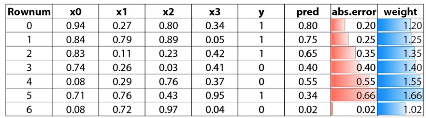

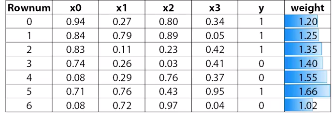

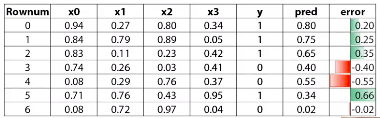

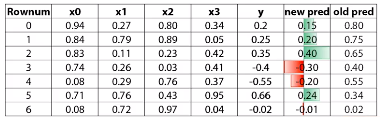

| 方法 | 權重以實際與預測之絕對差加上1(圖一, 二) | 以殘差取代變成新的實際值 (圖三, 四) |

| parameter-1 | Learning rate (or shrinkage or eta) | Learning rate (or shrinkage or eta) |

| parameter-2 | number of estimators越多, 需要的learning Rate 數量越少, 正確的值可藉助 cross-validation | number of estimators-> more is better; Row(sub) sampling; Column(sub) sampling |

| parameter-3, input model | Can be anything that accepts weights | better be trees |

| Sub boosting type | AdaBoost(Sklearn), LogitBoost(Weka) | Fully gradient based, Dart (Dropout) |

圖一

圖二

圖三

圖四 : 以殘差取代變成新的實際值後, 與舊的預測比較, score 變高了

to predict Rownum=1 : final prediction=0.75+0.2=0.95

截圖自Coursera

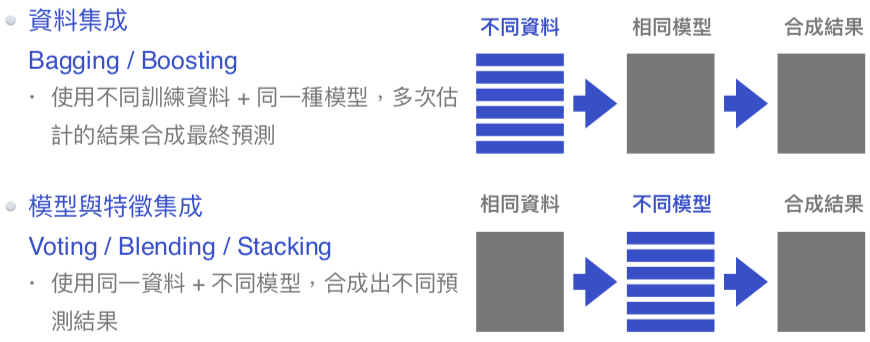

下列是資料集成跟模型集成方法的結構比較, 要小心別搞混.

截圖自 AI 100 陳明佑簡報