大家好~ ![]()

![]()

![]()

昨天我們已經成功拉取 Google Analytics 資料到 AWS,可是我們發現『抓取的 Google Analytics 檔案為多行的 JSON 格式』,非常不方便使用者閱讀且 Athena 也不支援此格式搜尋,讓我們無法進行後續的分析處理 (直接碰壁)

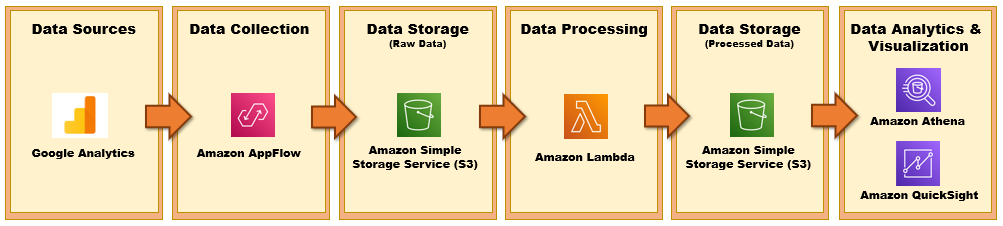

故我們需要設計合適的 Data Analytics Pipeline 以便進行資料分析以及視覺化的處理,就以 Google Analytics 資料源為案例,我整理出 Data Analytics Pipeline 用到的相關 AWS 服務供大家參考:

現在我們已經完成 Data Collection 以及 Data Storage ( raw data )的步驟,明天我們則會討論 Data Processing - 如何用 Lambda 進行欄位名稱與格式的調整以及檔案格式轉換~

要開始寫個程式碼囉 ![]() 那就明天見:)

那就明天見:)

如果有任何指點與建議,也歡迎留言交流,一起漫步在 Data on AWS 中。