前言

這篇文章會介紹如何安裝 Spark 並進行適當的配置,還不清楚 Spark 是什麼的人可以先看看 Spark 的介紹系列:

Day13 - Spark 介紹 (1):簡介與架構

Day14 - Spark 介紹 (2):RDD

Day15 - Spark 介紹 (3):Spark SQL、DataFrame、DataSet

還沒安裝 Hadoop 和 Java 的可以參考這裡:Day06 Hadoop 安裝

$ curl -fL https://github.com/coursier/coursier/releases/latest/download/cs-x86_64-pc-linux.gz | gzip -d > cs && chmod +x cs && ./cs setup

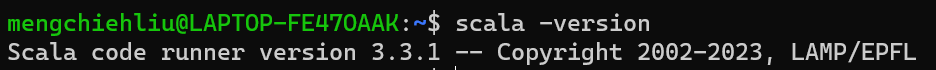

$ scala -version

$ mkdir ~/spark

$ cd ~/spark

$ wget https://dlcdn.apache.org/spark/spark-3.4.1/spark-3.4.1-bin-hadoop3.tgz

$ tar zxvf spark-3.4.1-bin-hadoop3.tgz

$ rm spark-3.4.1-bin-hadoop3.tgz

$ vim ~/.bashrc

~./bashrc

export SPARK_HOME=~/spark/spark-3.4.1-bin-hadoop3

export PATH=$PATH:$SPARK_HOME/bin

~./bashrc 使改動生效

$ source ~/.bashrc

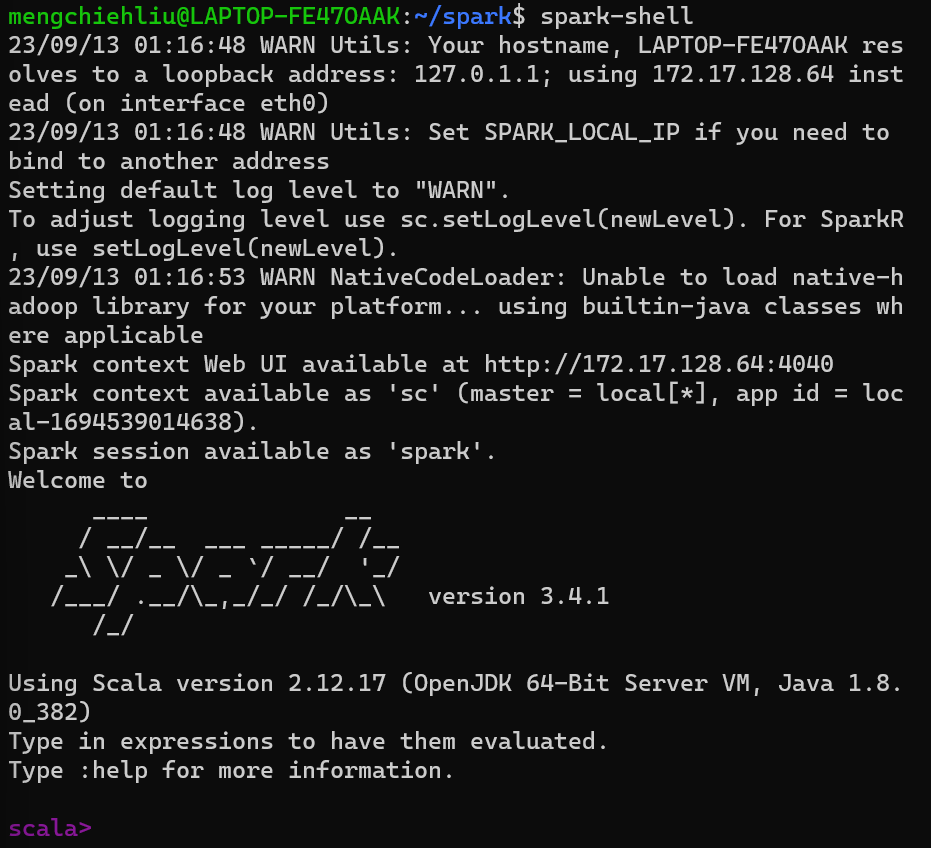

$ spark-shell

:q、:quit 可以退出)

spark-env.sh 中加入以下配置

export HADOOP_HOME=~/home/mengchiehliu/hadoop/hadoop-3.3.6

export HADOOP_CONF_DIR=$HADOOP_HOME/etc/hadoop

export YARN_CONF_DIR=$HADOOP_HOME/etc/hadoop

export JAVA_HOME=/usr/lib/jvm/java-1.8.0-openjdk-amd64

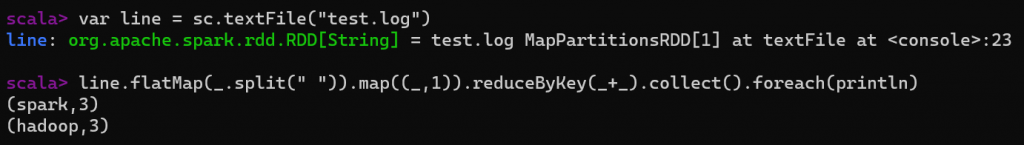

test.log,內容如下

hadoop spark hadoop

spark hadoop spark

$ $HADOOP_HOME/sbin/start-dfs.sh

$ $HADOOP_HOME/sbin/start-yarn.sh

$ spark-shell

var line = sc.textFile("test.log")

line.flatMap(_.split(" ")).map((_,1)).reduceByKey(_+_).collect().foreach(println)

明天會介紹 Spark in Python - PySpark 的使用。

GETTING STARTED | Scala Documentation