今天要繼續講解前一篇未講完的CNN網路的程式碼

一樣先把完整的程式碼貼上來

import tensorflow as tf

from tensorflow.keras import layers, models

from tensorflow.keras.datasets import mnist

from tensorflow.keras.utils import to_categorical

(train_images, train_labels), (test_images, test_labels) = mnist.load_data()

train_images = train_images.reshape((60000, 28, 28, 1)).astype('float32') / 255

test_images = test_images.reshape((10000, 28, 28, 1)).astype('float32') / 255

train_labels = to_categorical(train_labels)

test_labels = to_categorical(test_labels)

model = models.Sequential()

model.add(layers.Conv2D(32, (3, 3), activation='relu', input_shape=(28, 28, 1)))

model.add(layers.MaxPooling2D((2, 2)))

model.add(layers.Conv2D(64, (3, 3), activation='relu'))

model.add(layers.MaxPooling2D((2, 2)))

model.add(layers.Conv2D(64, (3, 3), activation='relu'))

model.add(layers.Flatten())

model.add(layers.Dense(64, activation='relu'))

model.add(layers.Dense(10, activation='softmax'))

model.compile(optimizer='adam',

loss='categorical_crossentropy',

metrics=['accuracy'])

model.fit(train_images, train_labels, epochs=5, batch_size=64, validation_data=(test_images, test_labels))

test_loss, test_acc = model.evaluate(test_images, test_labels)

print(f'Test accuracy: {test_acc}')

train_labels = to_categorical(train_labels)

test_labels = to_categorical(test_labels) //對標籤數據進行one-hot編碼

// to_categorical(train(test)_labels): train(test)_labels 是原始的標籤數據,其中每個元素代表相應圖像的數字標籤(0 到 9 之間的整數)。to_categorical 函數將這些整數轉換為獨熱編碼,這是一種多類分類的標籤表示方法。

例如,如果原始標籤是 3,則經過獨熱編碼後,表示為 [0, 0, 0, 1, 0, 0, 0, 0, 0, 0]。這樣的表示方法在多類分類問題中非常常見,每個類別都是一個二元(0 或 1)的值。

唯一性: 獨熱編碼確保每個標籤的表示是唯一的。在這種表示方式下,每個類別都由一個獨特的位模式表示,並且只有一位是 1,其他位都是 0。這種唯一性使得模型能夠清晰地識別每個類別,而不會混淆它們。

模型的可解釋性: 獨熱編碼使得模型的輸出更容易理解和解釋。每個類別的預測值對應於獨熱編碼中的一個元素,這樣就可以直觀地理解模型對每個類別的置信度。

避免順序偏好: 在一般的標籤表示中,標籤之間的數值可能會被誤解為具有順序性,即使這在實際問題中並不成立。使用獨熱編碼消除了這種偏好,模型不會將數字大小視為標籤之間的相對順序。

model = models.Sequential()

model.add(layers.Conv2D(32, (3, 3), activation='relu', input_shape=(28, 28, 1)))

model.add(layers.MaxPooling2D((2, 2)))

model.add(layers.Conv2D(64, (3, 3), activation='relu'))

model.add(layers.MaxPooling2D((2, 2)))

model.add(layers.Conv2D(64, (3, 3), activation='relu')) //定義CNN模型

//model = models.Sequential(): 創建一個 Sequential 模型,這是 Keras 中的一種基本模型,允許按照順序一層一層地添加神經網路層。

//model.add(layers.Conv2D(32, (3, 3), activation='relu', input_shape=(28, 28, 1))): 添加第一個卷積層。這層具有 32 個濾波器(filters),每個濾波器的大小為 (3, 3)。使用 'relu' 作為激活函數,並指定輸入形狀為 (28, 28, 1),這表示輸入影像的大小是 28x28,通道數為 1(灰度影像)。

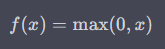

ReLU(Rectified Linear Unit) 激活函數是一種常用的非線性激活函數

即,對於輸入 x,如果 x 大於零,則輸出為 x;否則,輸出為零。

//model.add(layers.MaxPooling2D((2, 2))): 添加最大池化層,這有助於減小特徵圖的空間尺寸,同時保留最重要的特徵。這裡使用 (2, 2) 的池化窗口大小。

//model.add(layers.Conv2D(64, (3, 3), activation='relu')) 和model.add(layers.MaxPooling2D((2, 2))): 類似於第一個卷積層和池化層的組合,但這次使用了 64 個濾波器。

model.add(layers.Flatten())

model.add(layers.Dense(64, activation='relu'))

model.add(layers.Dense(10, activation='softmax')) //定義CNN模型

//model.add(layers.Flatten()): 添加扁平化層,將之前卷積和池化層的輸出攤平為一維向量,以便進入全連接層。

//model.add(layers.Dense(64, activation='relu')): 添加全連接層,有 64 個神經元,使用 'relu' 作為激活函數。

//model.add(layers.Dense(10, activation='softmax')): 添加最後一層全連接層,有 10 個神經元,對應於 0 到 9 的數字類別。使用 'softmax' 作為激活函數,這將輸出一個包含每個類別概率的概率分佈。

softmax 激活函數通常用於多類別分類問題的最後一層全連接層。softmax 函數的主要作用是將模型的輸出轉換成一個概率分佈,使得每個類別的輸出都在 (0, 1) 的範圍內並且總和為 1。

下一篇會從模型的編譯開始講~