今天想嘗試架看看多模態的模型,一樣找一個中文的來試試看。

https://github.com/THUDM/VisualGLM-6B

原先想架在自家電腦上,但發現架在windows上比較麻煩,有些套件不好裝,決定改到 colab 上運行。

到 colab 上開一個 ipynb,調整執行階段類型,選有 GPU 來用,因為我自己有買 colab pro,所以再多勾了一個大量 RAM,RAM 不夠的做法,改天再研究。

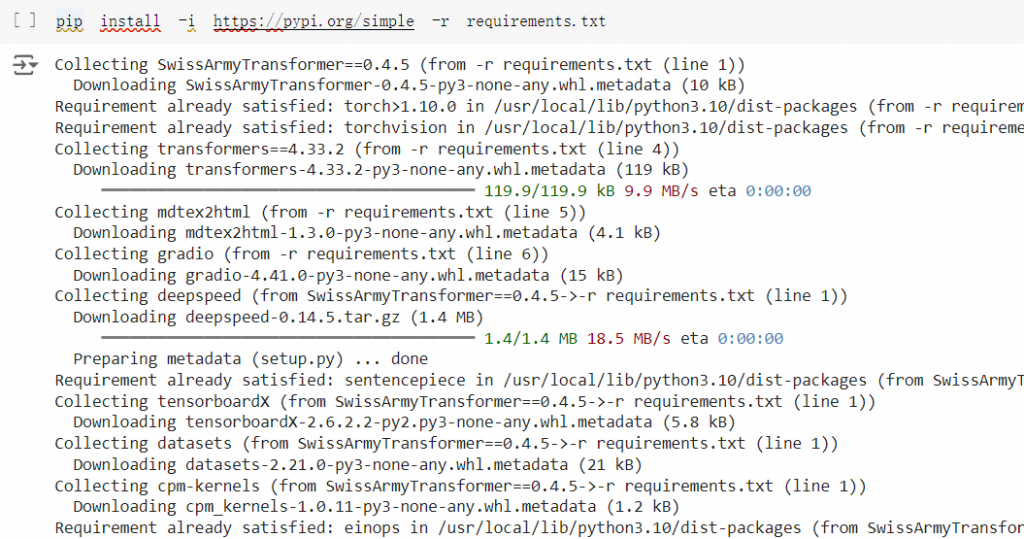

git 中有提供 requirements.txt ,直接照著裝會有些套件版本衝突問題,我調整了其中兩項,SwissArmyTransformer==0.4.5

transformers==4.33.2

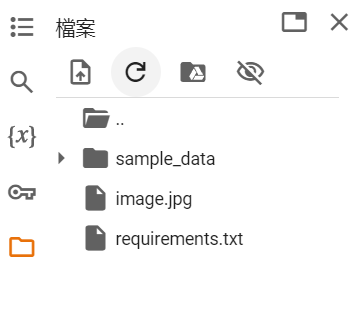

這是最後的 requirements.txt 的模樣,紀錄一下。

SwissArmyTransformer==0.4.5

torch>1.10.0

torchvision

transformers==4.33.2

mdtex2html

gradio

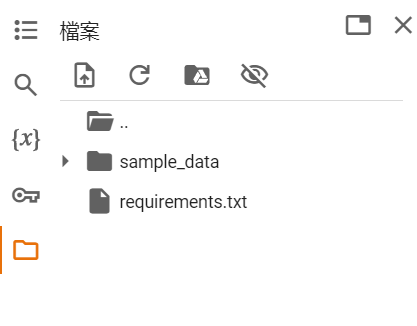

可以把 requirements.txt 直接丟上檔案區,直接下指令裝。

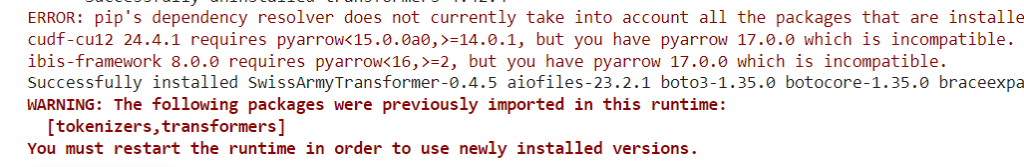

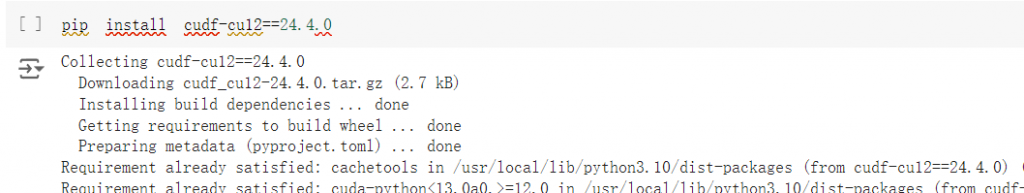

裝完發現還是有版本衝突,先把 cudf-cu12 降板。

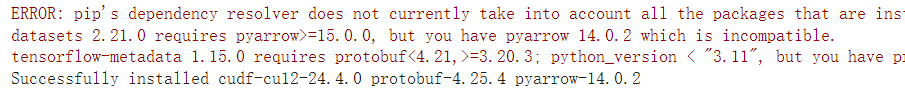

降板後會把 pyarrow 、protobuf 一併更新,這裡 pyarrow 被降到 14.0.2,符合 ibis-framework 8.0.0 的要求了,但 datasets 、tensorflow-metadata 有衝突,先處理 datasets。

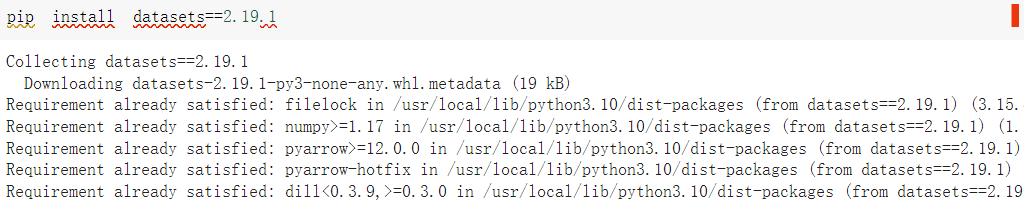

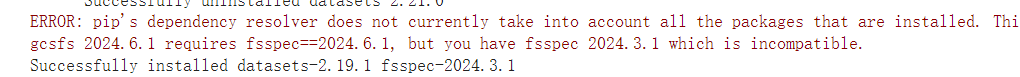

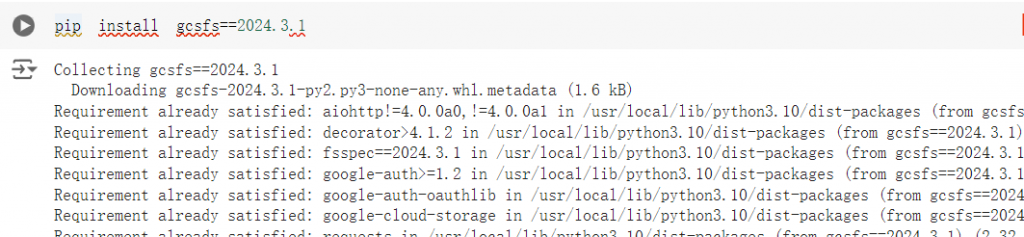

把 datasets 降板,發現他把 fsspec 也降板了,使的 gcsfs 得降板,那就把 gcsfs 也降,順利解決。

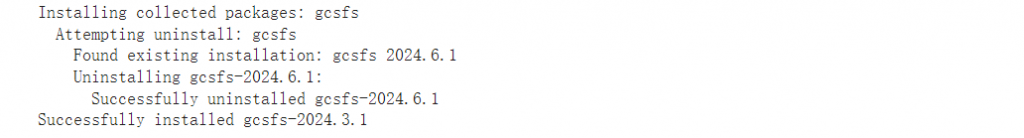

最後是還沒處理的 tensorflow-metadata,繼續降板,這樣就差不多了。

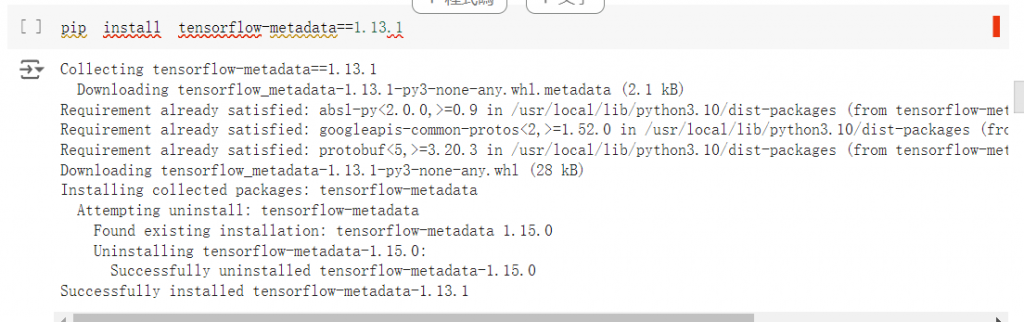

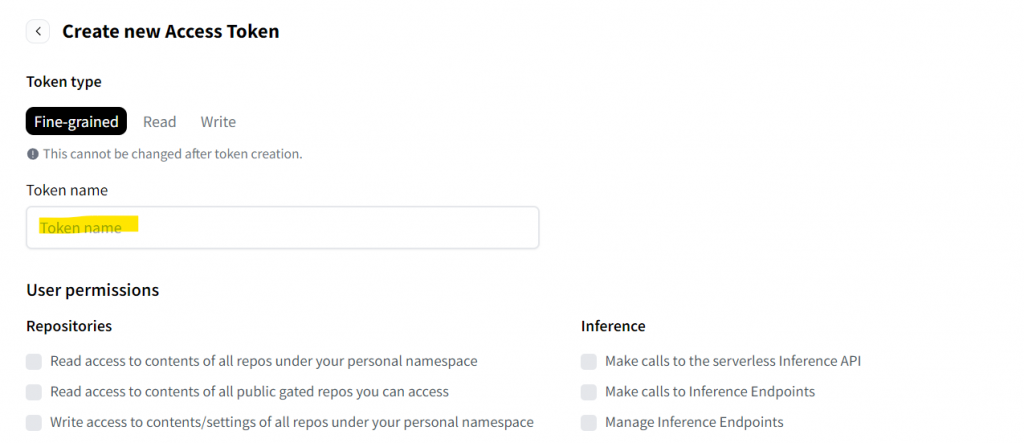

這邊先停一下,到 huggingface 註冊帳號,申請 Access Tokens。

https://huggingface.co/settings/tokens

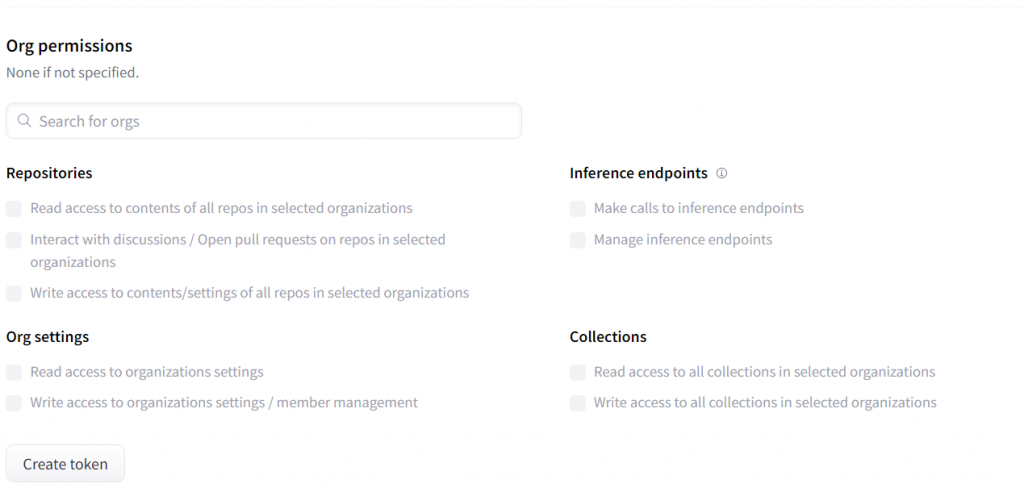

輸入好名稱,權限可以先都不開,拉到底點 Create token。

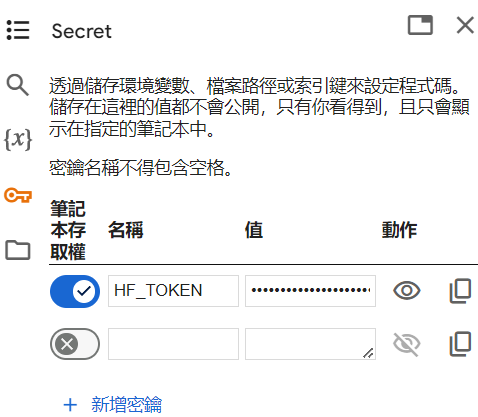

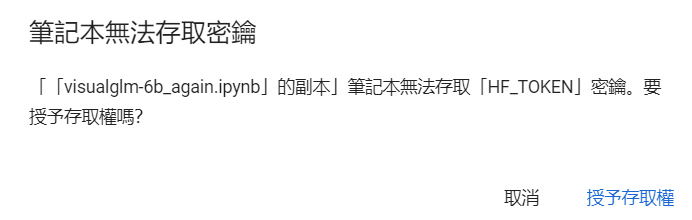

記下 token,回到 colab,在左手邊密鑰區,新增一個 HF_TOKEN,並把剛剛的 token 貼到值,並開給他筆記本存取權。這在稍後 transformers 去使用 huggingface 的 model 會用到。

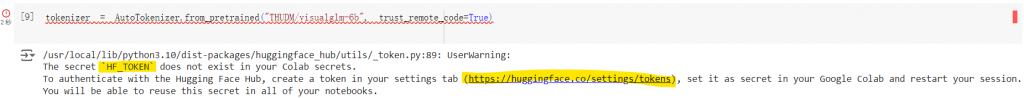

如果沒申請,或是沒給筆記本存取權,也會有提醒,很貼心。

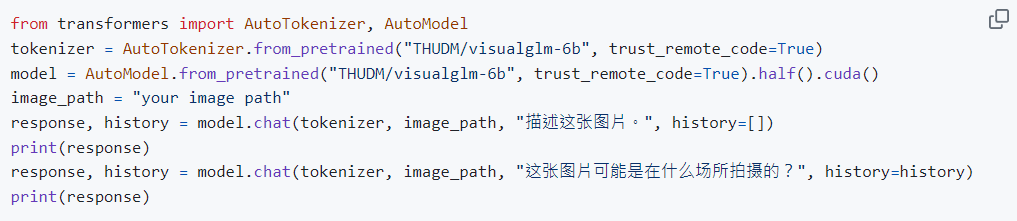

接著就可以使用 README 的範例來測試了,可以上傳一張影像到 colab 中,your image path 改成自己的影像名

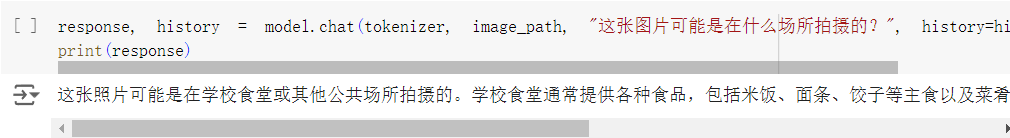

會得到這樣的結果: