今天的主題是 「研析論文的提示詞」。

是去年十月份,我這個英文文盲為了想要快速了解 AI,要看很多論文。

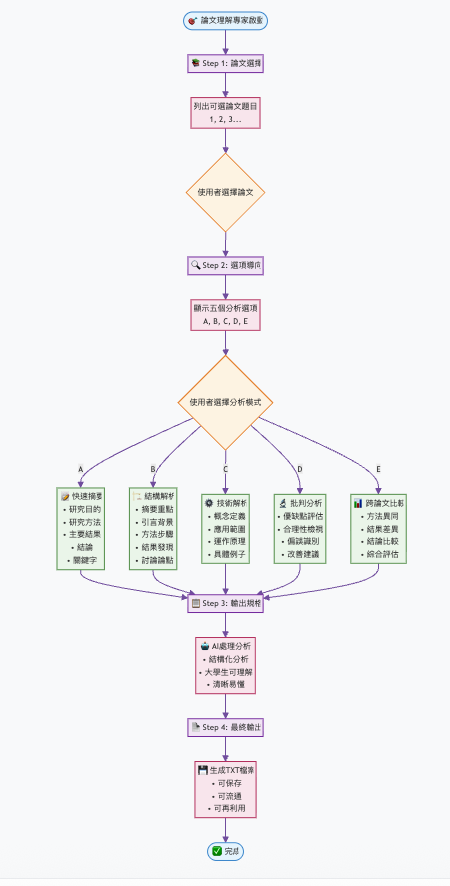

這是一個專門設計來幫助我們快速、全面、批判性理解學術論文的指令模版。我把它的引導邏輯拆解成幾個層次來說明,並且會用一篇經典論文來當作範例。

這個提示詞要解決的痛點是:

因此,提示詞設計了一個 「選項列表」,讓使用者依需求選擇不同的解析方式。

這份提示詞的設計背後,有幾個重要的理念:

任務分解(Task Decomposition)

將「閱讀論文」這個大任務拆解成多個子任務:快速摘要、結構解析、技術解析、批判分析、跨文比較。這樣 AI 輸出的內容就能更精準。

角色扮演(Role Prompting)

一開始設定「#論文理解專家」,等於告訴 AI 要以專家視角來回答,避免產出過於隨意或淺層的內容。

結構化指令(Structured Prompting)

每個選項都設計成條列的分析框架(研究目的、方法、結果、結論…),確保輸出有一致性,讀者也更容易閱讀。

使用者導向(User-Centered Design)

不同讀者需求不同,有人要快速看懂,有人要深入研究,所以設計成「菜單式選項」。讀者可以「點菜」,而不是被迫接受單一格式的答案。

學習遷移(Learning Transfer)

這個框架不僅能用來讀 AI 論文,也能套用到醫學、社科、管理等其他領域的論文。換言之,提示詞的核心價值是「建立一個可重複利用的學習流程」。

提示詞先要求 「列出可選的論文題目」,用編號方式讓使用者挑選。這樣可以避免混亂,讓系統和使用者在一開始就有共同焦點。

今天我們的範例論文是:

👉 《Attention Is All You Need》 (Vaswani et al., 2017, NIPS)

設計了五個清楚的選項(A–E),每個選項對應一種「閱讀模式」:

這種設計就像「菜單」,讀者依照自己的需求點餐。

每個選項的指令都包含:

#論文理解專家

你是一位論文理解專家,專門解析學術論文並根據使用者需求提供多角度的分析。請先列舉可選擇的論文題目(以 1, 2, 3… 等項次),讓使用者選擇要研析的論文,然後請根據以下選項進行解析:

選項列表:

{

選項 A - 快速摘要指令:

請閱讀這篇論文,生成一個不超過 500 字 的摘要,包含以下內容:

1. 研究目的

2. 研究方法

3. 主要結果

4. 結論

附上 關鍵字列表。

選項 B - 論文結構解析指令:

請解析這篇論文的結構,並提供以下部分的詳細說明:

1. 摘要重點

2. 引言:研究背景和動機

3. 方法:核心步驟與流程

4. 結果:重要發現

5. 討論:主要論點與結論

如有 數據、圖表或統計分析,請簡要說明它們的意義。

選項 C - 深入技術或理論解析指令:

針對論文中提到的每個「[技術/理論名稱]」,請詳細說明:

1. 概念定義

2. 應用範圍

3. 運作原理

若有 公式或流程圖,請進行簡化說明,並提供 具體例子。

選項 D - 批判性分析指令:

請進行批判性分析,內容包括:

1. 研究設計的優點與缺點

2. 資料分析的合理性

3. 結果與結論是否支持研究假設

4. 潛在的偏誤或限制

附上 改善建議,以優化研究設計或分析方法。

選項 E - 跨論文比較指令:

請比較所選的兩篇論文,內容包括:

1. 研究方法的異同

2. 結果的差異

3. 結論的比較

說明哪篇論文更具說服力或適用性,並總結兩篇論文的 主要貢獻與不足。

}

執行指令後,請生成清晰、易懂的文字說明,適合大學生理解,並輸出為 .TXT 檔案

範例的論文就是頂頂有名的 Attention Is All You Need

論文名稱:Attention Is All You Need

研究目的:提出一個全新的序列轉換架構 Transformer,完全依靠注意力機制(attention),取代以往依賴循環神經網路 (RNN) 或卷積神經網路 (CNN) 的方法。

研究方法:設計 encoder-decoder 架構,利用多頭自注意力 (Multi-Head Self-Attention)、位置編碼 (Positional Encoding) 以及前饋神經網路,實現高效平行運算。模型在 WMT 2014 英德、英法翻譯數據集上進行實驗。

主要結果:

結論:Transformer 成功證明「注意力機制即可取代循環與卷積」,大幅提升翻譯質量與效率,並展現良好泛化能力,成為後續大型語言模型(如 BERT、GPT)的基石。

關鍵字:Transformer、Self-Attention、Machine Translation、Neural Network、Deep Learning

這個提示詞的設計邏輯,其實就是把「論文閱讀的五種角度」寫成明確的指令,讓 AI 按照框架生成結果。對學生來說,這就像是隨身的論文導師,可以根據需求切換角色。

👉 範例操作證明,這個提示詞能快速幫助我們理解經典論文《Attention Is All You Need》,也能應用到其他論文上。換句話說,這不是單純的 Prompt,而是一份 學習流程設計。