想像一下,你每天打開社交平台,數秒內就能看到朋友的最新動態、感興趣的內容推薦,以及可能認識的新朋友。這看似簡單的動態牆背後,是一個每秒處理數百萬請求、為數十億用戶個人化內容的複雜系統。今天的社交動態牆早已不是簡單的時間軸排序。它需要在毫秒內從數千則貼文中篩選出最相關的內容,預測你的互動行為,同時確保內容的多樣性與新鮮度。這個系統如何在規模、個人化與效能之間取得平衡?讓我們深入探討現代動態牆系統的架構設計。

一個典型的社交媒體平台需要為每位用戶提供個人化的內容體驗。用戶打開應用時,期望立即看到朋友的最新動態、感興趣的話題討論,以及可能喜歡的新內容。系統必須在極短時間內完成內容的收集、排序、過濾與呈現。

這個系統的核心價值在於連結人與內容,透過智慧推薦提升用戶參與度,同時為內容創作者提供曝光機會,形成活躍的社群生態系統。

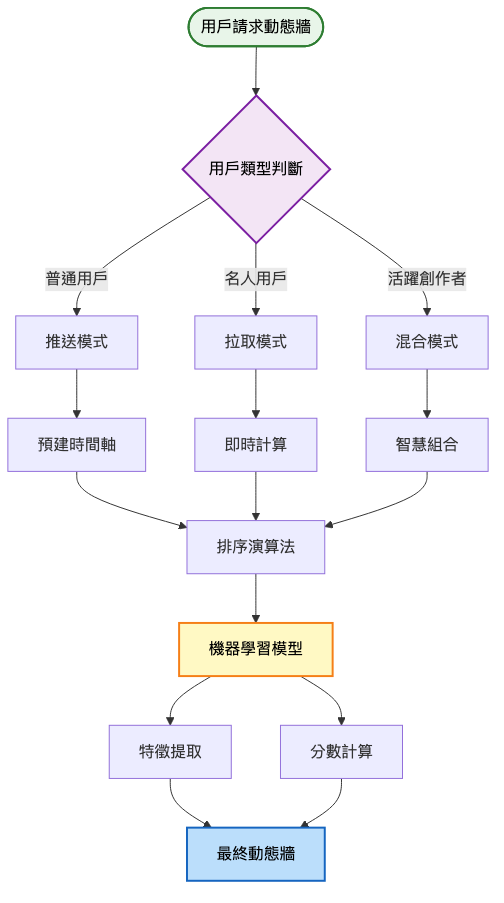

技術挑戰 1:推送模式 vs 拉取模式的選擇

技術挑戰 2:內容排序與個人化推薦

技術挑戰 3:名人帳號的扇出(Fan-out)問題

| 純推送架構 | 純拉取架構 | 混合架構 | |

|---|---|---|---|

| 核心特點 | 預先計算動態牆 | 即時組合內容 | 智慧切換策略 |

| 讀取效能 | O(1) 極快 | O(N) 較慢 | O(1) ~ O(log N) |

| 寫入成本 | O(粉絲數) 高 | O(1) 低 | 動態調整 |

| 儲存需求 | 高(預存所有動態牆) | 低(只存原始內容) | 中等 |

| 即時性 | 優秀 | 一般 | 可調控 |

| 適用場景 | 小規模社交 | 內容平台 | 大型社交網路 |

| 複雜度 | 低 | 中 | 高 |

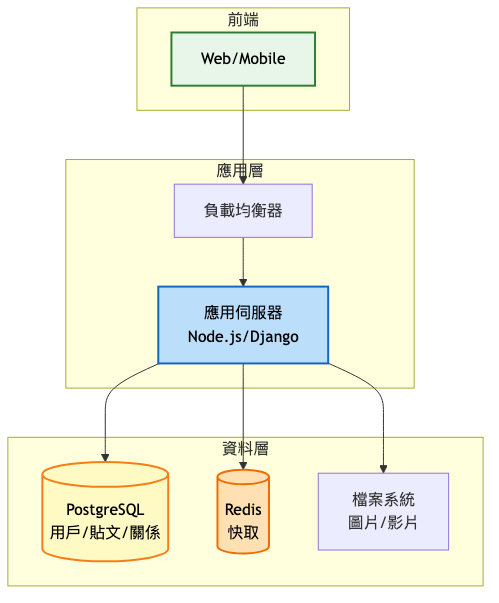

架構重點:

系統架構圖:

核心設計決策:

架構演進重點:

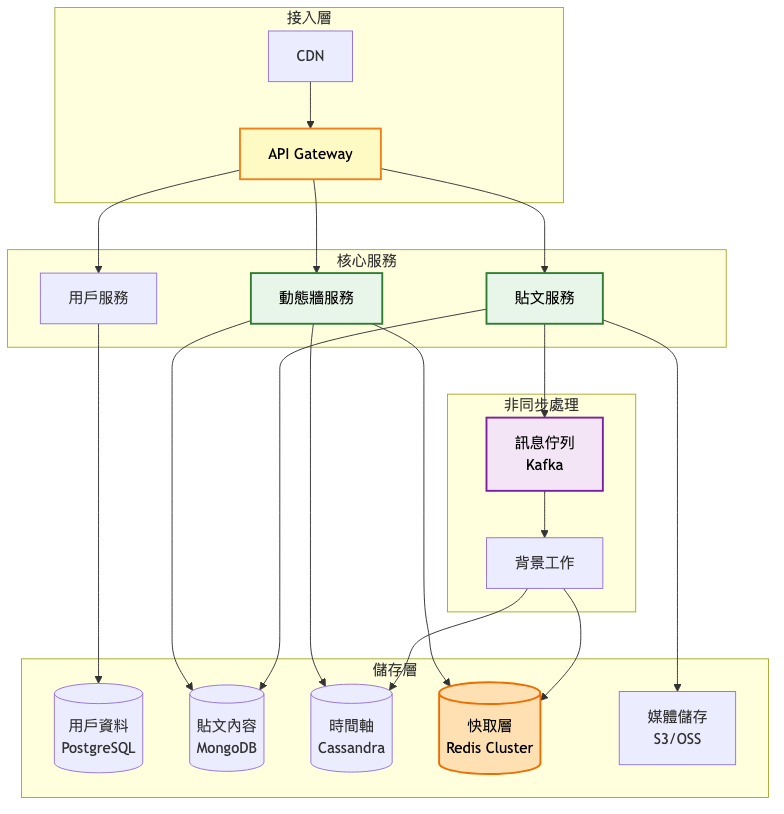

系統架構圖:

關鍵架構變更:

服務化拆分

混合推拉模式

if (粉絲數 < 10000) {

// 推送模式:預先計算並儲存

推送到粉絲時間軸

} else {

// 拉取模式:讀取時即時組合

標記為需要即時拉取

}

資料庫專門化

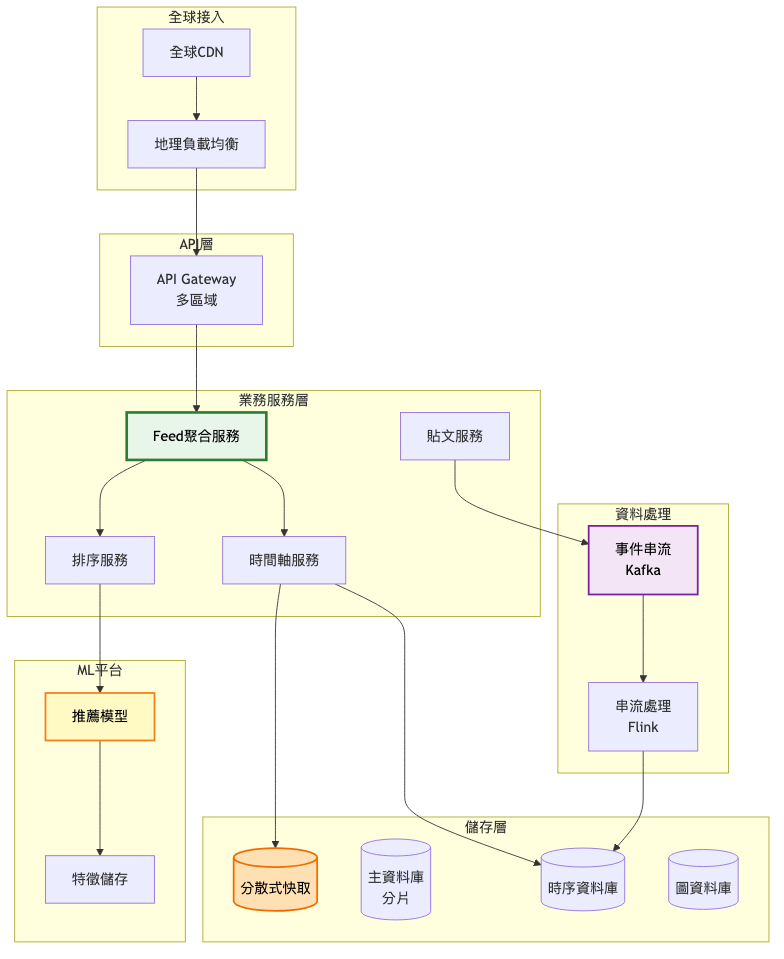

企業級架構特點:

簡化架構圖(核心流程):

架構重點說明:

Feed 聚合服務(核心)

ML 驅動的排序

資料分片策略

階段演進對比表:

| 架構特性 | MVP階段 | 成長期 | 規模化 |

|---|---|---|---|

| 架構模式 | 單體應用 | 服務化 | 微服務 |

| 動態牆策略 | 純推送 | 混合模式 | 智慧混合+ML |

| 資料庫 | 單一 PostgreSQL | 多類型資料庫 | 分片+專門化 |

| 快取策略 | 單機 Redis | Redis Cluster | 多層分散式快取 |

| 訊息處理 | 同步處理 | 簡單佇列 | 串流處理平台 |

| 部署方式 | 單區域 | 主從備份 | 多區域主動-主動 |

| 團隊規模 | 2-5人 | 10-30人 | 50+人 |

| 日活躍用戶 | < 10萬 | 10萬-1000萬 | 1000萬+ |

| 技術債務處理 | 快速迭代 | 逐步重構 | 持續優化 |

演進策略要點:

平滑過渡原則

關鍵決策時機

技術債務管理

這樣的演進路徑設計確保了系統能夠根據實際業務成長需求,逐步升級架構複雜度,避免過度設計或架構滯後的問題。

| 技術選項 | 優勢 | 劣勢 | 適用場景 |

|---|---|---|---|

| PostgreSQL | ACID保證、豐富查詢 | 擴展性限制 | 用戶資料、元數據 |

| Cassandra | 線性擴展、高寫入 | 查詢彈性低 | 時間序列資料 |

| MongoDB | 彈性Schema、易擴展 | 一致性較弱 | 內容儲存 |

| Neo4j | 圖查詢效能優異 | 擴展性挑戰 | 社交關係 |

| HBase | 海量資料、高吞吐 | 運維複雜 | 用戶行為日誌 |

| 技術選項 | 優勢 | 劣勢 | 適用場景 |

|---|---|---|---|

| Redis | 豐富資料結構、高效能 | 記憶體成本高 | 熱點資料、排行榜 |

| Memcached | 簡單高效、穩定 | 功能單一 | 簡單鍵值快取 |

| Hazelcast | 分散式計算能力 | 學習曲線陡 | 複雜快取場景 |

| 本地快取 | 零網路延遲 | 一致性挑戰 | 靜態配置、熱點 |

過早優化陷阱

扇出爆炸問題

快取雪崩風險

Facebook(現稱 Meta) 的動態牆演進歷程

參考資料

初期(2006-2010)

成長期(2010-2015)

成熟期(2015-2025)

Twitter(現稱 X) 的時間軸架構

參考資料

初期(2006-2010)

轉型期(2010-2013)

優化期(2013-今)

1. 扇出寫入模式(Fanout-on-Write)

2. 扇出讀取模式(Fanout-on-Read)

3. 事件溯源模式(Event Sourcing)

技術指標:

業務指標:

自動化監控告警

A/B 測試框架

持續優化流程

針對今日探討的社交媒體動態牆系統設計,建議可從以下關鍵字或概念深化研究與實踐,以擴展技術視野與解決方案能力:

圖神經網路(GNN):透過進一步學習此領域相關理論與案例,能加強對社交關係建模與內容推薦的理解與應用。

聯邦學習(Federated Learning):這部分涉及的隱私保護個人化技術,適合深入掌握以因應未來的隱私法規要求。

串流處理框架(Apache Flink/Kafka Streams):探索即時資料處理的本質及其最佳實踐,幫助設計更具即時性的動態牆系統。

多目標優化(Multi-Objective Optimization):關注如何平衡相關性、多樣性、新鮮度等多個目標,提升推薦品質。

邊緣運算(Edge Computing):了解如何將部分計算下放到邊緣節點,降低延遲並節省頻寬成本。

可根據自身興趣,針對上述關鍵字搜尋最新技術文章、專業書籍或參加線上課程,逐步累積專業知識和實踐經驗。

明天我們將探討「線上問答平台」的系統設計。不同於今天的動態牆系統著重時效性,問答平台更注重內容品質與知識沉澱。我們會深入探討如何設計投票機制、專家認證系統,以及如何在海量問答中快速找到高品質答案。這個系統如何平衡內容品質與社群活躍度?如何防止劣幣驅逐良幣?讓我們明天一起探索這些有趣的挑戰。

Meta (Facebook) Engineering

Twitter/X Engineering

LinkedIn Engineering

架構設計文件

社交媒體演算法分析