想像你正在使用 Stack Overflow 尋找一個技術問題的答案。你輸入關鍵字,系統在數十億條內容中瞬間找到最相關的結果。當你為優質答案點讚時,該回答的排名立即上升。

這看似簡單的互動背後,隱藏著極其複雜的系統設計挑戰:如何在海量內容中實現毫秒級搜尋?如何設計一個既能激勵高品質回答又能防止作弊的投票系統?如何識別並突顯領域專家?

今天,我們將深入探討線上問答平台的架構設計。儘管在 AI 時代,開發者越來越依賴 AI 工具解決、詢問問題,Stack Overflow 的流量確實有所下降,但它仍是技術知識沉澱的寶庫,更重要的是——它創造了一個架構奇蹟:用極簡的單體架構支撐起每月數億次請求。這個「無聊技術」打造的高效系統,至今仍是系統設計的經典案例,值得我們深入學習。

線上問答平台是知識經濟時代的基礎設施。從技術問答的 Stack Overflow,到綜合知識平台的 Quora,這類系統承載著人類知識的累積與傳播。平台的核心價值在於連接提問者與解答者,透過社群的力量產生高品質的知識內容,並使這些內容可被搜尋、評價和改進。

技術挑戰 1:海量內容的高效搜尋

平台需要在數億條問答中實現毫秒級的全文搜尋,同時保證搜尋結果的相關性和品質。這不僅需要強大的搜尋引擎,還需要精心設計的相關性算法。

技術挑戰 2:實時投票與排序系統

投票系統必須防止作弊行為,同時實現即時的分數更新和內容重新排序。這涉及複雜的反作弊機制和高效的快取策略。

技術挑戰 3:專家識別與內容品質控制

如何在龐大的用戶群體中識別真正的領域專家?如何激勵高品質內容的產生?這需要精密的聲望系統和智慧的內容審核機制。

| 單體架構 | 微服務架構 | Serverless 架構 | |

|---|---|---|---|

| 核心特點 | 單一應用、共享資料庫、效能優先 | 服務拆分、獨立部署、領域驅動 | 無伺服器、事件驅動、按需計費 |

| 優勢 | 極高效能、簡單維護、低延遲 | 獨立擴展、技術多樣性、故障隔離 | 零運維、自動擴展、成本優化 |

| 劣勢 | 擴展受限、技術單一、部署風險 | 複雜度高、網路開銷、資料一致性 | 冷啟動延遲、廠商鎖定、調試困難 |

| 適用場景 | 中小規模、效能敏感、團隊精簡 | 大規模、多團隊、業務複雜 | 流量波動大、原型開發、成本敏感 |

| 複雜度 | 低 | 高 | 中 |

| 成本 | 中等(需要預配置資源) | 高(多服務運維) | 變動(按使用付費) |

架構重點:

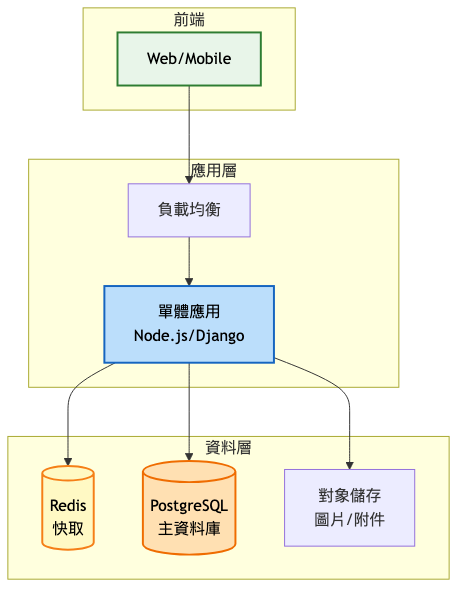

系統架構圖:

核心設計決策:

架構演進重點:

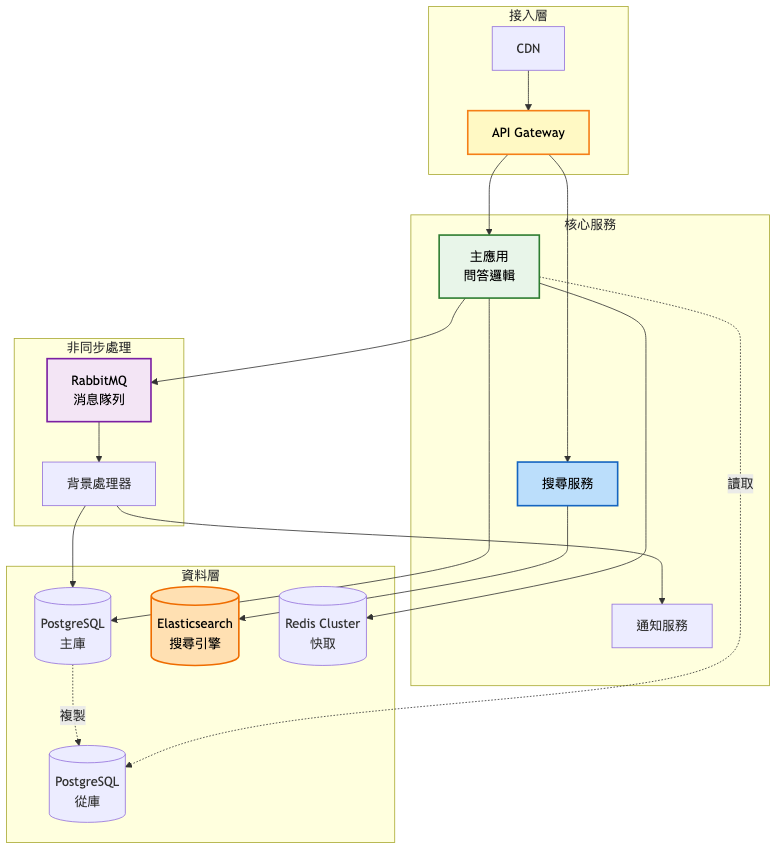

系統架構圖:

關鍵架構變更:

搜尋系統升級

投票系統優化

資料庫讀寫分離

預期效能提升對比:

| 指標 | 第一階段 | 第二階段改善 |

|---|---|---|

| 頁面載入 | 3-5秒 | 1-2秒 |

| 搜尋響應 | 500ms | 50ms |

| 投票延遲 | 200ms | 10ms |

| 併發支援 | 1K QPS | 10K QPS |

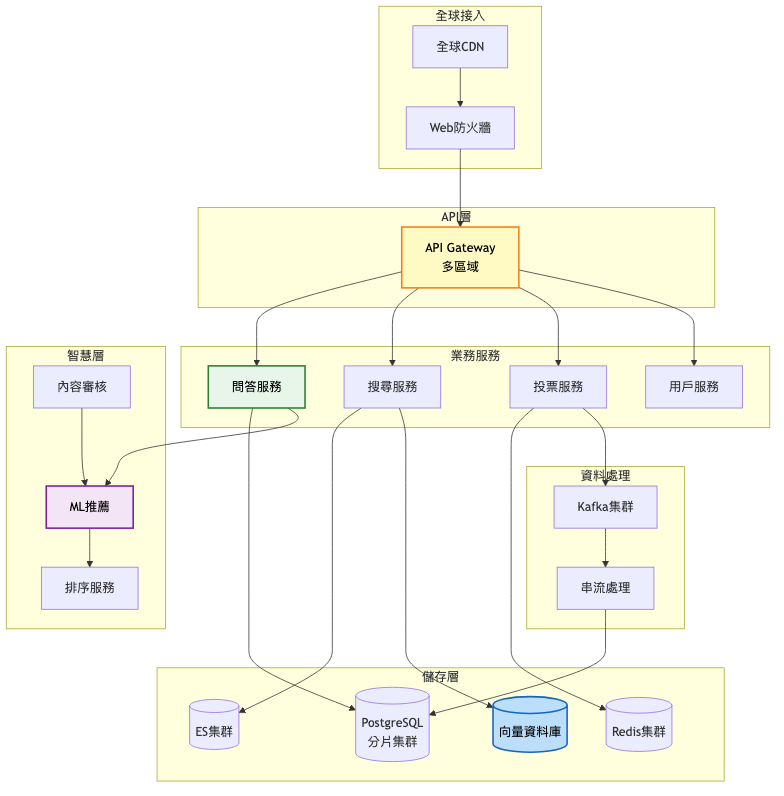

企業級架構特點:

系統架構圖:

架構重點說明:

服務完全拆分

智慧化升級

資料層優化

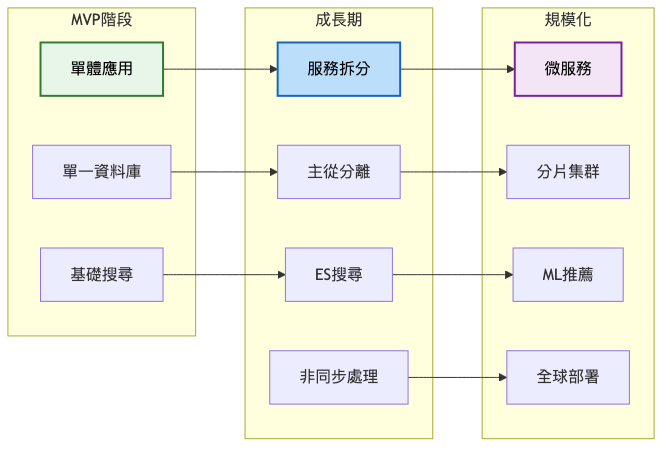

階段演進總覽:

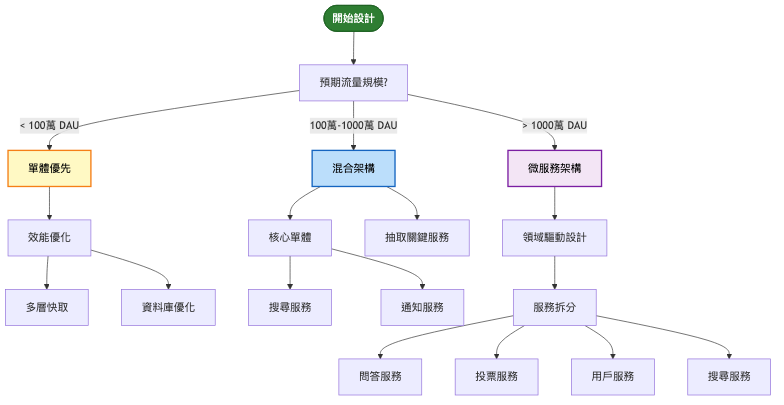

演進決策指南:

| 觸發條件 | 採取行動 | 預期效果 |

|---|---|---|

| 搜尋延遲 > 200ms | 部署 Elasticsearch | 延遲降至 50ms |

| 資料庫 CPU > 70% | 實施主從分離 | CPU 降至 30% |

| 投票延遲 > 100ms | 引入消息隊列 | 延遲降至 10ms |

| DAU > 50萬 | 開始服務拆分 | 獨立擴展能力 |

| 內容增長 > 1000萬條 | 引入向量搜尋 | 重複問題檢測 |

| 全球用戶 > 20% | 多區域部署 | 降低跨區延遲 |

| 技術選項 | 優勢 | 劣勢 | 適用場景 |

|---|---|---|---|

| Elasticsearch | 即時分析、JSON原生、豐富插件生態 | 記憶體消耗大、配置複雜 | 即時搜尋、日誌分析、複雜聚合 |

| Solr | 成熟穩定、記憶體效率高、企業特性完善 | 配置繁瑣、社群活躍度降低 | 企業搜尋、靜態索引、批量處理 |

| Algolia | 託管服務、開箱即用、AI排序 | 成本高、客製化受限 | 快速原型、小規模應用 |

| PostgreSQL FTS | 簡單整合、無額外組件、事務支援 | 功能有限、性能瓶頸 | MVP階段、簡單搜尋需求 |

| 技術選項 | 優勢 | 劣勢 | 適用場景 |

|---|---|---|---|

| Redis | 高性能、豐富資料結構、持久化選項 | 單執行緒限制、記憶體成本 | 熱點資料、計數器、會話管理 |

| Memcached | 極簡設計、多執行緒、記憶體效率 | 功能單一、無持久化 | 純快取場景、簡單鍵值對 |

| Hazelcast | 分散式計算、自動分片、近快取 | 學習曲線陡、Java生態 | 企業應用、分散式計算 |

過早優化陷阱

忽視快取失效

投票作弊防護不足

Stack Overflow 的極致優化

參考文章

初期(2008-2010)

成長期(2010-2016)

成熟期(2016-至今)

// 使用向量相似度檢測重複問題

interface DuplicateDetector {

// 將問題轉換為向量表示

async vectorize(question: string): Promise<number[]> {

// 使用預訓練模型(如 Sentence-BERT)

const embedding = await this.model.encode(question);

return embedding;

}

// 查找相似問題

async findSimilar(

questionVector: number[],

threshold: number = 0.85

): Promise<SimilarQuestion[]> {

// 使用向量資料庫進行相似度搜尋

const results = await this.vectorDB.search({

vector: questionVector,

topK: 10,

minScore: threshold

});

return results.map(r => ({

id: r.id,

title: r.metadata.title,

similarity: r.score

}));

}

}

// 使用 Redis + 消息隊列的投票系統

class VoteService {

async vote(userId: string, postId: string, value: 1 | -1) {

// 1. 檢查是否已投票(Redis)

const voteKey = `vote:${postId}:${userId}`

const existing = await redis.get(voteKey)

if (existing) {

// 更新投票

const diff = value - parseInt(existing)

await redis.incrby(`score:${postId}`, diff)

} else {

// 新投票

await redis.incrby(`score:${postId}`, value)

}

// 2. 記錄投票(Redis)

await redis.set(voteKey, value, 'EX', 86400 * 30) // 30天過期

// 3. 發送非同步持久化消息

await queue.send('vote-persistence', {

userId,

postId,

value,

timestamp: Date.now(),

})

// 4. 返回新分數

return await redis.get(`score:${postId}`)

}

}

技術指標:

業務指標:

自動化策略

監控告警

持續優化

針對今日探討的線上問答平台系統設計,建議可從以下關鍵字或概念深化研究與實踐,以擴展技術視野與解決方案能力:

向量搜尋與語義理解:透過學習 FAISS、Pinecone、Weaviate 等向量資料庫,掌握基於深度學習的語義搜尋技術,提升問答匹配的準確性。

圖神經網路(GNN):研究如何用圖結構建模問答關係,學習 GraphSAGE、GAT 等算法在推薦系統中的應用。

BERT 與 Transformer 模型:深入理解預訓練語言模型在問答系統中的應用,包括問題理解、答案生成和相關性判斷。

分散式一致性協議:探索 Raft、Paxos 等協議在分散式投票系統中的應用,確保資料一致性。

時間序列資料庫:學習 InfluxDB、TimescaleDB 在用戶行為分析和趨勢預測中的應用。

可根據自身興趣,針對上述關鍵字搜尋最新技術文章、專業書籍或參加線上課程,逐步累積專業知識和實踐經驗。

明天我們將探討「影片串流平台」的系統設計。從 Netflix 到 YouTube,這些平台如何處理 PB 級的影片資料?如何實現全球內容分發?自適應串流技術如何確保流暢的觀看體驗?我們將深入剖析影片串流背後的技術奧秘,包括轉碼系統、CDN 架構、以及邊緣計算的應用。準備好迎接更大規模的系統設計挑戰了嗎?

不知道各位細心得讀者有沒有發現,這篇在「系統演進路徑」章節寫法有些不同。

架構演進不一定只是技術的堆疊,而是對瓶頸的精準回應。

比如:

這樣的調整是希望各位能夠發現一件事:架構演進是有跡可循的,每個升級都有明確的理由和時機。