想像一下,每秒有數百萬人同時點擊播放按鈕,期待在三秒內看到清晰流暢的影片。當你在深夜追劇時,Netflix 如何確保全球 2.3 億用戶都能享受不中斷的觀影體驗?當一場世界盃決賽開始時,YouTube 怎麼處理瞬間湧入的億級流量?

這些看似理所當然的體驗背後,藏著無數工程師精心設計的複雜系統。一個成功的串流平台不只是把影片檔案傳給用戶那麼簡單,而是需要在儲存成本、串流品質、網路延遲、個人化推薦等多個維度找到最佳平衡點。

今天我們將深入探討影片串流平台的架構設計,從最基礎的影片上傳處理,到全球規模的內容分發網路,理解如何建構一個能夠承載億級用戶的影片串流系統。

現代影片串流平台已經成為全球娛樂產業的核心基礎設施。從個人創作者的 Vlog 到好萊塢大片,從即時遊戲直播到企業培訓課程,影片內容的形式和場景日益豐富。一個成功的串流平台必須同時滿足內容創作者的發布需求和觀眾的觀看體驗,並在兩者之間建立可持續的商業模式。

這個系統的核心價值在於讓任何人都能輕鬆分享影片內容,並確保全球觀眾都能獲得高品質的觀看體驗,無論他們使用什麼設備或網路環境。

技術挑戰 1:海量影片儲存與成本控制

每分鐘有 500 小時的影片上傳到 YouTube,一支 10 分鐘的 4K 影片原始檔案就需要 10GB 儲存空間,轉碼後的多個版本更需要額外 20GB。如何在保證可用性的同時控制儲存成本成為關鍵挑戰。

技術挑戰 2:全球內容分發與延遲優化

用戶分佈全球各地,網路環境差異極大。如何確保南美洲的用戶觀看美國上傳的影片時,也能獲得流暢體驗?這涉及 CDN 部署策略、邊緣快取、智慧路由等複雜技術決策。

技術挑戰 3:個人化推薦與即時運算

在數億影片中,如何在毫秒內為每個用戶找到最感興趣的內容?推薦系統需要處理用戶行為數據、影片特徵、社交關係等多維度信息,並在極短時間內產生推薦結果。

| 單體架構 | 微服務架構 | 無伺服器架構 | |

|---|---|---|---|

| 核心特點 | 所有功能在單一應用中實現 | 功能拆分為獨立服務 | 事件驅動的函數執行 |

| 優勢 | 開發簡單、部署容易、延遲低 | 獨立擴展、技術多樣性、故障隔離 | 零管理、按需付費、自動擴展 |

| 劣勢 | 擴展困難、技術債累積、部署風險高 | 複雜度高、網路開銷大、數據一致性難 | 冷啟動問題、廠商鎖定、調試困難 |

| 適用場景 | MVP 階段、小規模團隊 | 大規模系統、多團隊協作 | 事件處理、批次任務、輔助功能 |

| 複雜度 | 低 | 高 | 中 |

| 成本 | 初期低、後期高 | 持續中等 | 按使用量計費 |

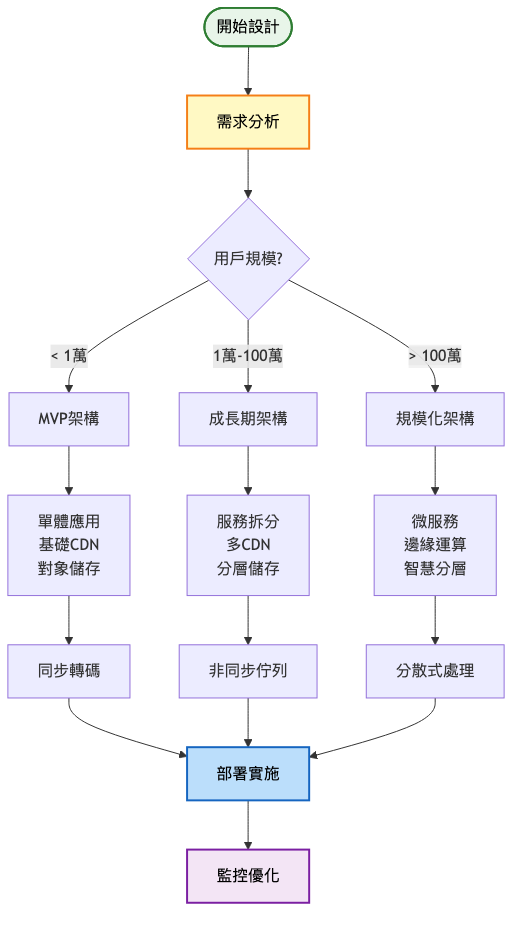

架構重點:

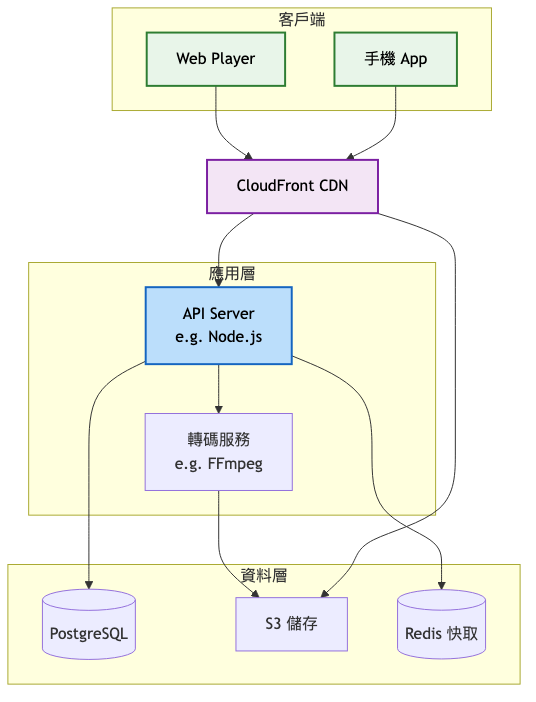

系統架構圖:

關鍵設計要點:

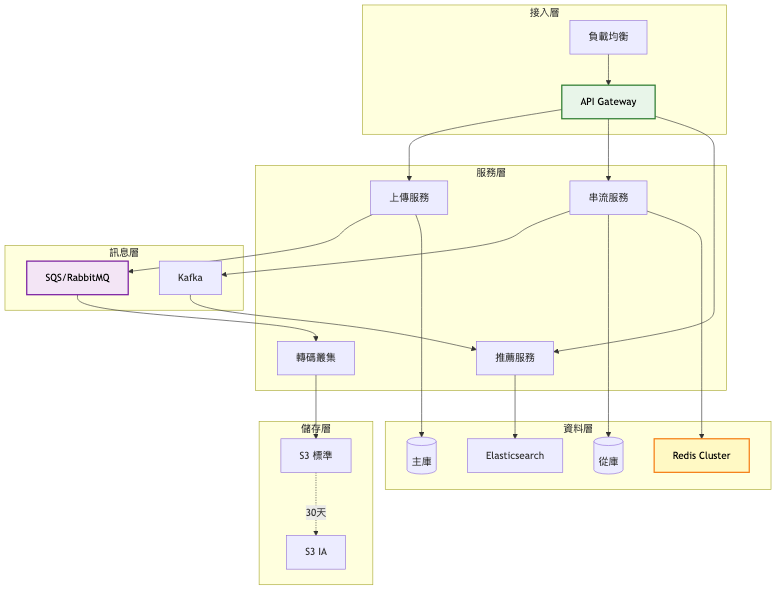

架構重點:

系統架構圖:

關鍵架構變更:

服務拆分與訊息佇列

引入 HLS/DASH 自適應串流

資料庫讀寫分離

預期效能提升對比表:

| 指標 | 第一階段 | 第二階段 | 改善幅度 |

|---|---|---|---|

| 轉碼吞吐量 | 100 影片/小時 | 1000 影片/小時 | 10x |

| API 回應時間 | 200ms | 50ms | 75% |

| 緩衝事件率 | 2% | 0.8% | 60% |

| 儲存成本 | $10/TB | $6/TB | 40% |

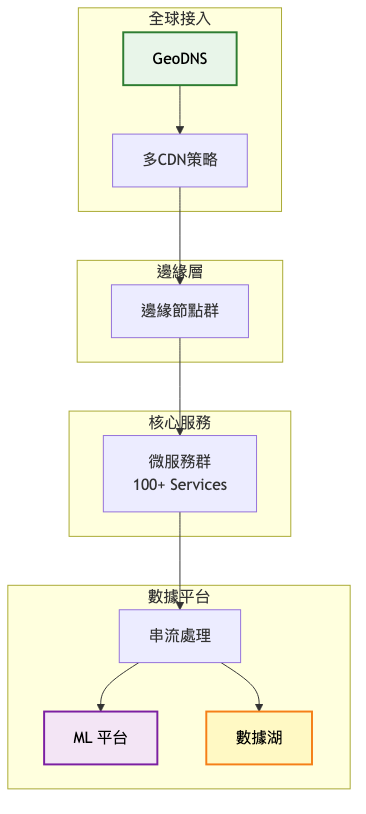

架構重點:

總覽架構圖:

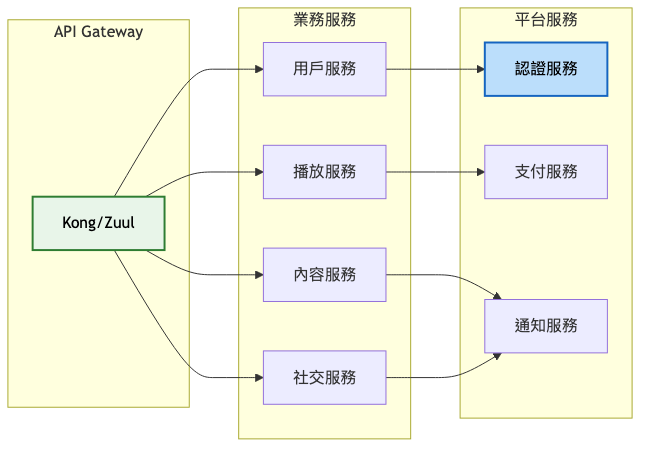

核心服務架構圖:

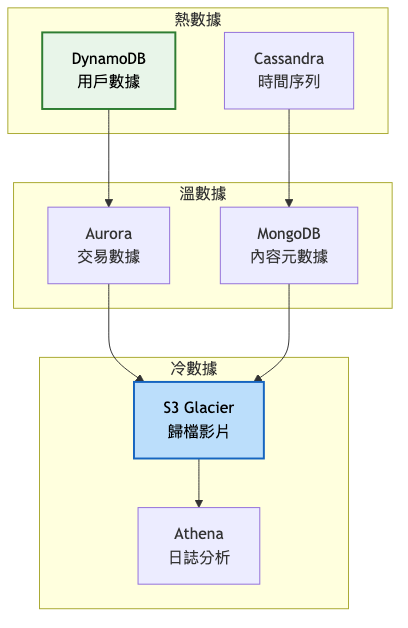

資料架構圖:

架構演進對比表格:

| 架構特性 | MVP階段 | 成長期 | 規模化 |

|---|---|---|---|

| 架構模式 | 單體應用 | 服務化 | 微服務 |

| 資料庫 | 單一資料庫 | 主從分離 | 分片集群 |

| 快取策略 | 簡單快取 | 多層快取 | 分散式快取 |

| 部署方式 | 單機部署 | 集群部署 | 容器化/K8s |

| 團隊規模 | 2-5人 | 10-30人 | 50+人 |

| 用戶規模 | < 10萬 | 10萬-1000萬 | 1000萬+ |

演進決策指南表:

| 觸發條件 | 採取行動 | 預期效果 |

|---|---|---|

| DAU > 10萬 | 服務拆分、讀寫分離 | 回應時間降低 50% |

| 儲存 > 1PB | 引入分層儲存 | 成本降低 40% |

| 併發 > 10萬 | 多 CDN + 邊緣節點 | 可用性達 99.99% |

| 轉碼隊列 > 1000 | GPU 加速 + 分散式 | 處理速度提升 10x |

| 技術選項 | 優勢 | 劣勢 | 適用場景 |

|---|---|---|---|

| 影片編碼格式 | |||

| H.264/AVC | 通用相容性最佳、硬體支援廣泛、編碼速度快 | 壓縮效率相對較低、頻寬成本高 | 基礎服務、行動裝置、即時串流 |

| H.265/HEVC | 壓縮效率提升 50%、支援 4K/8K、HDR 支援 | 專利費用高、運算需求大、相容性有限 | 高畫質內容、智慧電視、付費內容 |

| AV1 | 開源免費、壓縮效率最佳(比 H.264 高 50%)、Netflix 採用 | 編碼速度慢(68倍)、硬體支援有限、功耗高 | 長尾內容、成本敏感場景、非即時內容 |

| 串流協議 | |||

| HLS | Apple 生態原生、相容性最佳、支援 DRM | 延遲高(10-30秒)、分片開銷大 | 點播內容、iOS 設備、一般直播 |

| LL-HLS | 低延遲(2-5秒)、向後相容、Apple 支援 | 實現複雜、CDN 支援有限 | 互動直播、體育賽事 |

| WebRTC | 超低延遲(<500ms)、P2P 支援、雙向通訊 | 擴展性差、成本高、無 CDN 支援 | 視訊會議、即時互動、小規模直播 |

| 儲存方案 | |||

| S3 標準 | 高可用(99.99%)、無限擴展、簡單管理 | 成本較高、延遲相對高 | 熱門內容、新上傳影片 |

| S3 IA | 成本降低 40%、按需存取、自動生命週期 | 最小儲存 30 天、檢索費用 | 溫內容、30 天以上影片 |

| S3 Glacier | 成本降低 68%、長期保存、合規歸檔 | 檢索延遲高(小時級)、最小 90 天 | 冷內容、合規備份、歷史歸檔 |

編碼演進採用漸進式過渡策略。初期全面使用 H.264 確保相容性,成長期為高階設備提供 H.265,成熟期引入 AV1 降低長尾內容成本。維持三種格式並存,根據設備能力和內容特性動態選擇。

串流協議根據延遲需求分層部署。點播內容使用傳統 HLS,一般直播採用 LL-HLS(2-5 秒延遲),互動場景使用 WebRTC(次秒級)。建立協議轉換閘道,統一對外接口。

儲存策略實施智慧分層。新上傳內容存儲在 S3 標準,30 天後自動轉移到 S3 IA,90 天後歸檔到 Glacier。熱門內容根據存取頻率動態提升儲存等級,確保存取效能。

1. 事件驅動架構模式

2. CQRS 模式(命令查詢責任分離)

3. 邊車模式(Sidecar Pattern)

自適應位元率實現:

快取策略優化:

成本優化實踐:

過早優化陷阱

忽視成本增長

單點故障風險

Netflix 的微服務架構演進

Netflix Technology Blog - Microservices at Netflix

初期(2007-2008)

雲端轉型期(2008-2012)

微服務成熟期(2012-至今)

YouTube 的規模化挑戰

YouTube Engineering Blog

創業期(2005-2006)

Google 收購後(2006-2012)

現代化階段(2012-至今)

技術指標:

業務指標:

自動化運維體系:

監控告警分層:

問題處理流程:

針對今日探討的影片串流平台系統設計,建議可從以下關鍵字或概念深化研究與實踐,以擴展技術視野與解決方案能力:

AV1 編碼優化:透過進一步學習新一代視訊壓縮技術的理論與實踐,掌握如何在保證畫質的同時大幅降低頻寬成本。

低延遲 HLS 與 WebRTC:這部分涉及即時串流的核心技術,深入理解可幫助建構互動性更強的直播系統。

邊緣運算與 CDN 優化:探索邊緣節點的部署策略和智慧路由算法,有助於設計全球規模的內容分發網路。

機器學習推薦系統:研究協同過濾、深度學習等技術在影片推薦的應用,提升用戶參與度和留存率。

可根據自身興趣,針對上述關鍵字搜尋最新技術文章、專業書籍或參加線上課程,逐步累積專業知識和實踐經驗。

明天我們將探討「線上協作文件系統」的設計。當多個用戶同時編輯同一份文件時,系統如何處理編輯衝突?如何實現毫秒級的同步更新?Google Docs 背後的 Operational Transformation 算法有什麼神奇之處?這些挑戰將帶我們進入分散式系統中最複雜也最有趣的即時協作領域。