想像一下,你正在為一家快速成長的電商公司工作。黑色星期五即將到來,預期流量將是平日的50倍。單體架構已經無法應付業務需求——新功能上線需要重新部署整個系統,一個小bug可能導致全站崩潰,不同團隊的開發進度互相牽制。

是時候進行微服務化改造了,但這條路充滿挑戰:如何拆分服務?如何處理分散式交易?如何確保服務間通訊的效能? 今天,我們將深入探討如何設計一個能夠支撐千萬級用戶的微服務電商平台。

前情提要

還記得第一週的 Day 7,我們設計了一個簡易電商系統嗎?那時強調「不要過度設計」,用模組化單體就能處理每月數千筆訂單。但現在,讓我們快轉到幾年後——你的電商平台已經成為市場領導者,每天處理百萬筆訂單,黑色星期五的流量是平日的50倍,有20個開發團隊並行工作。

這時,Day 7 的架構開始顯露瓶頸:單體應用讓團隊互相牽制、一個模組的bug可能影響全站、擴展特定功能需要擴展整個系統。 這就是為什麼我們需要微服務架構——不是因為它很酷,而是因為業務規模真的需要它。

場景定義與需求分析

業務場景描述

一個現代電商平台不只是賣東西的網站,而是涵蓋商品管理、訂單處理、支付結算、物流配送、用戶服務、數據分析等多個複雜業務域的綜合系統。

隨著業務快速發展,原本的單體架構逐漸顯露出瓶頸:開發效率低下、部署風險高、擴展困難、技術債務累積。

微服務架構能夠解決這些問題,但同時也帶來新的挑戰:服務拆分的粒度、分散式事務的處理、服務間通訊的優化、系統複雜度的管理。

核心需求分析

功能性需求

-

用戶管理:註冊登入、個人資料、收貨地址、支付方式管理

-

商品服務:商品展示、搜尋、分類、庫存管理、價格策略

-

購物流程:購物車、訂單創建、支付處理、訂單追蹤

-

促銷系統:優惠券、滿減活動、限時特賣、積分系統

-

物流服務:配送管理、物流追蹤、退換貨處理

-

評價系統:商品評論、評分、買家秀

-

商家管理:商家入駐、商品上架、訂單管理、結算系統

非功能性需求

-

效能要求:支援每秒10萬筆訂單,API響應時間P95 < 200ms

-

可用性要求:99.99% SLA,關鍵服務零停機部署

-

擴展性要求:支援水平擴展,流量峰值自動應對

-

一致性要求:金融級數據一致性,零訂單遺失

-

安全性要求:PCI DSS合規,用戶數據加密存儲

-

成本限制:基礎設施成本控制在營收的3%以內

核心架構決策

識別關鍵問題

-

技術挑戰 1:服務拆分粒度

- 過細拆分導致管理複雜度暴增,網絡開銷增加

- 過粗拆分無法發揮微服務優勢,團隊協作困難

-

技術挑戰 2:分散式事務處理

- 傳統ACID事務無法跨服務,兩階段提交性能低下

- 最終一致性需要業務層面的理解和接受

-

技術挑戰 3:服務間通訊優化

- 同步調用導致延遲累積,可用性降低

- 異步通訊增加系統複雜度,調試困難

架構方案比較

| 維度 |

編排模式(Choreography) |

協調模式(Orchestration) |

混合模式 |

| 核心特點 |

服務自主決策,事件驅動 |

中央協調器管理流程 |

關鍵流程協調,其他編排 |

| 優勢 |

服務解耦,無單點故障 |

流程清晰,易於監控 |

靈活性與可控性平衡 |

| 劣勢 |

流程追蹤困難,調試複雜 |

協調器可能成為瓶頸 |

架構複雜度較高 |

| 適用場景 |

簡單流程,服務獨立性高 |

複雜流程,需要事務保證 |

大型系統,多種業務場景 |

| 複雜度 |

中等 |

低 |

高 |

| 成本 |

低 |

中 |

高 |

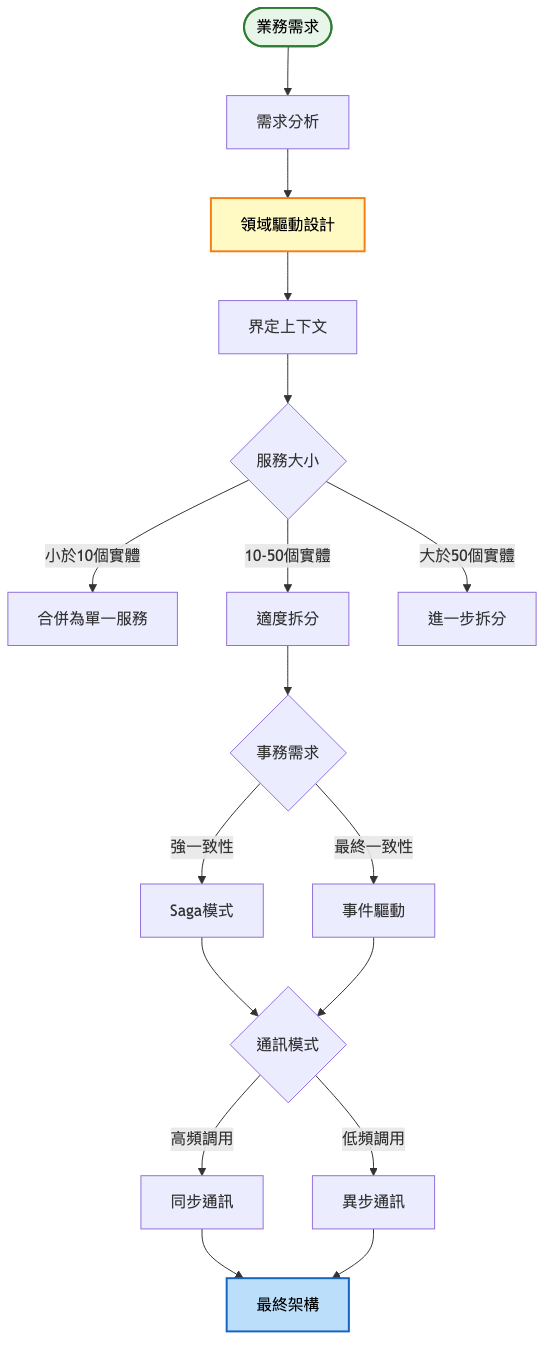

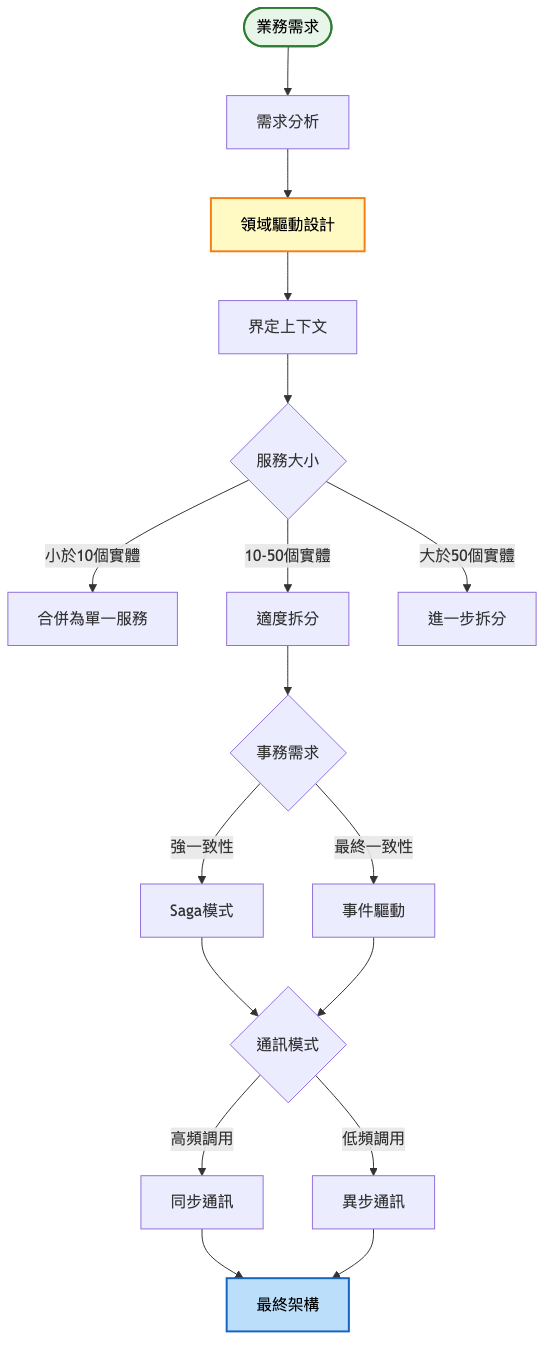

決策思考框架

系統演進路徑

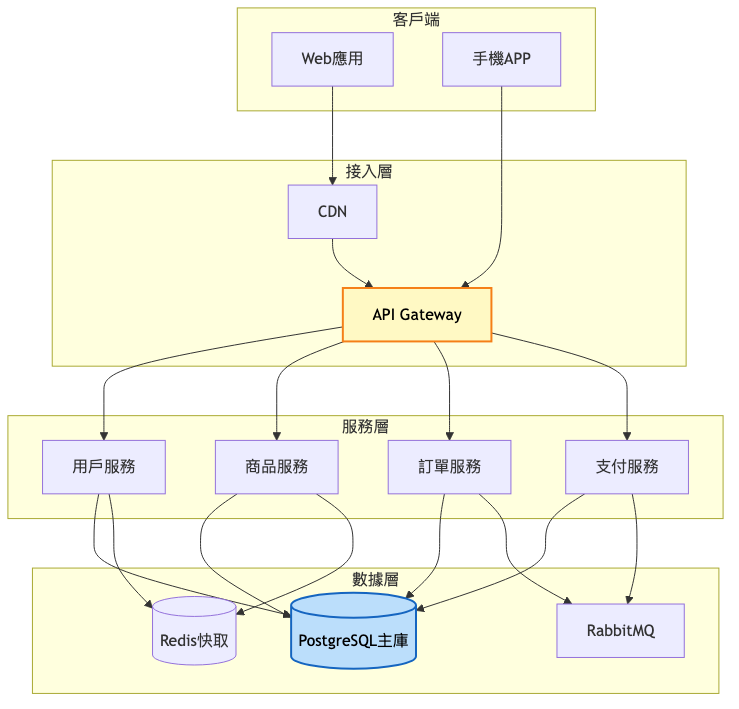

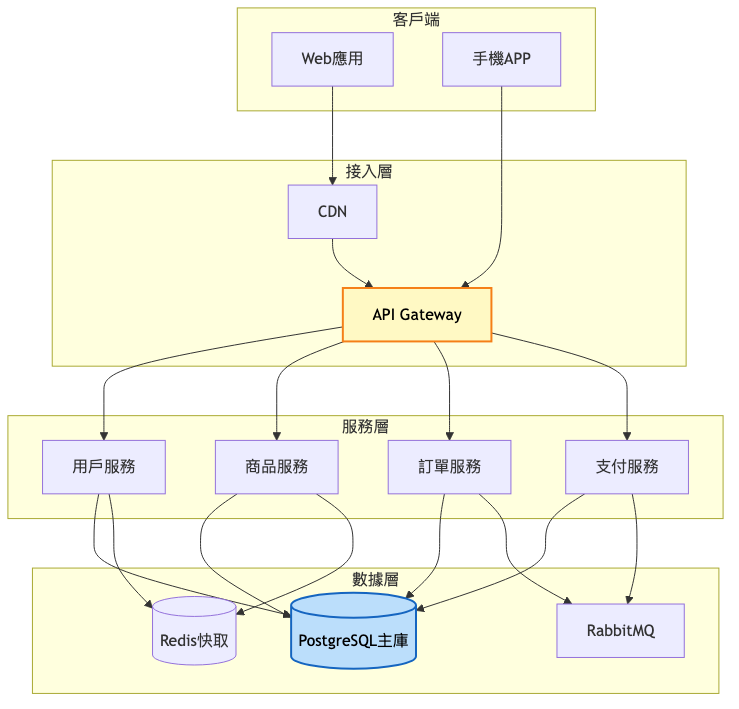

第一階段:MVP版本(0-10萬用戶)

架構重點:

- 單體應用拆分為3-5個核心服務

- 使用API Gateway統一入口

- 關係型資料庫為主,Redis做快取

- 同步調用為主,關鍵流程引入訊息佇列

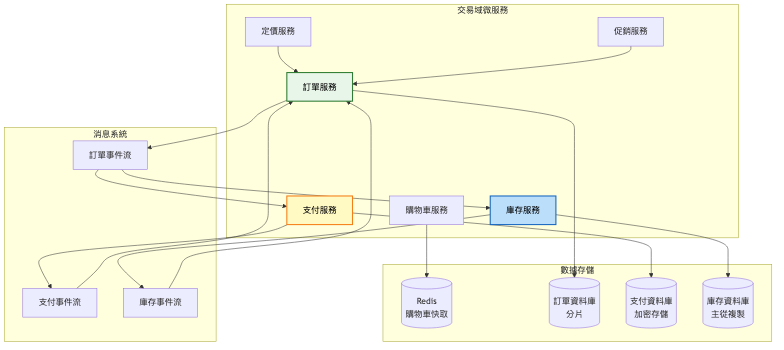

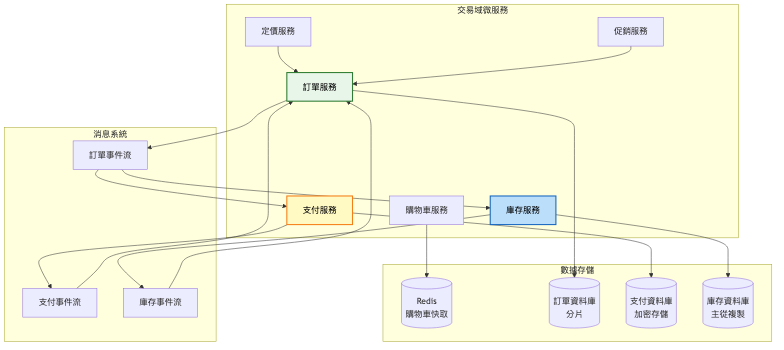

系統架構圖:

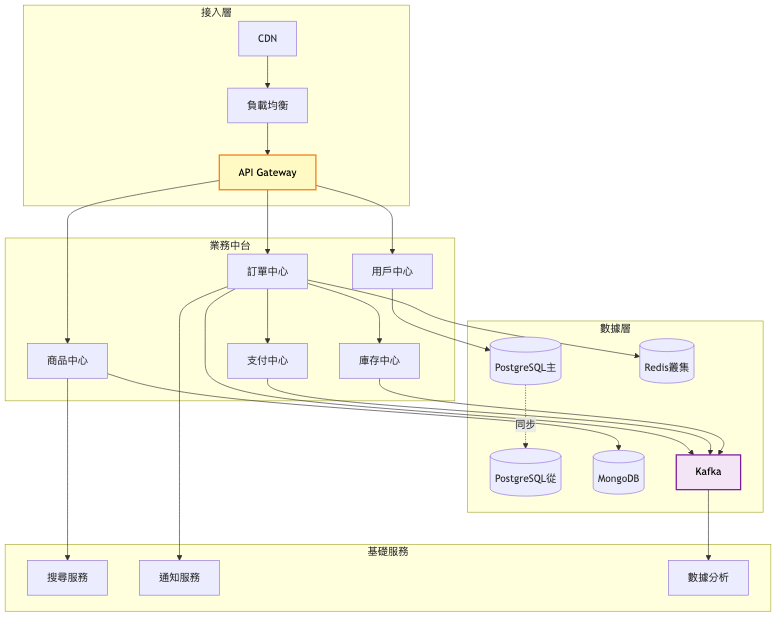

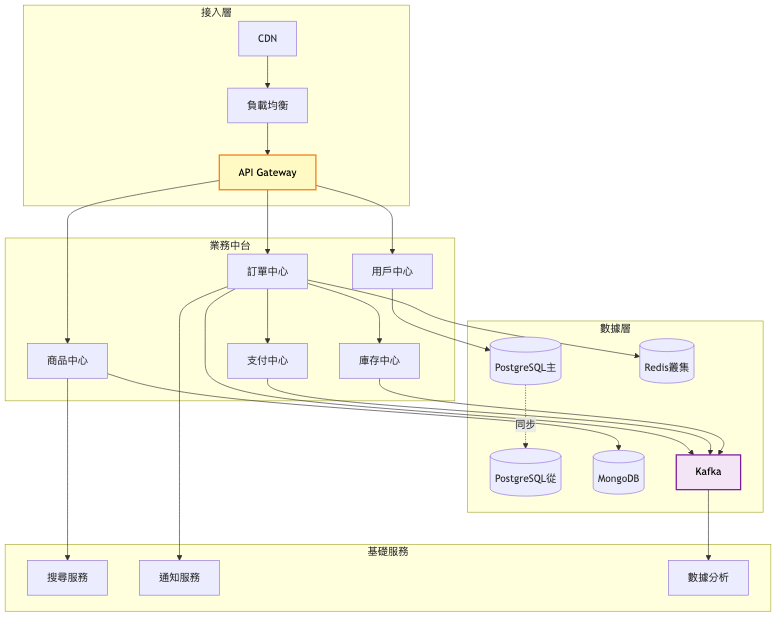

第二階段:成長期(10萬-100萬用戶)

架構重點:

- 服務拆分到10-15個,按業務域劃分

- 引入Service Mesh管理服務間通訊

- 資料庫讀寫分離,分庫分表

- 事件驅動架構處理異步流程

- 分散式追蹤和集中式日誌

系統架構圖:

關鍵架構變更:

-

Service Mesh導入

- 採用Istio管理服務間流量

- 自動重試、熔斷、負載均衡

- 預期延遲降低30%

-

事件驅動架構

- Kafka作為事件總線

- 訂單流程完全異步化

- 系統解耦度提升80%

-

數據架構優化

- PostgreSQL分庫分表,單表不超過500萬

- MongoDB存儲商品詳情

- Redis叢集提供毫秒級快取

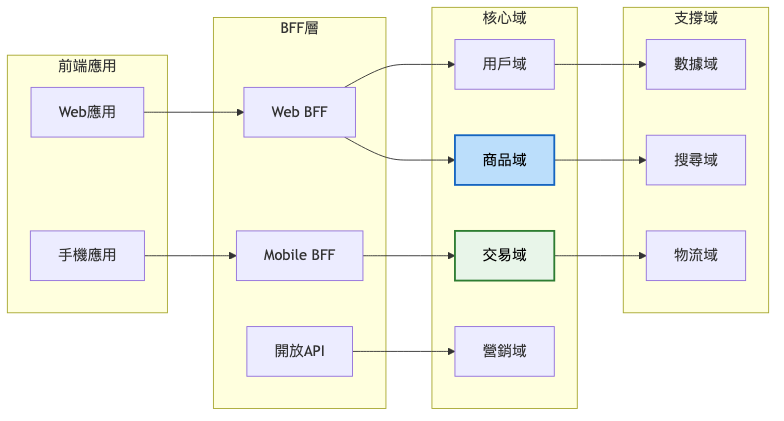

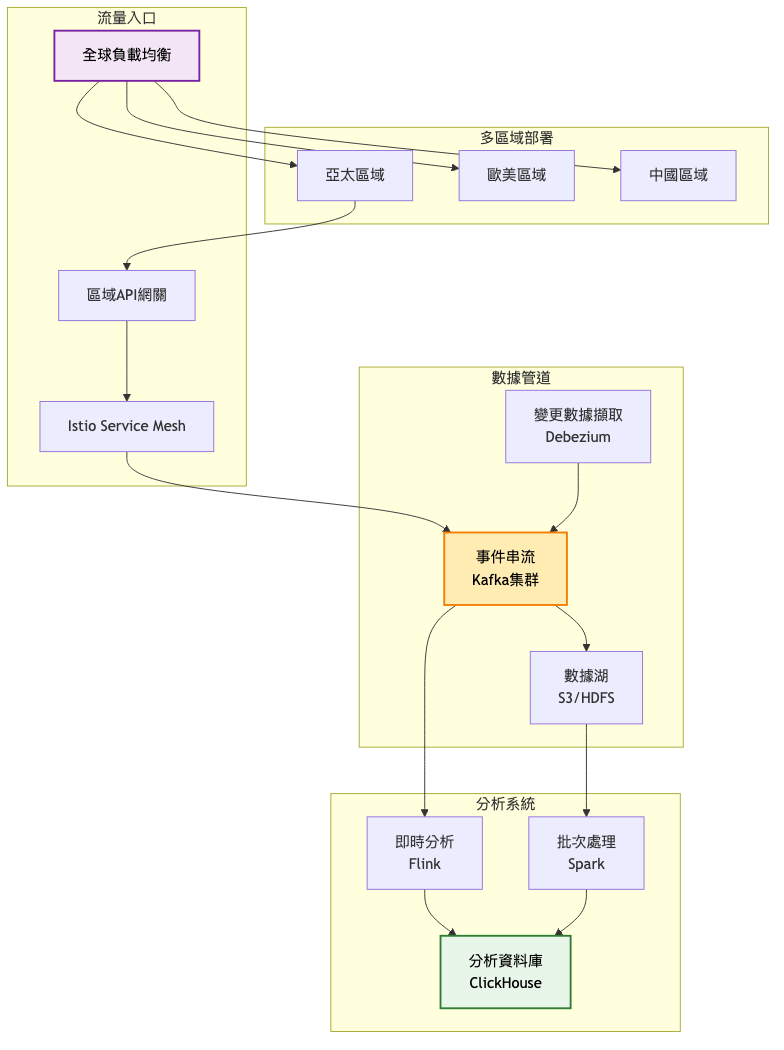

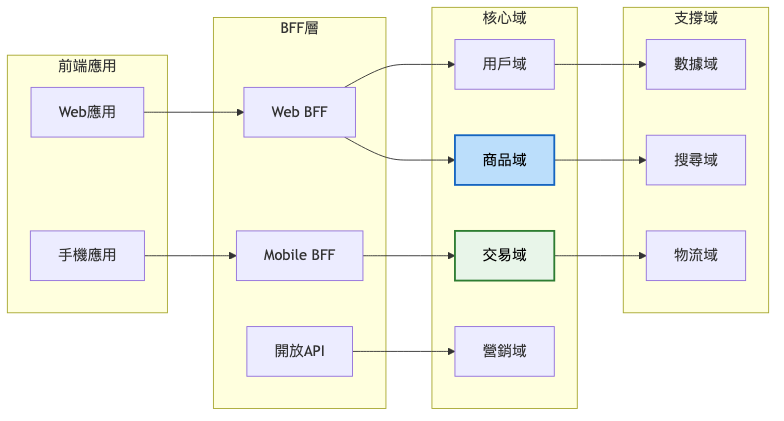

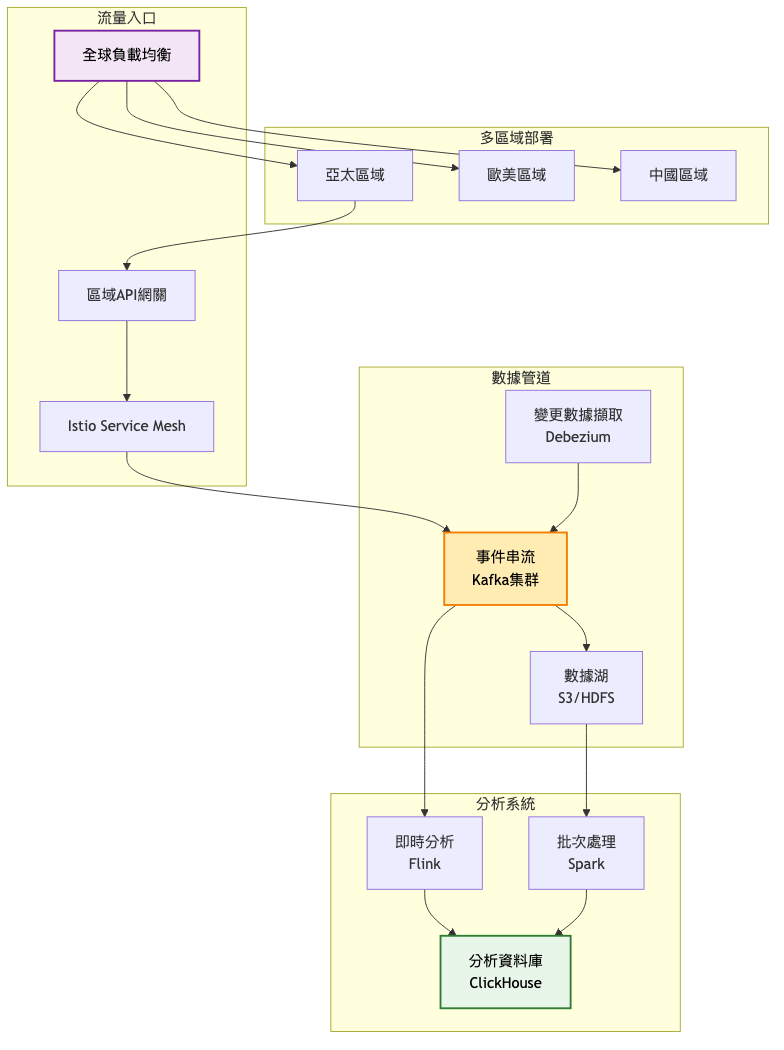

第三階段:規模化(100萬+用戶)

架構重點:

- 完整的領域驅動設計,30+微服務

- 多區域部署,就近服務

- CQRS模式分離讀寫

- 完整的DevOps工具鏈

- AI驅動的智能運維

由於架構複雜度較高,分為三個視圖展示:

總覽圖:服務分組關係

核心交易流程詳細架構:

數據流與部署架構:

演進決策指南表:

| 觸發條件 |

採取行動 |

預期效果 |

| QPS > 10,000 |

引入讀寫分離 |

讀性能提升5倍 |

| 服務數 > 20 |

部署Service Mesh |

運維成本降低40% |

| 日訂單 > 100萬 |

分庫分表 |

資料庫壓力降低70% |

| 跨區域用戶 > 30% |

多區域部署 |

延遲降低50% |

技術選型深度分析

關鍵技術組件比較

| 技術選項 |

優勢 |

劣勢 |

適用場景 |

| REST API |

簡單、標準化、快取友好 |

效能較低、無狀態 |

公開API、簡單CRUD |

| gRPC |

高效能、強類型、雙向串流 |

調試困難、瀏覽器支援差 |

內部服務通訊 |

| GraphQL |

靈活查詢、減少請求次數 |

複雜度高、快取困難 |

前端驅動的API |

| Kafka |

高吞吐、持久化、重播能力 |

運維複雜、延遲較高 |

大數據串流、事件源 |

| RabbitMQ |

靈活路由、低延遲、易用 |

吞吐量較低、叢集複雜 |

任務佇列、RPC |

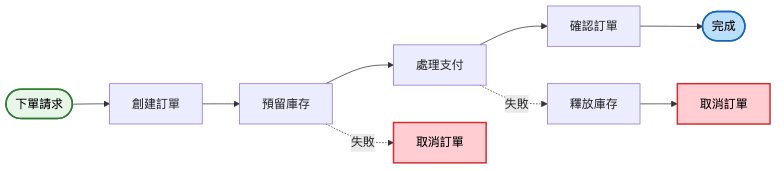

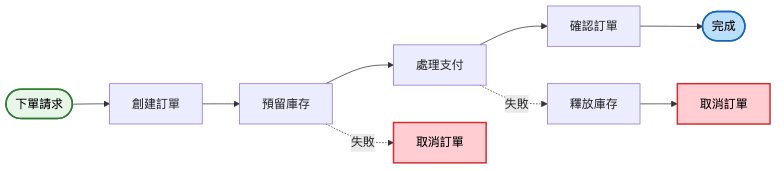

分散式事務處理策略

Saga模式實現訂單流程:

每個步驟都設計為可補償的操作,確保在任何階段失敗都能回滾到一致狀態。

實戰經驗與教訓

常見架構陷阱

-

過度拆分服務

- 錯誤:為每個資料表建立一個微服務

- 正確:按業務能力和團隊邊界拆分

- 原因:過細的服務增加網路開銷和運維複雜度

-

分散式單體

- 錯誤:服務間緊密耦合,同步部署

- 正確:服務獨立部署,向後相容

- 原因:失去微服務的核心價值

-

忽視數據一致性

- 錯誤:假設網路永遠可靠

- 正確:設計補償機制,接受最終一致性

- 原因:分散式系統的CAP定理限制

業界案例分析

案例:Amazon的服務化轉型——從單體到每11.6秒部署一次

參考文章:Werner Vogels談Amazon的SOA架構

參考文章:The New Stack - What Led Amazon to Microservices

-

初期(1995-2001)

- 架構特點:名為「Obidos」的雙層單體應用,前端伺服器與資料庫直接連接

- 技術:C++為主的單體架構

- 規模:所有功能在單一應用中,部署週期長達數週

-

轉型期(2001-2006)

- 主要改進:開始服務化拆解,創建數百個後端服務

- 遇到的挑戰:單體應用已無法擴展,團隊間協作困難

- 解決方案:實施「兩個披薩團隊」原則,每個團隊5-10人,端到端擁有服務

-

成熟期(2006-2025)

- 部署頻率達到每11.6秒一次,年度部署超過5000萬次

- Amazon S3從最初6個微服務演進到超過300個微服務

- Prime Day 2025的驚人數據:AWS Lambda每天1.7兆次調用,DynamoDB每秒1.51億次請求峰值

關鍵學習點

- 服務化原則:Werner Vogels強調「數據和業務邏輯封裝,只通過服務介面存取」,這個決策讓Amazon能夠獨立擴展每個服務

- 團隊自治:「You Build It, You Run It」哲學讓開發團隊對服務品質負全責,顯著提升了系統可靠性

- 漸進式演進:不追求一步到位,而是花費5年時間(2001-2006)逐步完成服務化轉型

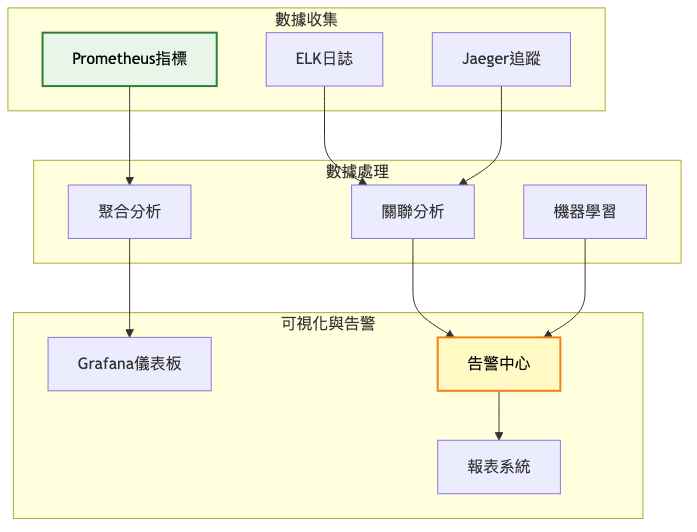

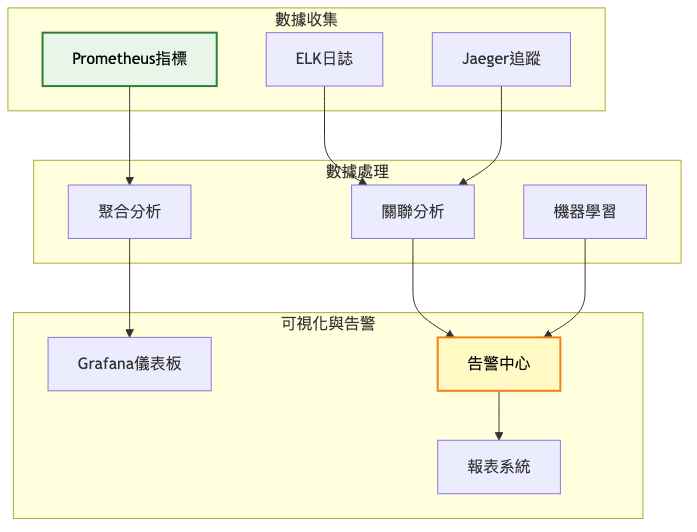

監控與維護策略

關鍵指標體系

技術指標:

- 服務可用性(目標:99.99%)

- API響應時間(P95 < 200ms,P99 < 500ms)

- 錯誤率(< 0.1%)

- 吞吐量(支撐10萬QPS)

業務指標:

- 訂單成功率(> 99.9%)

- 支付成功率(> 99.5%)

- 頁面加載時間(< 2秒)

- 轉換率(> 3%)

可觀察性建設

總結

核心要點回顧

-

業務驅動架構:技術服務於業務,避免過度設計

-

漸進式演進:從單體到微服務需要循序漸進

-

數據一致性權衡:接受最終一致性,設計補償機制

-

組織與技術協同:康威定律決定了組織結構影響系統架構

-

持續優化:微服務不是終點,需要持續演進

設計原則提煉

-

服務自治原則:每個服務擁有自己的數據和業務邏輯

-

失敗設計原則:假設一切都會失敗,設計容錯機制

-

演進優於革命:小步快跑,持續改進

-

監控先於功能:可觀察性是微服務的基礎

-

標準化通訊:統一的API規範和通訊協議

下期預告

明天我們將探討「全球CDN系統」的設計。當你的電商平台擴展到全球市場,如何確保世界各地的用戶都能獲得快速的訪問體驗?如何設計一個能夠處理PB級靜態資源、支援動態內容加速、具備DDoS防護能力的全球內容分發網絡?這些挑戰將在明天的文章中深入剖析。

參考資源