在 Day 18,我們聊了 Notion AI 如何幫我在「收集 → 整理」的階段減少負擔。但是,再厲害的 AI,也需要有資料來源。如果輸入不夠乾淨、不夠完整,那 AI 生成的結果還是有限。

這就引出了今天要跟大家分享的 —— n8n,它不只是一個工具,而更像是「資訊搬運工 + 自動化助理」。它能把我生活和工作中的碎片訊息,搬進 Notion,讓筆記真正變成「動態知識中樞」。

如果要簡單形容 n8n,它是一個能讓資料自動流動的管線工具。

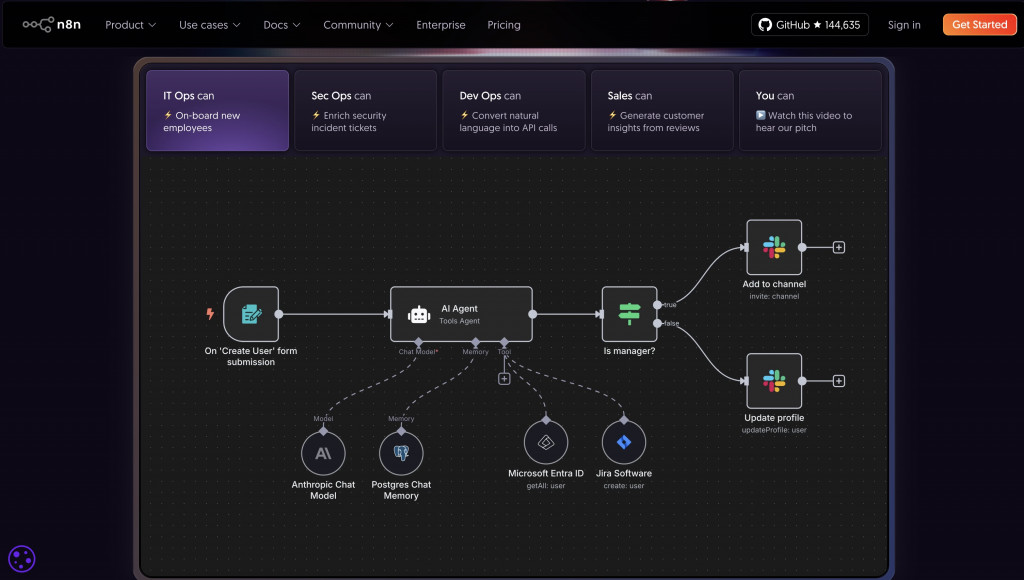

還記得我第一次接觸 n8n,是在公司的一場 AI Hackathon,看到畫面上滿滿的「節點 (Node)」和「箭頭 (Flow)」:

把它們串起來,就能把資料自動搬到 Notion Database。

這很像我們在 Data Engineering 裡做的 ETL Pipeline,只是 n8n 是一個「低程式碼版」,讓更多人能輕鬆建立資訊流。

我開始想:如果把 n8n 當成資訊的收集器,把 Notion 當成知識的中樞,會不會改變我的工作方式?以下是幾個我特別有感的應用場景:

我的信箱每天都有一堆電子報:AI 趨勢、產業分析、投資快訊。大多數時候,我沒時間馬上看完,結果很快就被淹沒在信箱。

透過 n8n,可以設定:當 Gmail 收到特定標籤的郵件 → 自動新增一筆 Notes DB → 放進 Inbox。

這樣每週回顧時,不用翻郵件,只要打開 Notion,就能看到完整的電子報清單。

作為 Data Engineer,我經常需要追蹤 Medium 技術文章或 GitHub Repo。過去的情境是:看到連結 → 存到書籤 → 然後常常就忘記了。

過去只能「先存書籤,之後再看」,但很容易忘掉。

現在透過 n8n:RSS Feed → Notion Knowledge DB,自動建立一筆知識條目(含連結),狀態標註成 Unread。

週末的時候,我就能打開 Knowledge DB,看到一份乾淨的「知識清單」,不會漏掉。

投資與經濟判斷需要大環境資訊,但每天滑新聞太花時間。這時就可以用 News API,搭配 n8n,每天早上把國際大事推送到 Notion。

舉例:當某個國際事件可能影響科技產業,可以幫這則新聞加上「Economy」的 tag,後續就能和我的 Finance Tracker 串起來。

當我在找新機會時,n8n 可以自動抓 LinkedIn 或 104 的職缺資訊,過濾出相關的工作,並新增到 Career DB。

這樣我就能在 Notion 裡面做「履歷對應度分析」,而不用每天花時間手動搜尋。

在 Day 17 我們說過,Notion DB 是知識管理的核心。但光靠手動輸入,資料永遠是「靜態」的。n8n 的角色就是:讓資料持續流動,保持新鮮。

換句話說,n8n 讓 Notion 從「靜態的筆記本」升級成「動態知識中樞 (Dynamic Knowledge Hub)」。

而 LLM 的價值,也因為有了乾淨且不斷更新的資料源,而真正被釋放出來。

[ 多方來源 ]

├── Email / 電子報

├── RSS / 技術文章 / GitHub

├── News / 國際大事

├── Job Board / LinkedIn

├── 健康 / 財務數據

│

▼

[ n8n Workflow ]

│

▼

[ Notion DBs ]

├── Notes DB

├── Knowledge DB

├── Career DB

├── Tracker DB

│

▼

[ SQLite / ChromaDB ]

│

▼

[ LLM 檢索增強:搜尋 / 問答 / 自動摘要 / 決策輔助 ]

今天我和大家分享了 n8n 與 Notion 的結合:

它不只是把筆記自動化,而是幫助我把生活、工作、學習的「資訊流」匯聚在一個地方。

這對於一個每天需要吸收大量資訊的我來說,非常的有幫助:

我不用再怕漏掉新聞或技術文章;

我能用更乾淨的數據做分析;

甚至連找工作也能更有效率。

💡 我想留給你的一個思考是:

「如果把你每天重複收集的資訊交給自動化處理,你能省下多少時間,專注在真正重要的事情上?」

在 Day 20,我會帶大家使用 n8n實作一個workflow,讓自動化的力量更直觀地展現出來。