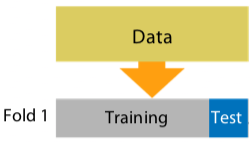

. Holdout

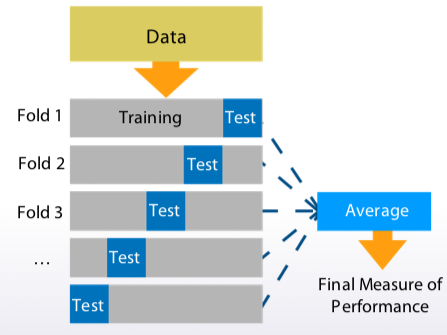

. K-fold

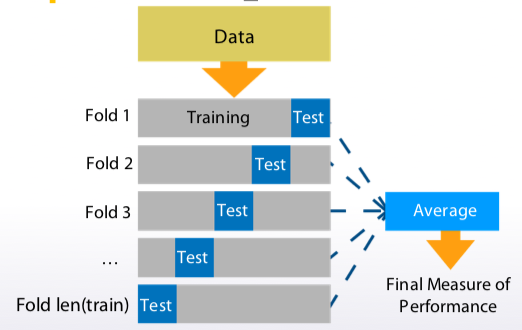

. LOO / Leave-one-out

ngroup=1

sklearn.model_selection.shuffleSplit

截圖自coursera

ngroups=k

sklearn.model_selection.kfold

截圖自coursera

ngroups=len(train)

sklearn.model_selection.LeaveOneOut

截圖自coursera

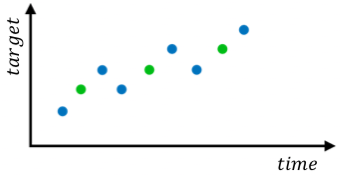

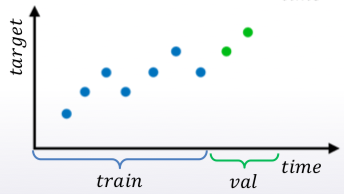

採用交錯或時間序列的判斷是找出競賽出題者的方式, 直接複製出題者是用哪一種, 這樣對 model 效果最好

| Previous and next target values | Time-based trend |

|---|---|

|

|

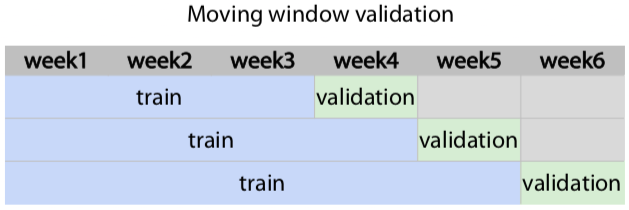

下表是 4 種切割 train, validation 方法, 建議找出並模仿題目的資料切割方法

| Random, rowwise | Timewise | By id | combinations |

|---|---|---|---|

|

|

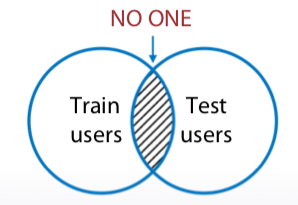

問題 :

對策 : 採 K-fold / K折(通常折5個)資料集, 取每個資料集為平均分數的結果

後言 : 已經接近一半, 所以今天也開始找 Kaggle 比賽, 要開始一步步照著課程實作.(cross my fingers)