參考資料

1. Adagrad、RMSprop、Momentum and Adam – 特殊的學習率調整方式

2. [ML筆記] Tips for Training DNN

3. 李弘毅的ML講義

4. Sigmoid function 的数学原理

#參考資料的說明清楚到我無法再更清楚說明...因此以下貼出最具代表性解釋的截圖。

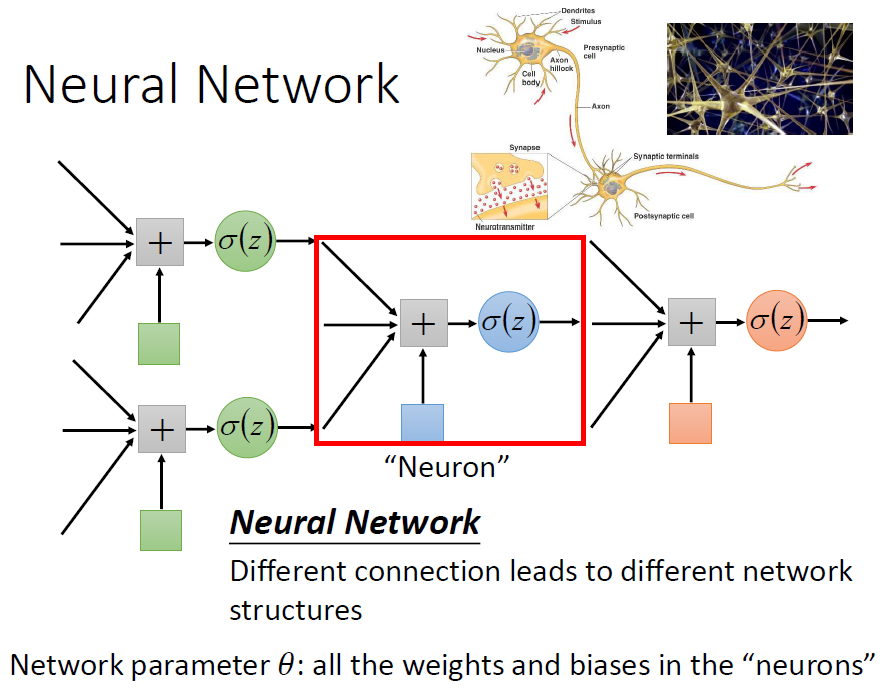

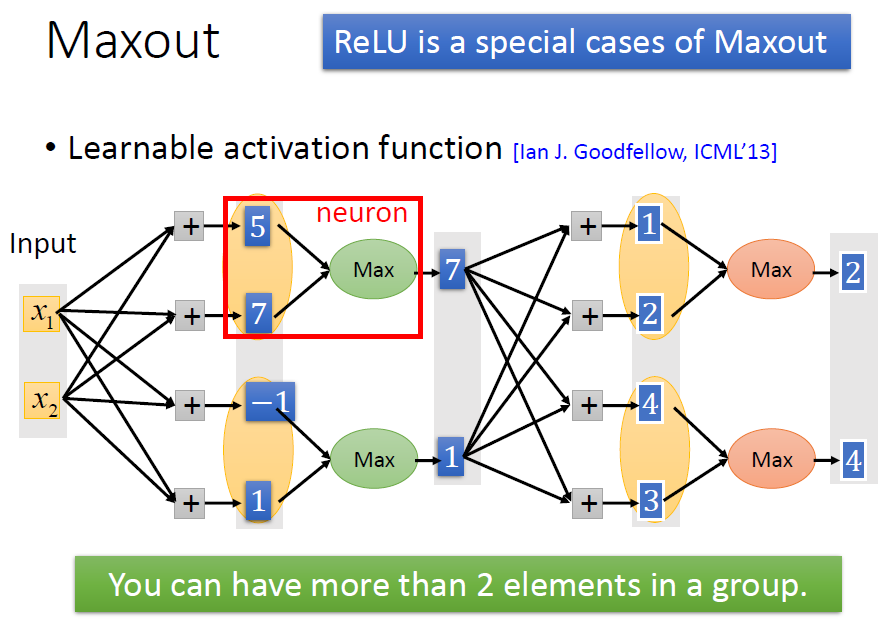

• Neural Network 的原理與架構:Neuron(神經元)、Perceptron(感知器)

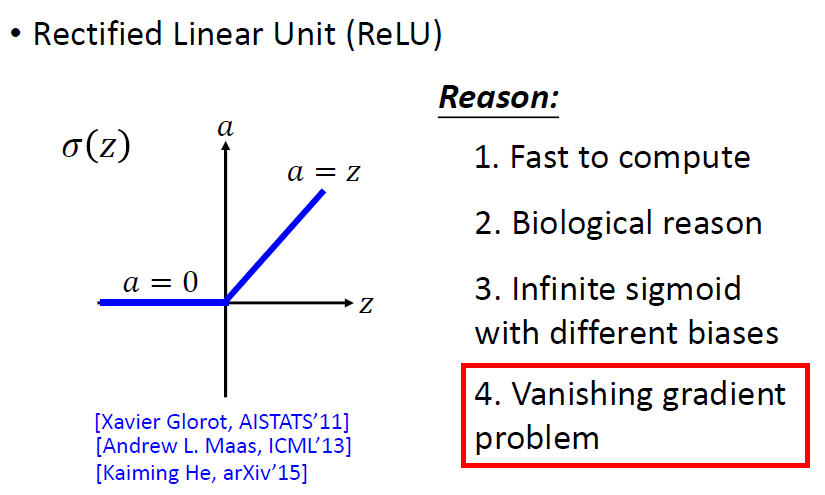

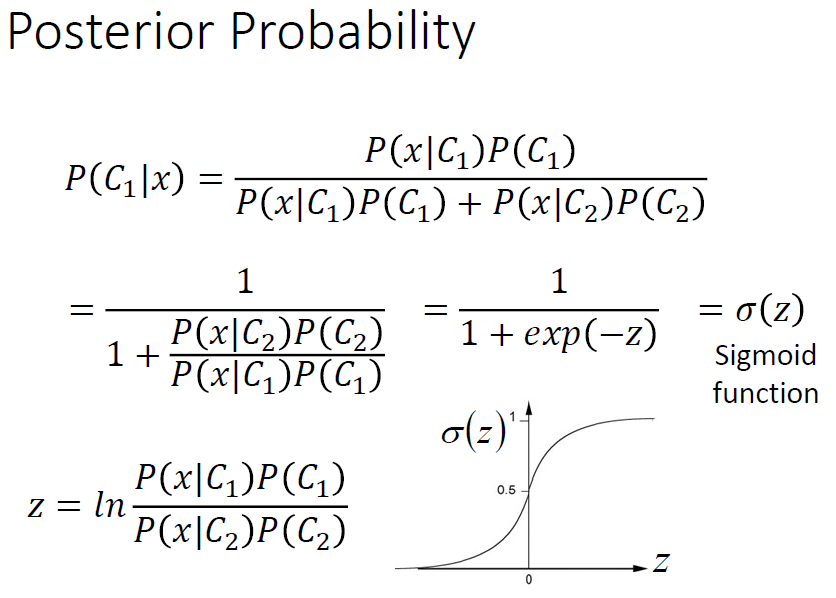

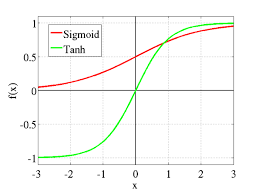

• Activation Function(激勵函數): Relu、Sigmoid、tanh…

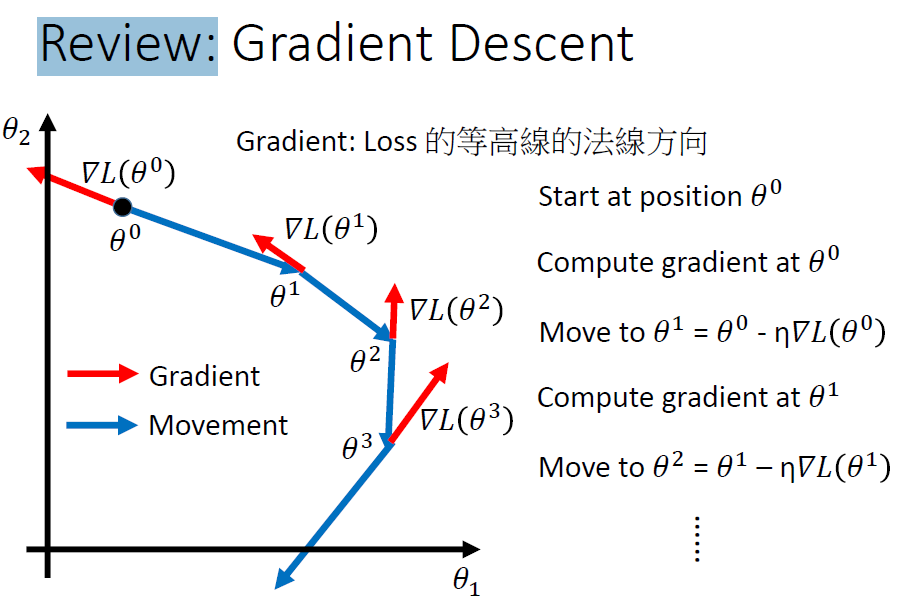

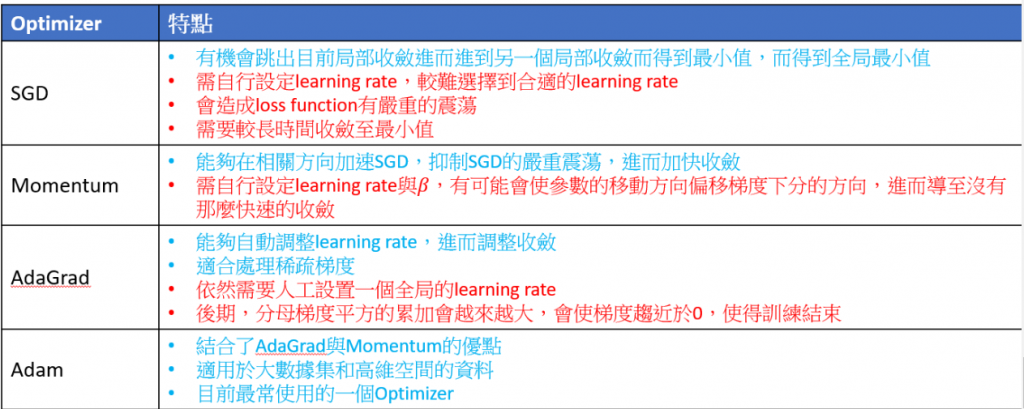

• Optimization(最佳化):線性回歸、Gradient Descent(梯度下降法)、SGD(隨機梯度下降法)、Momentum(動量法)、Adam(適應性矩估計)…

SGD 也就是最單純的gradient decent 方法,找出參數的梯度(利用微分的方法),往梯度的方向去更新參數(weight)

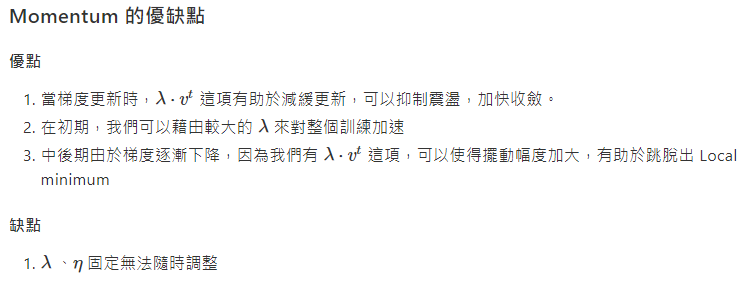

Momentum — 跳脫出 Local minimum 的困境

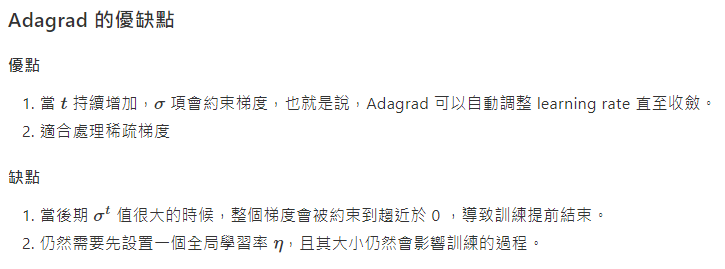

Adagrad — 彈性使用 Learning Rate

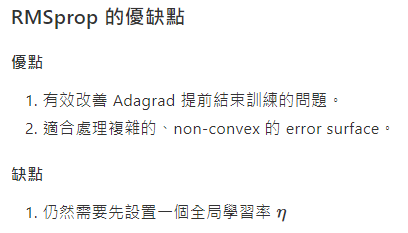

RMSprop — 處理複雜 error surface

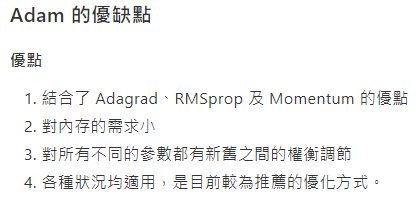

Adam — 目前常用的Optimizer

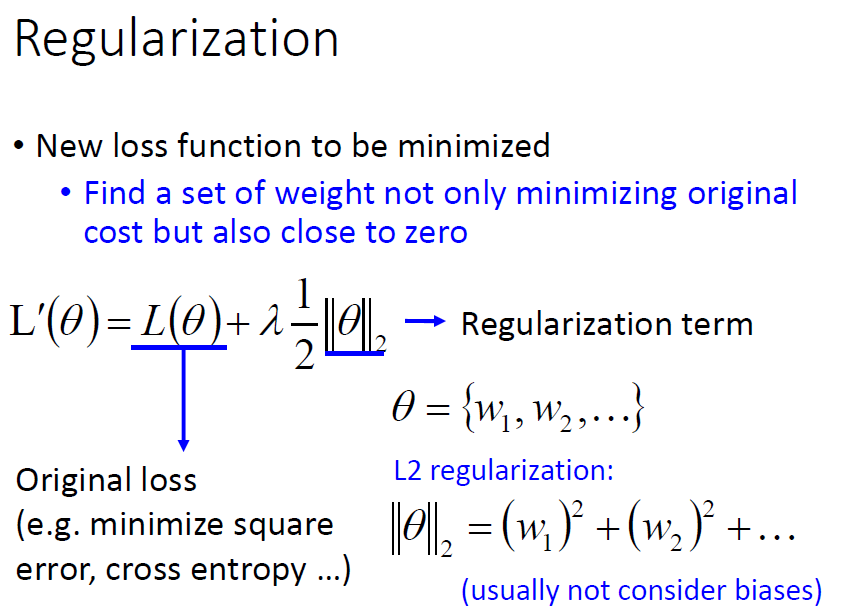

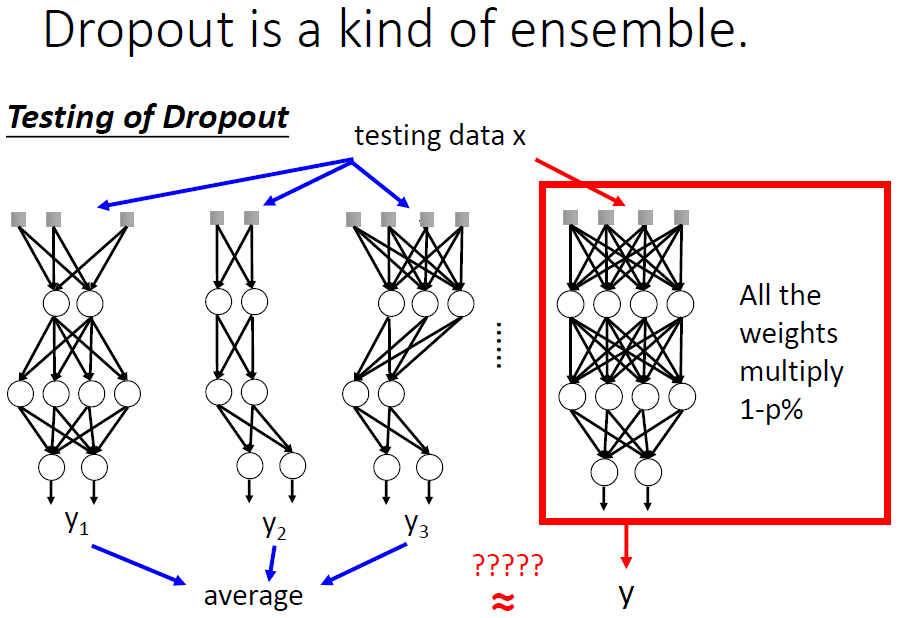

• 過擬合(Overfitting)處理:Dropout、Regularization

#在 training data 夠好,但是在 testing data 上結果不好的話

• 存入與讀取模型(model)與權重(weights)

參考: Day 04:關於 Keras 的一些小技巧 -- 組態、模型存檔與實驗

• 主題實作:神經網路實作、MNIST手寫數字辨識、CIFAR-10實作、乳腺癌診斷分析