參考資料

1. 李弘毅的ML講義

2. [ML筆記] Recurrent Neural Network (RNN) - Part I Part II

3. Day 23:銷售量預測 -- LSTM 的另一個應用

4. [ML筆記] Why Deep ?

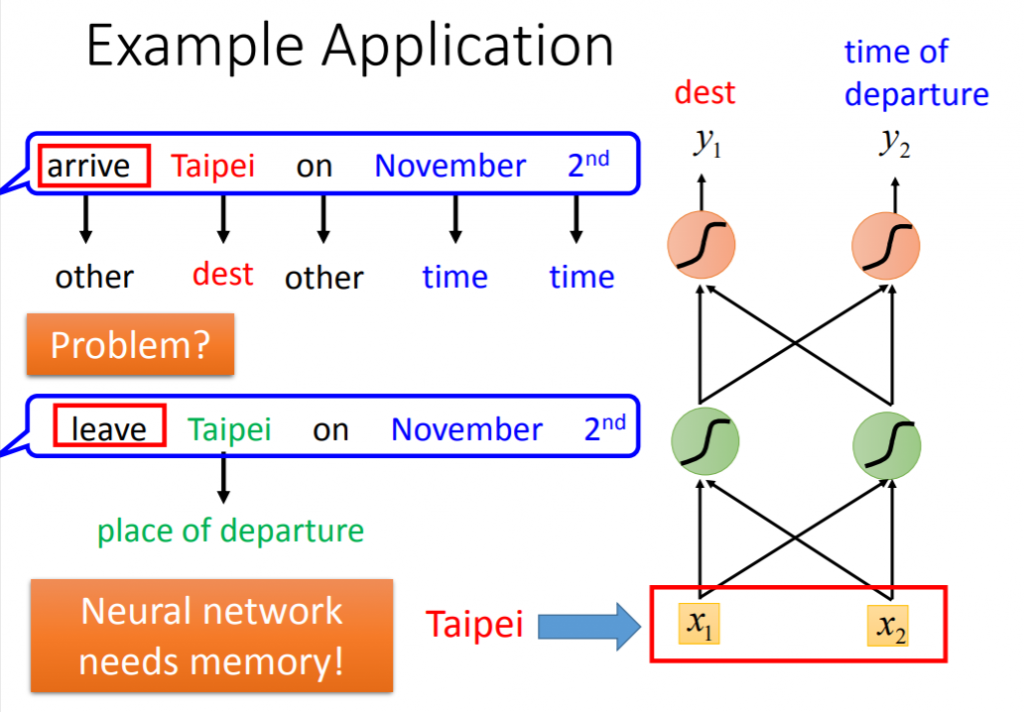

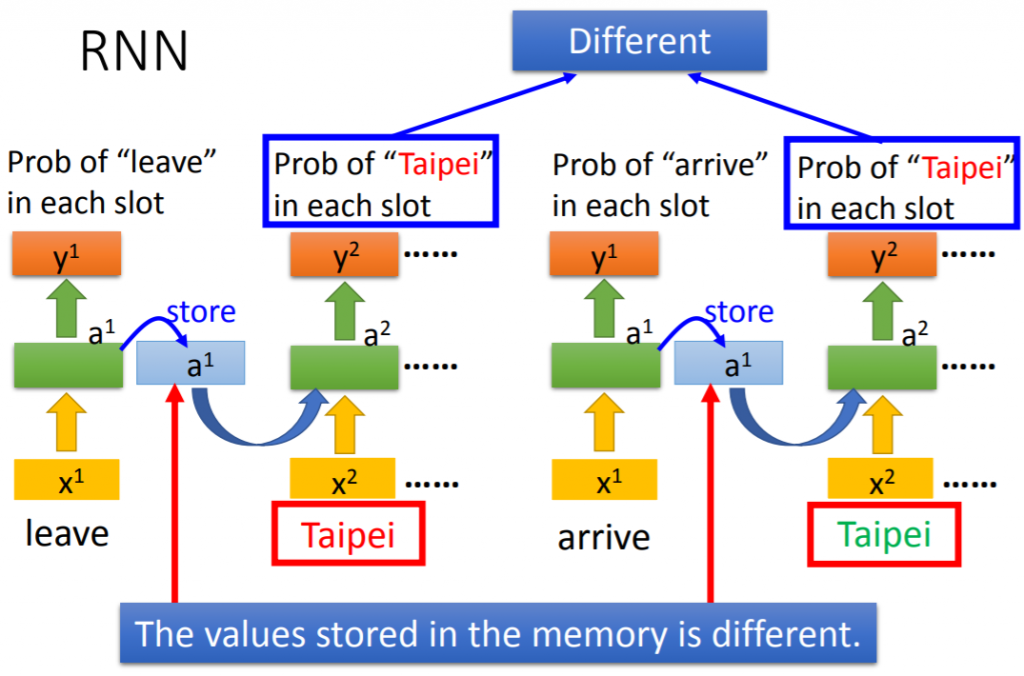

• 原理與架構說明

#有其他長相的: Elman Network & Jordan Network & Bidirectional RNN

RNN就只是多一個儲存位置,用來暫存上一次的值?那如果要記得的值不是要取上一個呢?

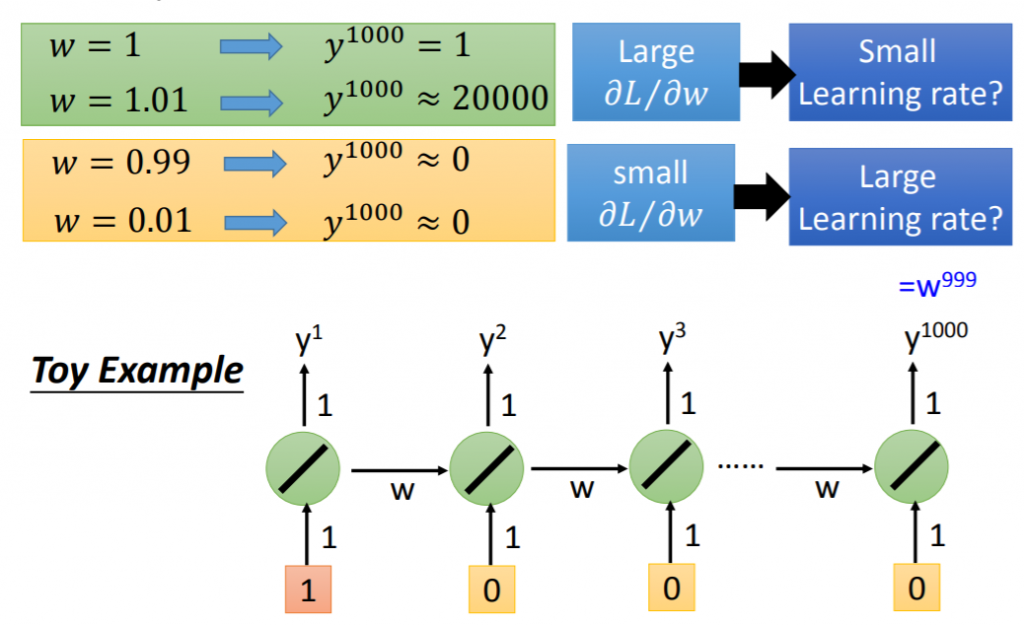

• Gradient Vanish(梯度消失)

RNN-based network is not always easy to learn.

The error surface is rough.

由舉例得知“w 在 0~0.99 之間變化,可能完全沒有造成影響;但 w 超過 1 後,只要一有影響,就是巨大的影響”

也就是會發生Gradient Vanish(梯度消失)或梯度爆炸的問題

#RNN中容易出現Gradient Vanishing是因為

1.在梯度在向後傳遞的時候,由於相同的矩陣相乘次數太多,梯度傾向於逐漸消失,導致後面的結點無法更新參數,整個學習過程無法正常進行

2.不適當的激活函數sigmoid,可改用relu或maxout

#而梯度爆炸的部分: 有一種暴力的方法就是,當梯度的大小超過某個閾值的時候,將其縮放到某個閾值

(或以下說明也可以改善Gradient Vanish)

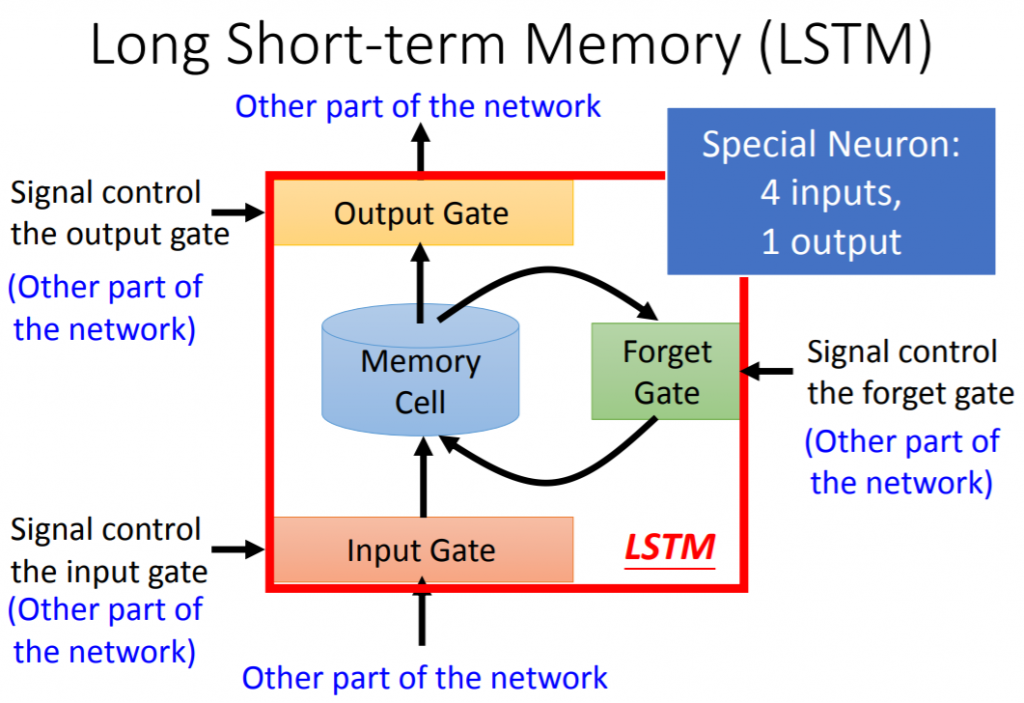

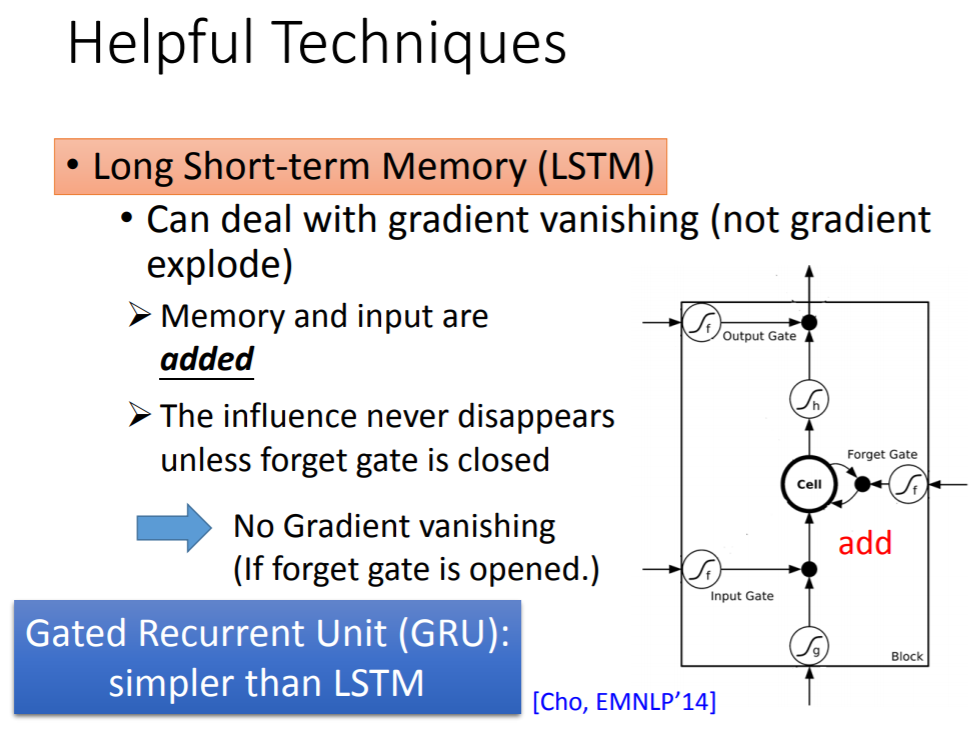

• LSTM(Long Short-Term Memory)模型說明

當然還有其他有幫助的技術: Gated Recurrent Unit (GRU) 、Clockwise RNN 、Structurally Constrained Recurrent Network (SCRN)

• Early Stopping

目的: 在overfiting之前停下來,避免model weights被搞爛

參考: Learning Model : EarlyStopping介紹[轉錄]

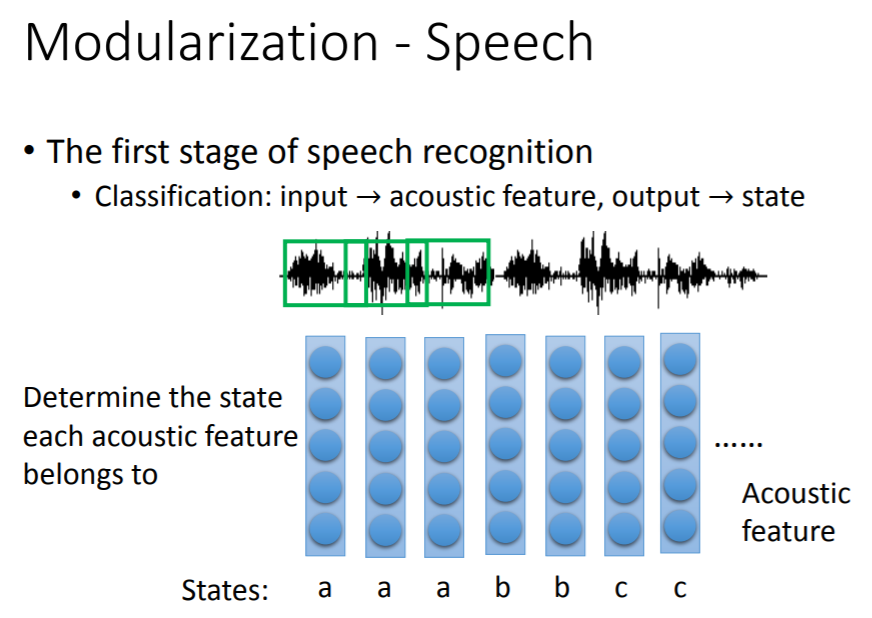

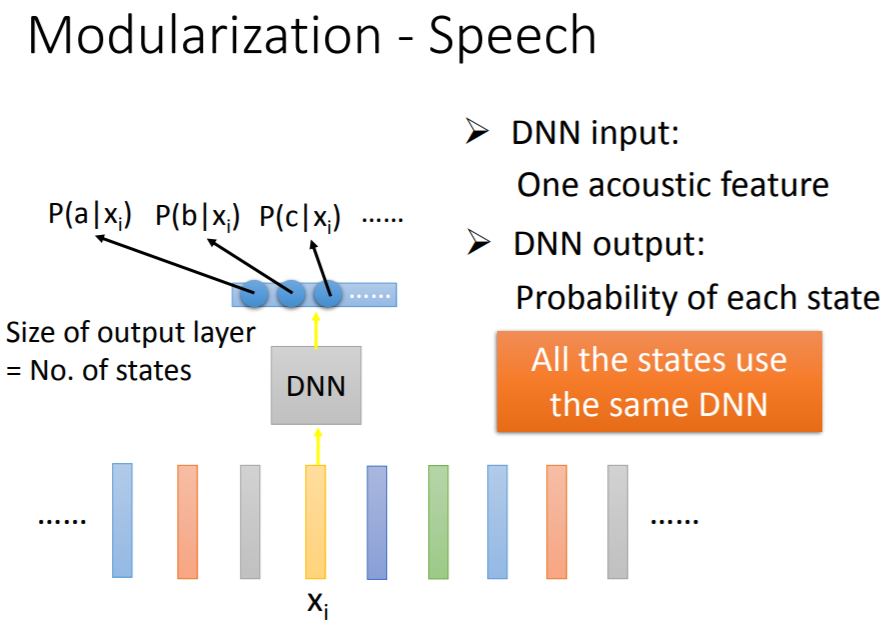

• 應用說明:時間序列(Time series)、詞向量(word vector / word embedding)、自然語言處理(Nature language processing)、語音辨識

• 主題實作:美國國際航空乘客量分析、情緒分析、中英翻譯