參考資料:

#因為其實沒有很懂本課程的原理說明是啥,因此先來簡介一下Transfer Learning:

在2016NIPS講座上,吳恩達表示:在監督學習之後,遷移學習將引領下一波機器學習技術商業化浪潮。

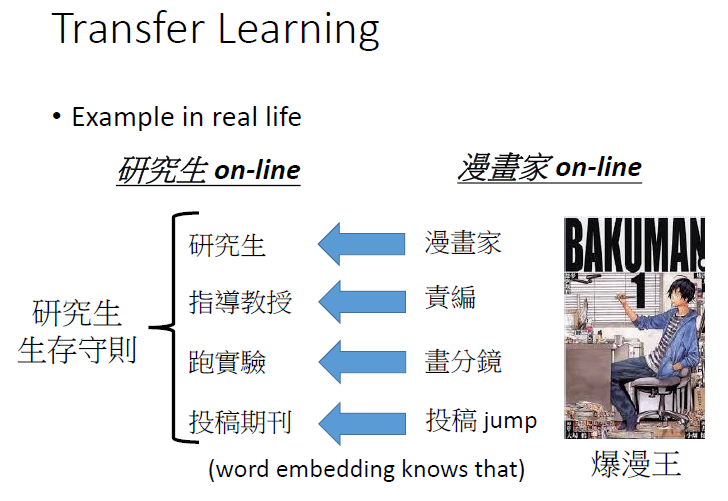

而甚麼是遷移式學習(Transfer Learning)?

(敘述ㄉ說法)

如果我們想要訓練出一個模型,對夜間的行人影象進行監測,我們可以應用一個相近領域的訓練模型——白天的行人監測。理論上這是可行的。

但實際上,模型的表現效果經常會大幅惡化/崩潰。這很容易理解,模型從白天訓練資料獲取了一些偏差,不知道怎麼泛化到新場景。

或想監測自行車騎手,重複使用原先的模型是行不通的。關鍵原因:不同任務的資料標籤不同。

但有了遷移學習,我們能夠在一定程度上解決這個問題,並充分利用相近任務/領域的現有資料。

(簡略ㄉ說法)

假設一個CNN架構,input是阿貓阿狗,我們把Conv layers train好的weight固定;現在input改老虎獅子,只train後面重組的fully connected layers,像是將後面的classifier 變成regressor。

(ML講義)

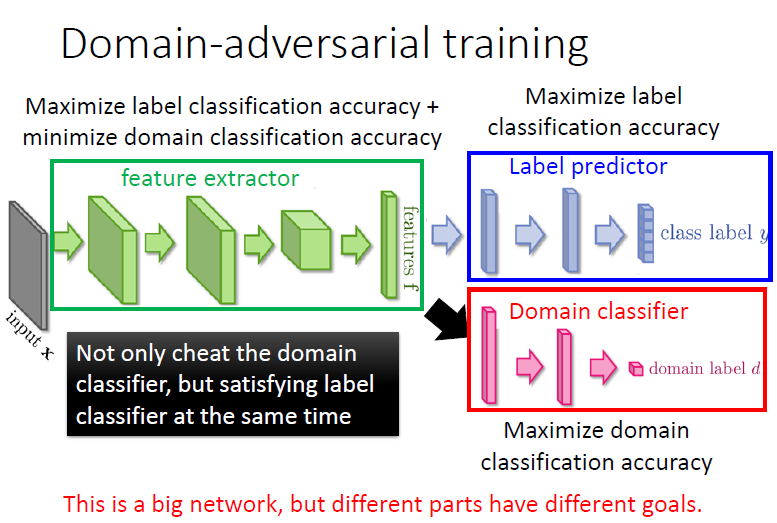

• 原理說明:Keras後端函數應用、反轉梯度

參考: Keras backens函数

參考: 梯度反转

• 主題實作:梵谷畫作風格轉換