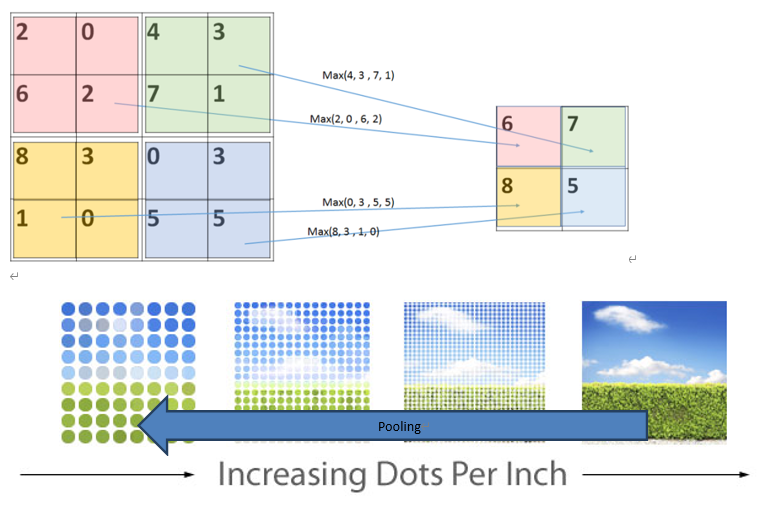

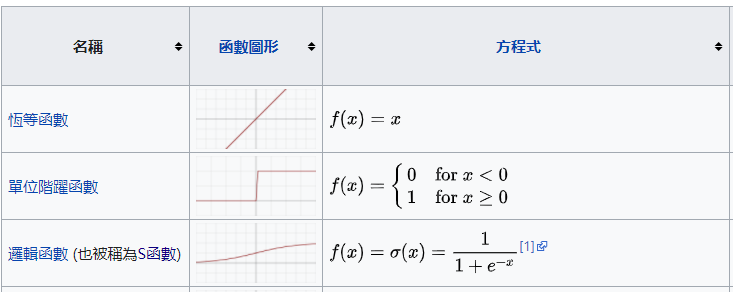

影像的spatial information不會因scale而消失,所以加入pooling layer來減少運算量。

在此階段,數據大小會大幅降低。

以Max Pooling為例,它會將4格方格內之最大值取出,並捨棄其餘三者。其方式與convolution有點相似。

Pooling Layer的目的就是要進行降維,將整個數據量壓小,讓整個模型參數量可以在下降,避免訓練的時候overfitting。

有關Full Connection , 請參考我的另一篇Day 14 - 神經網絡(D)NN 到 卷積神經網絡CNN (1)

即經典的MLP(Multi-Layer Perceptron) layer,最後輸出10維即為對應數字的機率

Flatten的運作方式很簡單,就是將二、三維數據攤平,簡化為一維數據(想像將一張20*20的圖片拉成長為400的線)。

Flatten的目的是將CNN與DNN做銜接,通過此步驟後,就可以進行DNN了!

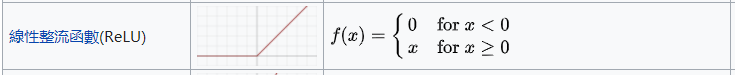

(wiki)將數據帶入一特定函數中,以改變其值。

簡單如---

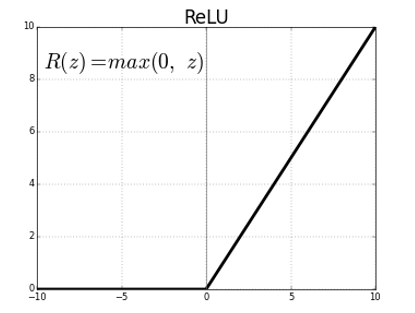

Relu為例:

Activation Function的目的是將數據做調整,以改變訓練時間、結果。