week 1 是 亞歷珊卓主講, 看了一個禮拜, 一次又一次反覆的看著, 聽者俄式英文加上不僅神似 NPH (Neil Patrick Harris in how i met your mother), 連動作, 表情, 手勢都讓我不禁聯想他們是否為親戚. 總之我很高興第二週換迪米崔, 是有點像羅斯(Friends/六人行影集的nerd)啦, 期待下一週不要像第一週這麼慌亂, 有幾天是在神智不清下完成的, 要再等有空時來慢慢修正. 因為...開學了.....言歸正傳, 今天是 text, image 的資料處理 part 2, Word2Vec 一樣是把文字變向量, 但是 pretrain model 的特性讓功能更強大, 對了文字還是 focus 在英文, 因為主流競賽是以英文為主, 圖像會談到一點 CNN.

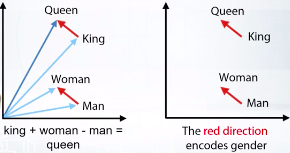

詞嵌入 embeded, w2v 跟 BO W一樣是文字轉向量, 但是 w2v 是 nearby words, 且向量間可以加減運算關係後得出正確詞語. 例如常見的 king + woman - man = queen

截圖自coursera

Words : Word2Vec, Glove, FastText, etc

Sentence : Doc2vec, etc

比較 BOW 跟 w2v

| bag of words | Word2vec |

|---|---|

| Very large vectoer | Relatively small vectors |

| Meaning of each value in vector is known | Values in vector can be interprested only in some cases |

| The words with similar meaning often have similar embeddings |

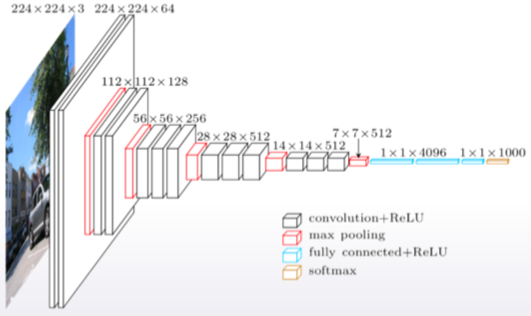

CNN (convolutiontional neural network)

VGG-16 架構

截圖自coursera

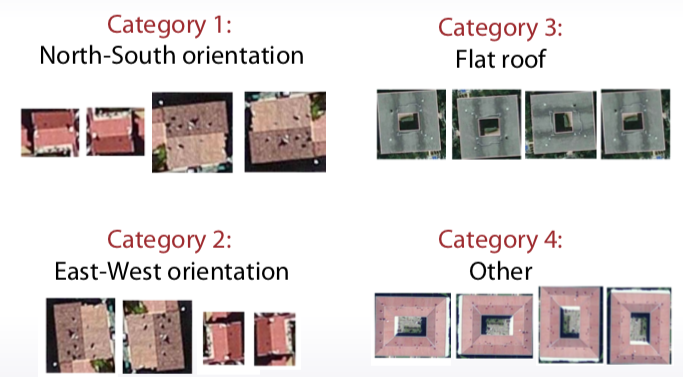

Finetuning example, 擴增 (image augmentation)

截圖自coursera

Lowercase, stemming, lemmarization, stopwords

大向量

Ngram 可以用在本地文檔

TFiDF 可用在預處理階段

相對小向量

pretrained models