參考網站1參考網站2 參考網站3

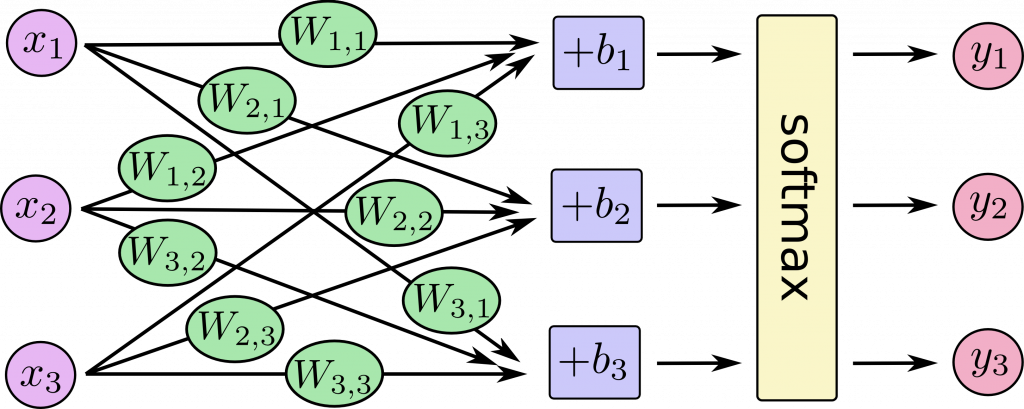

輸入層與一個隱藏層和輸出層示意圖

下圖的GIF可以了解,資料從輸入層經過重組再進入了兩個隱藏層(ReLu與Logit),最後到輸出層藉由softmax輸出結果再由Gradient descent開始回推修正隱藏層的權重,不斷反覆這個循環找出最接近的權重W與bias,所以就叫做Tensorflow(張量流)。softmax功用可以點進連結看,簡而言之它的功用是算出機率y1,y2,y3(y1+y2+y3=1),然後取最大的那一個作為輸出結果。

今天光是看懂這張圖已經費盡心思,明天來了解如何用Gradient descent與反向傳播找出權重的數學原理