在知道ML的應用和基礎,如何實際上陣面對現實問題仍需要讓ML模型在學習中不斷進步,因此我們需要能有評估效能的方法,並利用loss function作為梯度下降等演算法的依據不斷優化模型。

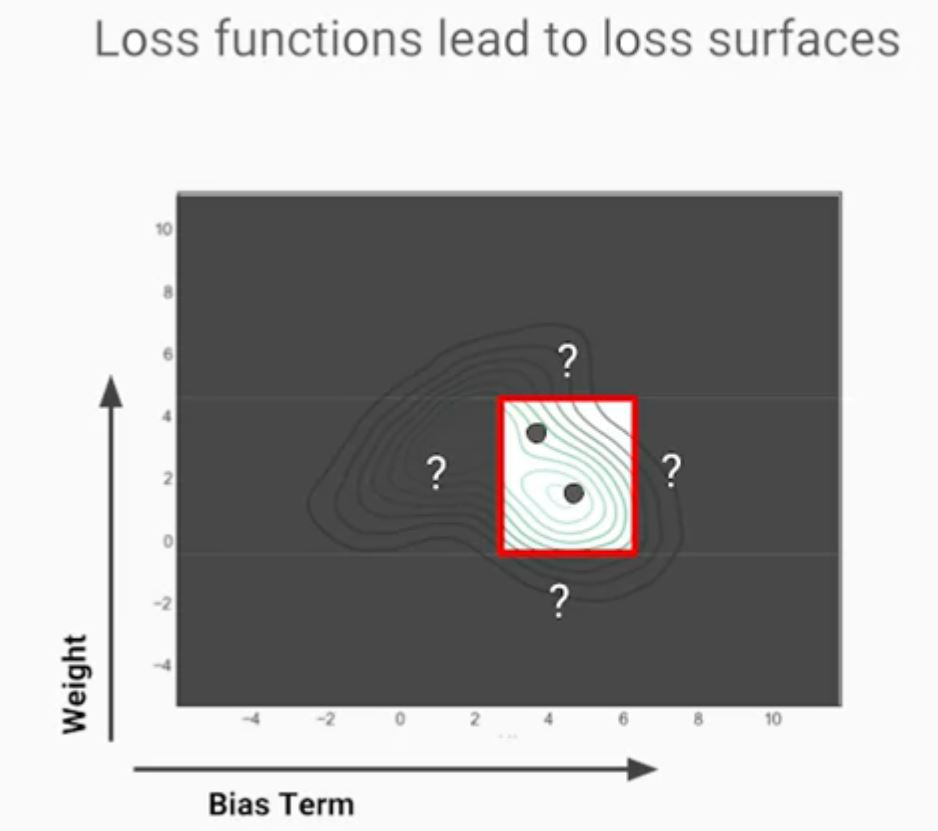

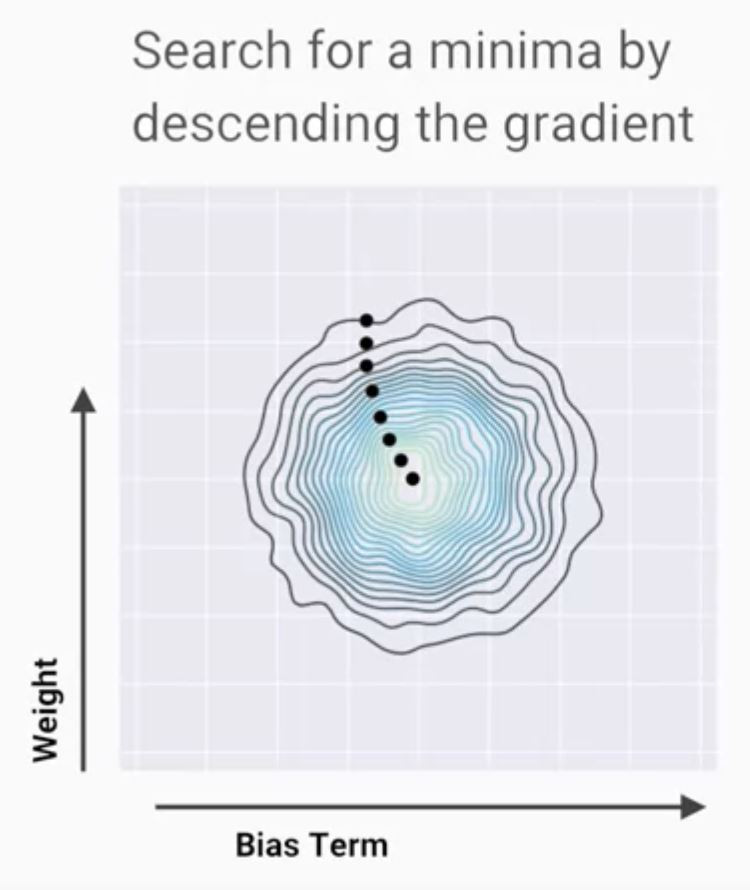

我們定義loss function做為我們優化模型的指標,因為以一個三維空間的山谷模型來看,谷底是我們最佳的答案則

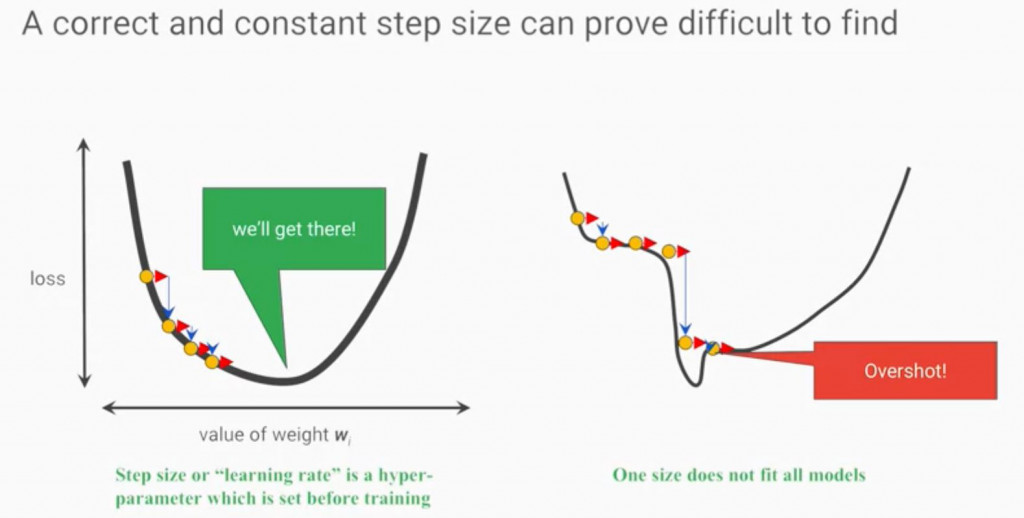

我們該往哪走?一步走多遠?引入微積分梯度的基礎概念與數學運算,則梯度下降(Gradient Descent)方法誕生引領我們找到答案

當然這是最陽春的方法,勢必有不少挑戰仍要修正,走錯路也是有可能,跑太快也是(像下圖)