今日大綱

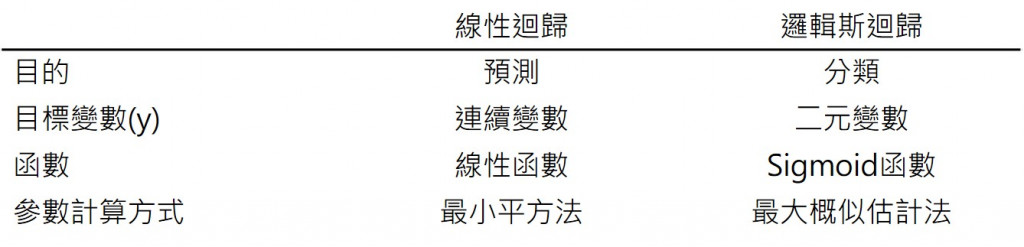

邏輯斯迴歸為線性迴歸的變形,其經過sigmoid function的轉換,讓目標變數(y)的範圍所小至0-1之間。Sigmoid function又稱logistic function,經過轉換所得到的值為機率,進一步判斷是否高於或等於0.5,如果高於或等於0.5,那預測值就為1;反之,則為0。分類的門檻值(threshold)通常使用0.5當分界,如果想改變門檻值可以利用dataframe篩選資料,想了解的朋友可以參考Define threshold of logistic regression in Python。

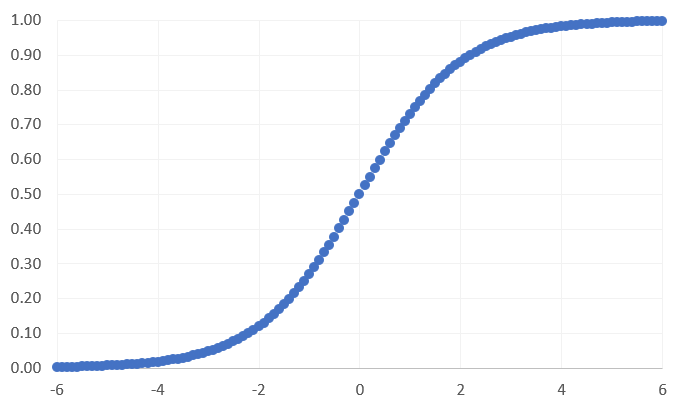

下圖為sigmoid function,當x為0時,所得到的預測值為0.5。

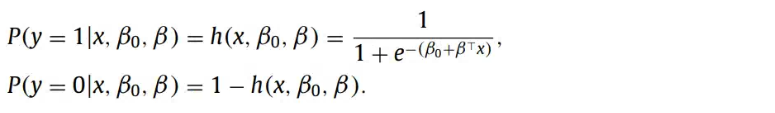

邏輯斯迴歸方程式 (Gambella et al., 2021) 如下:

e 指的是指數,beta 與beta0 分別代表各個特徵的係數與截距項,h 為sigmoid function。

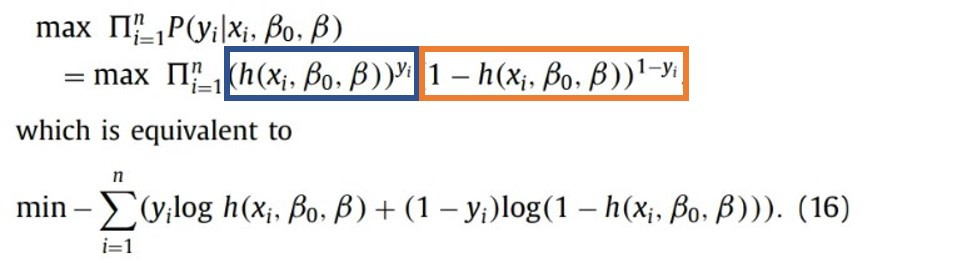

不同於線性迴歸,邏輯斯迴歸無法計算誤差,需利用最大概似估計法將每個資料點的概似值相乘,得到最適合的模型,其數學式 (Gambella et al., 2021) 如下:

藍色框框所計算的是y=1的概似值,而橘色框框所計算的則是y=0的概似值。

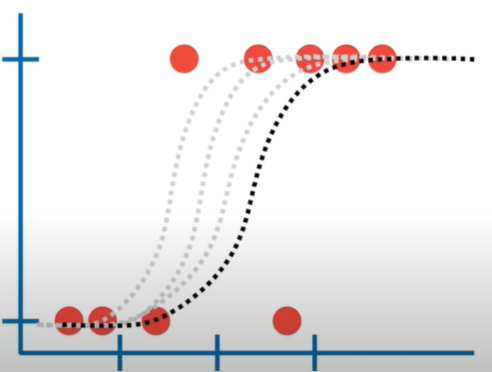

下圖為最大概似估計法的解說圖,資料來源為StaQuest,一開始會模擬出一個模型,並且計算這個模型的概似值後,接著找下一個可能的曲線,當概似值為最大時,其為最佳解。

感謝您的瀏覽,我們明天見!☺